Twitter 上發(fā)現(xiàn)了一篇Hinton的新論文,作者只有Hinton本人,這篇論文沒(méi)有介紹具體的算法,而是描繪了一個(gè)關(guān)于表示的宏觀構(gòu)想:如何在神經(jīng)網(wǎng)絡(luò)中表示部分-整體層次結(jié)構(gòu)。

AI科技評(píng)論在Twitter 上發(fā)現(xiàn)了一篇Hinton的新論文,作者只有Hinton本人,這篇論文沒(méi)有介紹具體的算法,而是描繪了一個(gè)關(guān)于表示的宏觀構(gòu)想:如何在神經(jīng)網(wǎng)絡(luò)中表示部分-整體層次結(jié)構(gòu)。

值得一提的是,分享論文的Kosta Derpanis也在推特里介紹了Hinton的第一篇論文:“Using Relaxation To Find A Puppy”。Kosta Derpanis在論文里標(biāo)記了一句話:“局部的模糊性必須必須通過(guò)尋找最佳的全局解釋來(lái)解決。”并表示,Hinton現(xiàn)在又回到了最初的起點(diǎn)。

Hinton第一篇論文:https://www.cs.toronto.edu/~hinton/absps/puppet.pdf

局部和整體的一致性表示似乎一直是Hinton的研究重點(diǎn)。比如,膠囊網(wǎng)絡(luò)通過(guò)局部到整體的動(dòng)態(tài)路徑選擇一致性來(lái)學(xué)習(xí)識(shí)別,近期Hinton還將其擴(kuò)展到了無(wú)監(jiān)督學(xué)習(xí),并應(yīng)用了Transformer架構(gòu);對(duì)比學(xué)習(xí)則學(xué)習(xí)一種表示,使得同一幅圖像的的各個(gè)局部具有相似的表示;認(rèn)知神經(jīng)科學(xué)出身的Hinton還一直堅(jiān)持探索著大腦的學(xué)習(xí)機(jī)制,比如back relaxation試圖在自頂向下表示和自底向上表示之間產(chǎn)生一致性,而這又和對(duì)比學(xué)習(xí)有聯(lián)系。

在這篇新論文中,Hinton又將為我們描繪出怎樣一幅圖景呢?

論文鏈接:https://arxiv.org/pdf/2102.12627.pdf

這篇論文沒(méi)有描述工作系統(tǒng),而是單單提出了一個(gè)關(guān)于表示的想法。這個(gè)想法能夠把Transformer、神經(jīng)場(chǎng)(neural fields)、對(duì)比表示學(xué)習(xí)、蒸餾和膠囊等先進(jìn)觀點(diǎn)整合到一個(gè)名為“GLOM 1”的設(shè)想系統(tǒng)中。

一個(gè)具有固定架構(gòu)的神經(jīng)網(wǎng)絡(luò)如何將一張圖像解析成一個(gè)整體的分級(jí)體系(其中,每張圖像都有不同的結(jié)構(gòu))?針對(duì)這個(gè)問(wèn)題,GLOM 給出了一個(gè)簡(jiǎn)單的答案,即使用相同向量的孤島來(lái)表示解析樹中的節(jié)點(diǎn)。如果 GLOM 真的能夠正常運(yùn)轉(zhuǎn),那么,當(dāng)它在視覺或語(yǔ)言上應(yīng)用時(shí),它能夠極大地提高類似Transformer的系統(tǒng)所生成的表示的可解釋性。

“GLOM”一詞源自一句俗語(yǔ)“ glom together”(“抓”到一起),可能是來(lái)源于“凝聚”(agglomerate)一詞。

1

觀點(diǎn)總覽

心理學(xué)提供了一個(gè)有力證據(jù),表明:人們會(huì)將視覺場(chǎng)景解析為整個(gè)分層體系,并將部分與整體之間視角不變的空間關(guān)系,建模為他們分配給該部分和整體的內(nèi)在坐標(biāo)系之間的坐標(biāo)轉(zhuǎn)換。

如果我們想要建立像人類一樣理解圖像的神經(jīng)網(wǎng)絡(luò),那么我們需要想明白:神經(jīng)網(wǎng)絡(luò)是如何表示部分-整體的分層體系?這很困難,因?yàn)橐粋€(gè)真實(shí)的神經(jīng)網(wǎng)絡(luò)無(wú)法將一組神經(jīng)元進(jìn)行動(dòng)態(tài)分配,以表示解析樹中的一個(gè)節(jié)點(diǎn)。

神經(jīng)網(wǎng)絡(luò)無(wú)法動(dòng)態(tài)分配神經(jīng)元,也是一系列用到“膠囊”觀點(diǎn)的模型所出現(xiàn)的原因。這些模型會(huì)作出如下假設(shè):被稱為“膠囊”的一組神經(jīng)元會(huì)永遠(yuǎn)成為圖像特定區(qū)域中的某一特定類型的一部分。通過(guò)激活這些預(yù)先存在的、類型特定的膠囊子集,以及膠囊之間的適合連接,可以構(gòu)建一個(gè)解析樹。

這篇論文介紹了一種非常不同的方式,可以使用膠囊來(lái)表示神經(jīng)網(wǎng)絡(luò)中的部分-整體分層體系。

雖然這篇論文主要討論了單個(gè)靜態(tài)圖像的感知,但我們可以簡(jiǎn)單地將 GLOM 理解為用于處理一系列幀的管道,因此靜態(tài)圖像可以被視為一系列相同的幀。

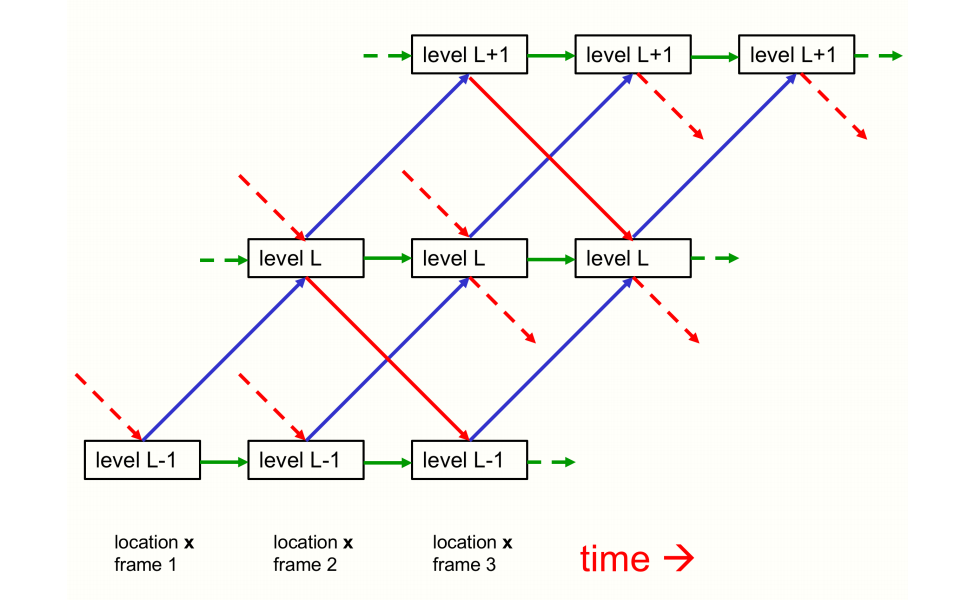

GLOM 架構(gòu)由許多列(column)組成,所有列均使用完全相同的權(quán)重。每一列都是一堆空間局部自動(dòng)編碼器,這些編碼器會(huì)學(xué)習(xí)小圖像塊(image patch)中的多個(gè)不同級(jí)別的表示。每個(gè)自動(dòng)編碼器都會(huì)使用多層自下而上的編碼器和多層自上而下的解碼器,將同一個(gè)級(jí)別的嵌入轉(zhuǎn)換為相鄰級(jí)別的嵌入。這些級(jí)別與部分-整體分層體系中的級(jí)別一一對(duì)應(yīng)。比如,顯示一張人臉圖像時(shí),一個(gè)單列可能會(huì)收斂到表示一個(gè)鼻孔、一個(gè)鼻子、一張臉和一個(gè)人的嵌入向量上。圖 1 顯示了不同級(jí)別的嵌入如何在單列中進(jìn)行交互。

圖1:?jiǎn)瘟兄校珿LOM架構(gòu)的三個(gè)相鄰級(jí)別的自下而上、自上而下、同列的交互。

代表自下而上和自上而下交互的藍(lán)色和紅色箭頭是由兩個(gè)具有多個(gè)隱藏層的不同神經(jīng)網(wǎng)絡(luò)來(lái)實(shí)現(xiàn)。這些網(wǎng)絡(luò)在成對(duì)的級(jí)別中有所差異,但它們可以跨列、跨時(shí)間步分享。自上而下的網(wǎng)絡(luò)也許應(yīng)該使用正弦單位。對(duì)于靜態(tài)圖,綠色箭頭可以簡(jiǎn)單看作按比例縮放的殘差連接,以實(shí)現(xiàn)每個(gè)級(jí)別的嵌入的時(shí)間平滑。對(duì)于視頻,綠色連接可以是基于多個(gè)先前狀態(tài)的膠囊來(lái)學(xué)習(xí)時(shí)間動(dòng)態(tài)的神經(jīng)網(wǎng)絡(luò)。不同列中,相同級(jí)別的的嵌入向量之間的交互可以通過(guò)非自適應(yīng)的、注意力加權(quán)的局部平滑器(圖中沒(méi)有顯示)來(lái)實(shí)現(xiàn)。

圖 1 沒(méi)有顯示不同列中同一級(jí)別的嵌入之間的交互。這比同一列內(nèi)的交互要簡(jiǎn)單得多,因?yàn)樗鼈儾恍枰獔?zhí)行部分-整體坐標(biāo)轉(zhuǎn)換。它們就像代表一個(gè)多頭 transformer 中不同單詞片段的列之間的注意力加權(quán)交互,但更簡(jiǎn)單,因?yàn)椴樵儭㈡I和值向量都與嵌入向量相同。列與列之間的交互作用是,通過(guò)使一個(gè)級(jí)別的每個(gè)嵌入向量向附近位置的其他類似向量回歸,從而在該級(jí)別上產(chǎn)生具有相同嵌入的島。這將創(chuàng)建多個(gè)局部“回音室”,其中一個(gè)級(jí)別的嵌入主要聽從其他想法相似的嵌入。

在每一段離散時(shí)間和每一列中,一個(gè)級(jí)別的嵌入將被更新為擁有四個(gè)貢獻(xiàn)(如下)的加權(quán)平均值:

自下而上的神經(jīng)網(wǎng)絡(luò)在前一個(gè)時(shí)間作用于下層級(jí)別的嵌入而產(chǎn)生的預(yù)測(cè);

自上而下的神經(jīng)網(wǎng)絡(luò)在前一個(gè)時(shí)間作用于上層級(jí)別的嵌入而產(chǎn)生的預(yù)測(cè);

上一個(gè)時(shí)間步的嵌入向量;

前一個(gè)時(shí)間在附近列相同級(jí)別的嵌入的注意力加權(quán)平均值。

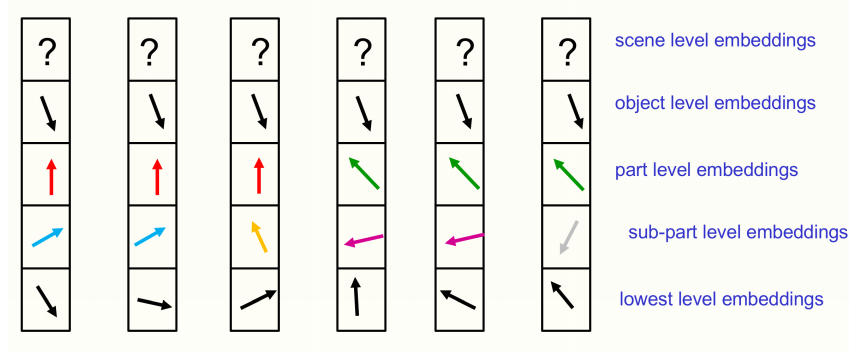

對(duì)于靜態(tài)圖,一個(gè)級(jí)別的嵌入應(yīng)隨著時(shí)間的流逝而沉淀,以生成擁有幾乎相同向量的不同島。如圖 2 所示, 這些島在更高的級(jí)別上應(yīng)該更大。使用相似的島來(lái)表示圖像的解析,避免了需要分配神經(jīng)元組來(lái)動(dòng)態(tài)表示正在運(yùn)行的解析樹的節(jié)點(diǎn),或預(yù)先為所有可能的節(jié)點(diǎn)設(shè)置神經(jīng)元的情況。GLOM 系統(tǒng)不是分配神經(jīng)硬件來(lái)表示解析樹中的節(jié)點(diǎn),或?yàn)楣?jié)點(diǎn)提供指向其祖先和后代的指針,而是分配了一個(gè)合適的活動(dòng)向量來(lái)表示該節(jié)點(diǎn),并在屬于該節(jié)點(diǎn)的所有位置上使用了相同的活動(dòng)向量。訪問(wèn)節(jié)點(diǎn)的祖先和后代的能力是通過(guò)自下而上和自上而下的神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)的,而不是通過(guò)使用 RAM 檢查表格來(lái)實(shí)現(xiàn)的。

圖 2:在特定時(shí)間里,6 個(gè)相鄰列的嵌入。

圖 2 所顯示的所有位置都屬于同一對(duì)象,且場(chǎng)景級(jí)別尚未在共享矢量上定居。通過(guò)將向量劃分為部分-整體分層體系中每個(gè)級(jí)別的單獨(dú)部分,然后將一個(gè)級(jí)別的的高維嵌入向量顯示為二維向量,那么每個(gè)位置的完整嵌入向量就可以顯示出來(lái)。這可以很好地解釋不同位置的嵌入向量的對(duì)齊。圖 2 所示的不同級(jí)別上向量相同的島,實(shí)則表示一棵解析樹。但是,相同的島比短語(yǔ)結(jié)構(gòu)語(yǔ)法要強(qiáng)大得多。比如,在“這是否會(huì)減慢短語(yǔ)結(jié)構(gòu)語(yǔ)法的速度”的問(wèn)題上,它們可以毫不費(fèi)力地表示斷開連接的對(duì)象。

就像BERT一樣,整個(gè) GLOM 系統(tǒng)可以進(jìn)行端到端的訓(xùn)練,以在最后的時(shí)間步從缺少某一區(qū)域的輸入圖像中重建圖像。但是,目標(biāo)函數(shù)還包含兩個(gè)倡導(dǎo)在每個(gè)級(jí)別上向量幾乎相同的島的正則化器(regularizer)。正則化器只是一個(gè)級(jí)別的新嵌入與自下而上、自上而下的預(yù)測(cè)之間的一致性。提高這個(gè)一致性能夠促進(jìn)局部島的形成。

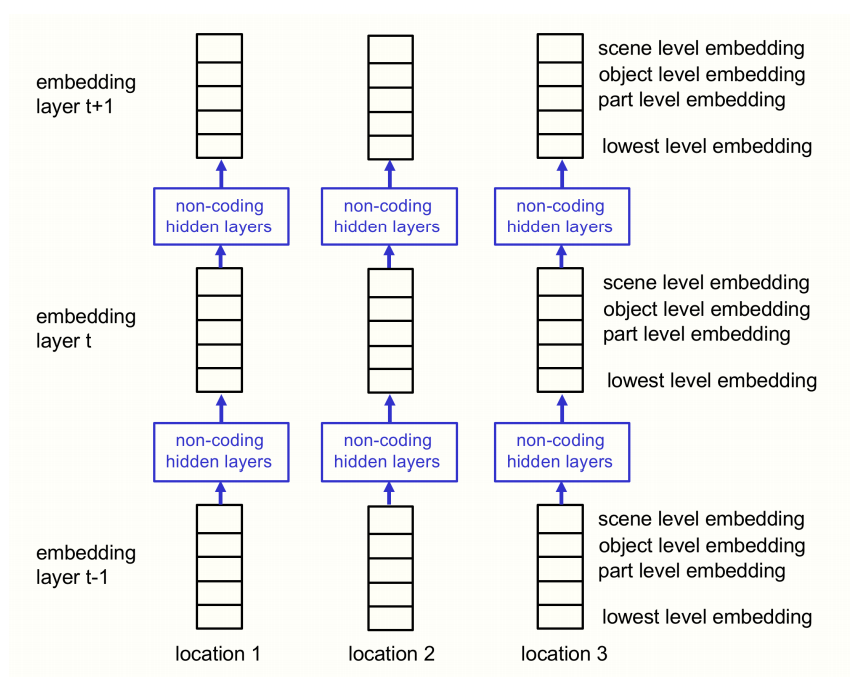

圖 4:這是將圖 1 所示架構(gòu)進(jìn)行可視化的另一種方式,可以使該架構(gòu)與 transformer 之間的關(guān)系更加明顯。圖 1 中表示時(shí)間的水平尺寸變成了圖 4 中表示層的垂直尺寸。此時(shí),在每一個(gè)位置,每一層都有部分-整體分層體系中所有級(jí)別的嵌入。這與垂直壓縮圖 1 中單個(gè)時(shí)間片內(nèi)的級(jí)別描述一致。

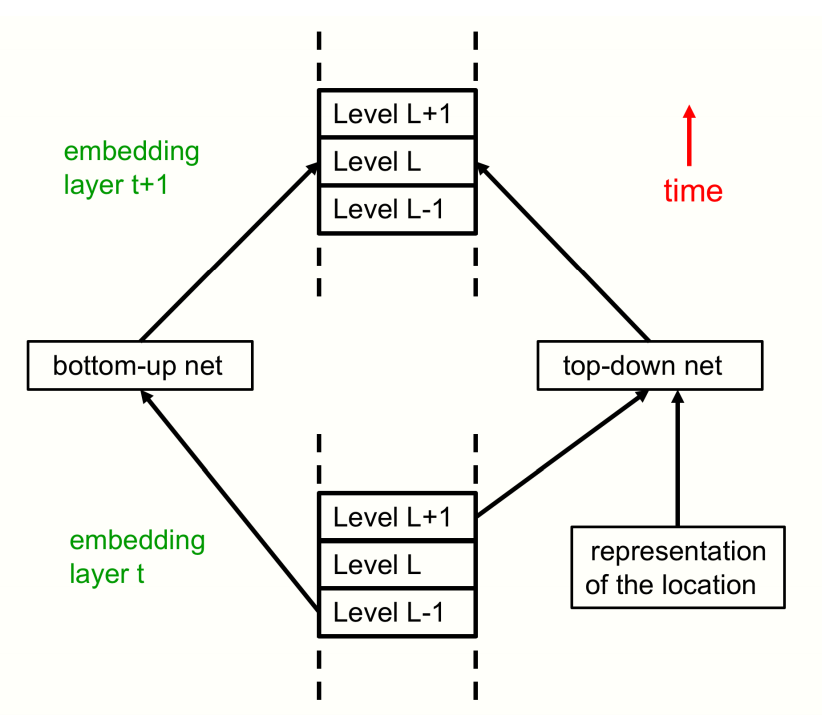

靜態(tài)圖的解釋僅需要使用該架構(gòu)進(jìn)行一次前向傳遞。這里將所有級(jí)別特定的自下而上和自上而下的神經(jīng)網(wǎng)絡(luò)都顯示為單個(gè)神經(jīng)網(wǎng)絡(luò)。圖 5 顯示了另一種查看 GLOM 架構(gòu)的自下而上和自上而下的神經(jīng)網(wǎng)絡(luò)。

圖 5:GLOM 在同一個(gè)位置(即單列的一部分)的兩個(gè)相鄰層。在前向傳遞的過(guò)程中,L 級(jí)的嵌入向量通過(guò)多層自下而上的神經(jīng)網(wǎng)絡(luò)從上一層 L-1 級(jí)的嵌入向量中接收輸入。L 級(jí)還通過(guò)多層自上而下的神經(jīng)網(wǎng)絡(luò)從上一層 L+1 級(jí)的嵌入中接收輸入。在前向傳遞的過(guò)程中,對(duì)上一層 L+1 級(jí)的依賴取得了自上而下的效果。嵌入在 t+1 層中的 L 級(jí)還取決于嵌入在 t 層中的 L 級(jí)嵌入和 t 層中其他附近位置的 L 級(jí)嵌入的注意力加權(quán)總和。圖中沒(méi)有顯示級(jí)內(nèi)的交互。

2

責(zé)任編輯:lq

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4811瀏覽量

103064 -

算法

+關(guān)注

關(guān)注

23文章

4702瀏覽量

94984 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4374瀏覽量

64426

原文標(biāo)題:Hinton一作新論文:如何在神經(jīng)網(wǎng)絡(luò)中表示“部分-整體層次結(jié)構(gòu)”?

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

BP神經(jīng)網(wǎng)絡(luò)的網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)原則

LSTM神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)與工作機(jī)制

神經(jīng)網(wǎng)絡(luò)三層結(jié)構(gòu)的作用是什么

遞歸神經(jīng)網(wǎng)絡(luò)和循環(huán)神經(jīng)網(wǎng)絡(luò)的模型結(jié)構(gòu)

如何在神經(jīng)網(wǎng)絡(luò)中表示部分-整體層次結(jié)構(gòu)

如何在神經(jīng)網(wǎng)絡(luò)中表示部分-整體層次結(jié)構(gòu)

評(píng)論