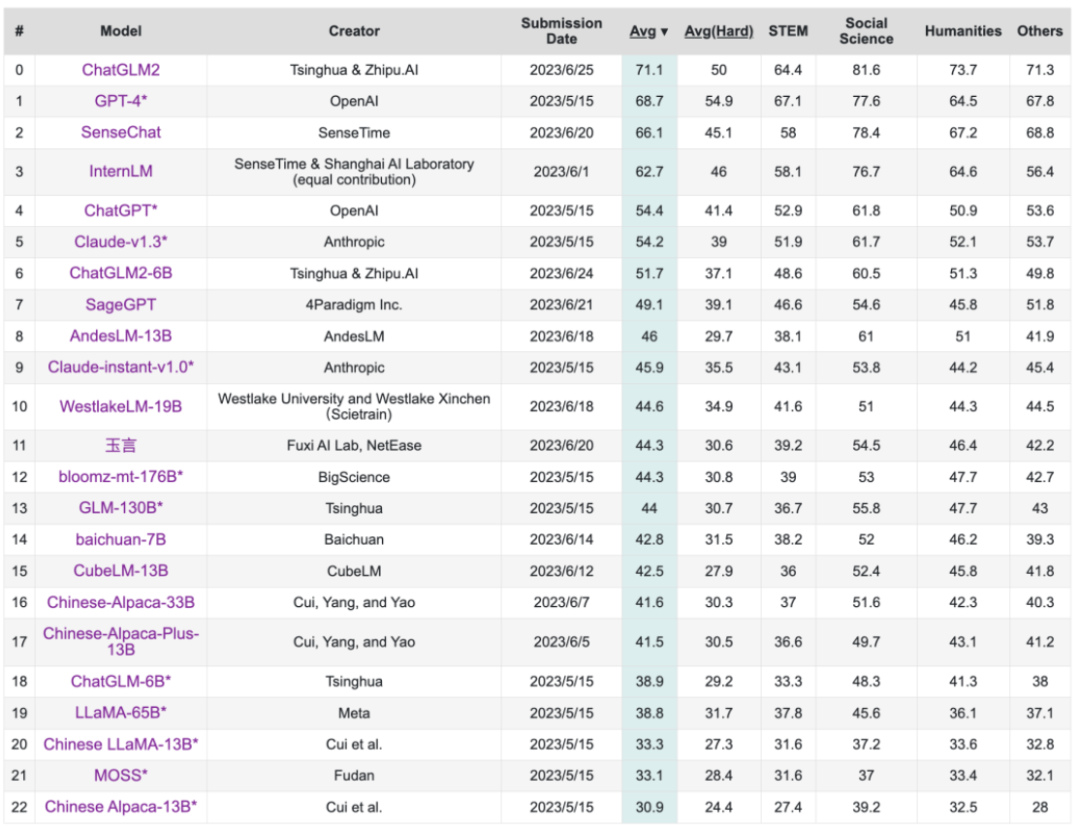

GLM 技術(shù)團(tuán)隊(duì)宣布再次升級(jí) ChatGLM-6B,發(fā)布 ChatGLM2-6B。ChatGLM-6B 于 3 月 14 日發(fā)布,截至 6 月 24 日在 Huggingface 上的下載量已經(jīng)超過 300w。 截至 6 月 25 日,ChatGLM2 模型在主要評(píng)估 LLM 模型中文能力的 C-Eval 榜單中以 71.1 的分?jǐn)?shù)位居 Rank 0;ChatGLM2-6B 模型則以 51.7 的分?jǐn)?shù)位居 Rank 6,是榜單上排名最高的開源模型。

ChatGLM2-6B 是開源中英雙語(yǔ)對(duì)話模型 ChatGLM-6B 的第二代版本,在保留了初代模型對(duì)話流暢、部署門檻較低等眾多優(yōu)秀特性的基礎(chǔ)之上,ChatGLM2-6B 引入了如下新特性:

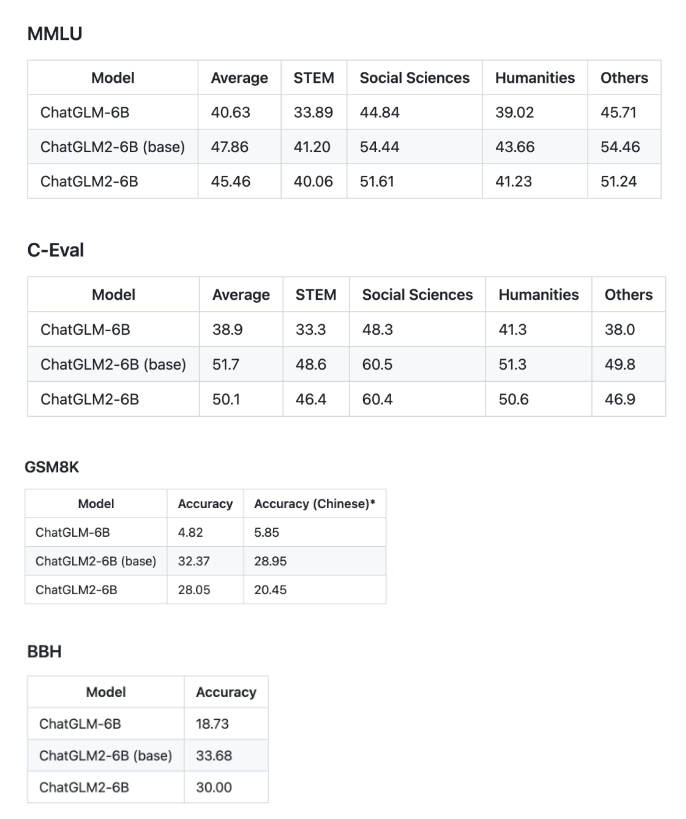

更強(qiáng)大的性能:基于 ChatGLM 初代模型的開發(fā)經(jīng)驗(yàn),全面升級(jí)了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目標(biāo)函數(shù),經(jīng)過了 1.4T 中英標(biāo)識(shí)符的預(yù)訓(xùn)練與人類偏好對(duì)齊訓(xùn)練,評(píng)測(cè)結(jié)果顯示,相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等數(shù)據(jù)集上的性能取得了大幅度的提升,在同尺寸開源模型中具有較強(qiáng)的競(jìng)爭(zhēng)力。

更長(zhǎng)的上下文:基于 FlashAttention 技術(shù),項(xiàng)目團(tuán)隊(duì)將基座模型的上下文長(zhǎng)度(Context Length)由 ChatGLM-6B 的 2K 擴(kuò)展到了 32K,并在對(duì)話階段使用 8K 的上下文長(zhǎng)度訓(xùn)練,允許更多輪次的對(duì)話。但當(dāng)前版本的 ChatGLM2-6B 對(duì)單輪超長(zhǎng)文檔的理解能力有限,我們會(huì)在后續(xù)迭代升級(jí)中著重進(jìn)行優(yōu)化。

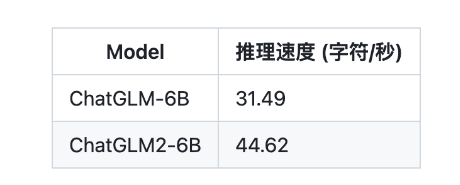

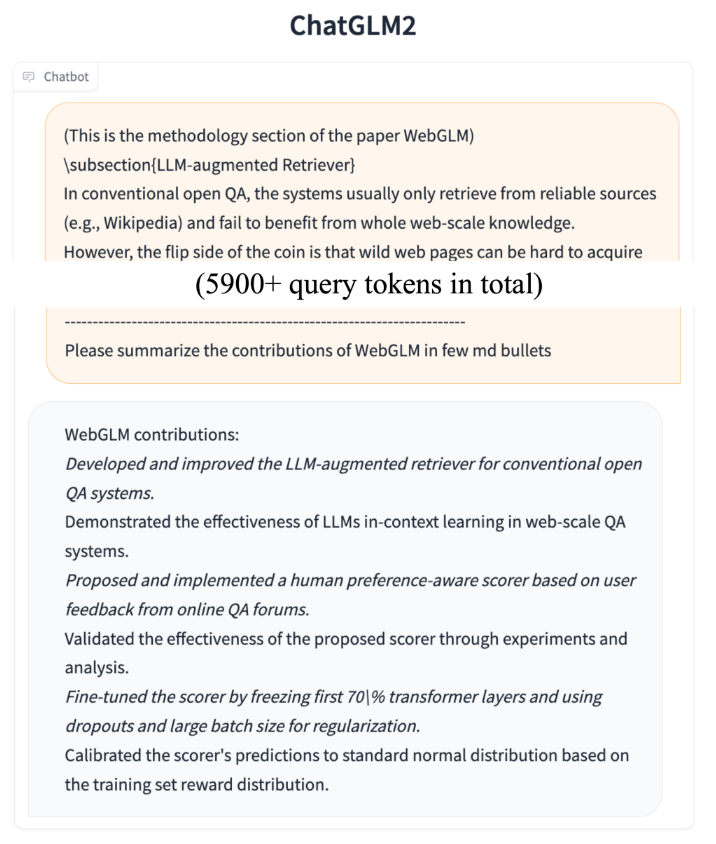

更高效的推理:基于 Multi-Query Attention 技術(shù),ChatGLM2-6B 有更高效的推理速度和更低的顯存占用:在官方的模型實(shí)現(xiàn)下,推理速度相比初代提升了 42%,INT4 量化下,6G 顯存支持的對(duì)話長(zhǎng)度由 1K 提升到了 8K。

更開放的協(xié)議:ChatGLM2-6B 權(quán)重對(duì)學(xué)術(shù)研究完全開放,在獲得官方的書面許可后,亦允許商業(yè)使用。

評(píng)測(cè)結(jié)果

以下為 ChatGLM2-6B 模型在 MMLU (英文)、C-Eval(中文)、GSM8K(數(shù)學(xué))、BBH(英文) 上的測(cè)評(píng)結(jié)果。

推理性能

ChatGLM2-6B 使用了 Multi-Query Attention,提高了生成速度。生成 2000 個(gè)字符的平均速度對(duì)比如下

Multi-Query Attention 同時(shí)也降低了生成過程中 KV Cache 的顯存占用,此外,ChatGLM2-6B 采用 Causal Mask 進(jìn)行對(duì)話訓(xùn)練,連續(xù)對(duì)話時(shí)可復(fù)用前面輪次的 KV Cache,進(jìn)一步優(yōu)化了顯存占用。因此,使用 6GB 顯存的顯卡進(jìn)行 INT4 量化的推理時(shí),初代的 ChatGLM-6B 模型最多能夠生成 1119 個(gè)字符就會(huì)提示顯存耗盡,而 ChatGLM2-6B 能夠生成至少 8192 個(gè)字符。

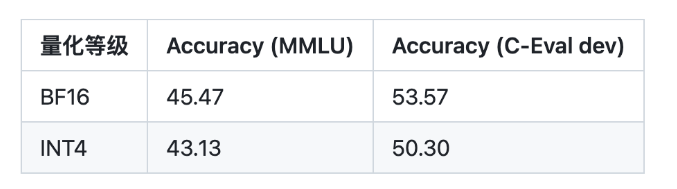

項(xiàng)目團(tuán)隊(duì)也測(cè)試了量化對(duì)模型性能的影響。結(jié)果表明,量化對(duì)模型性能的影響在可接受范圍內(nèi)。

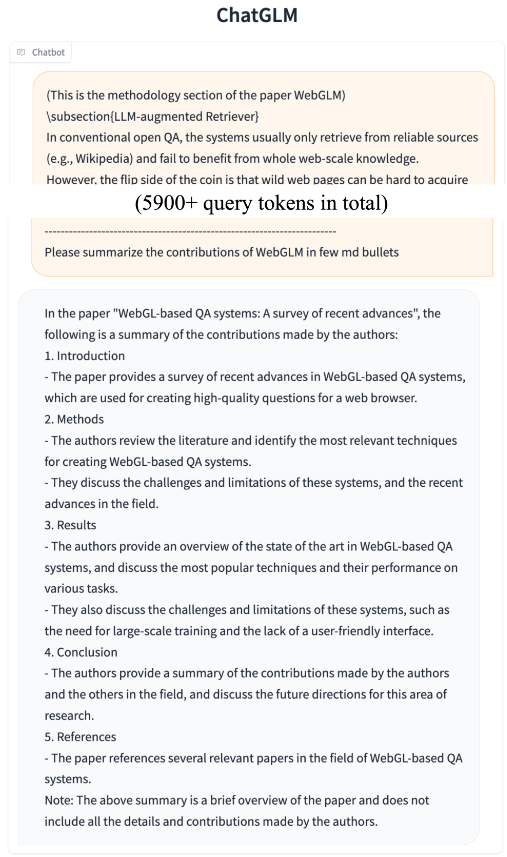

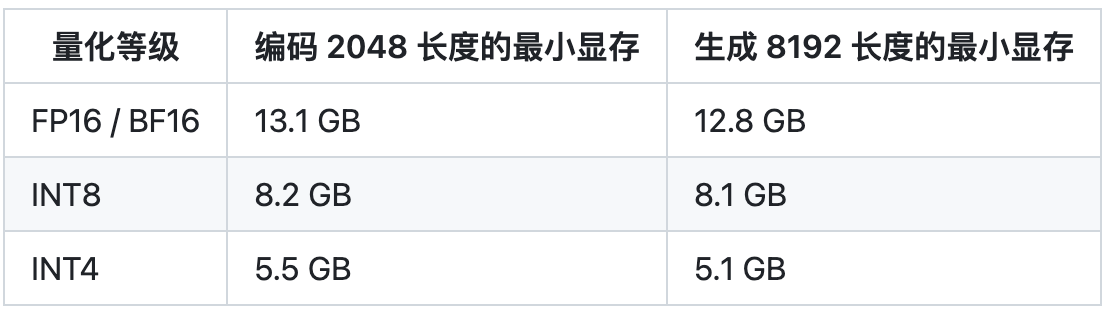

示例對(duì)比

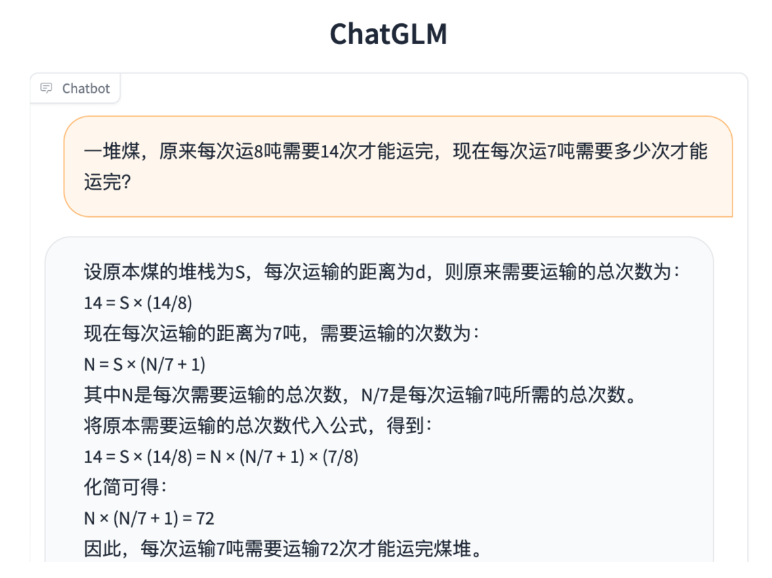

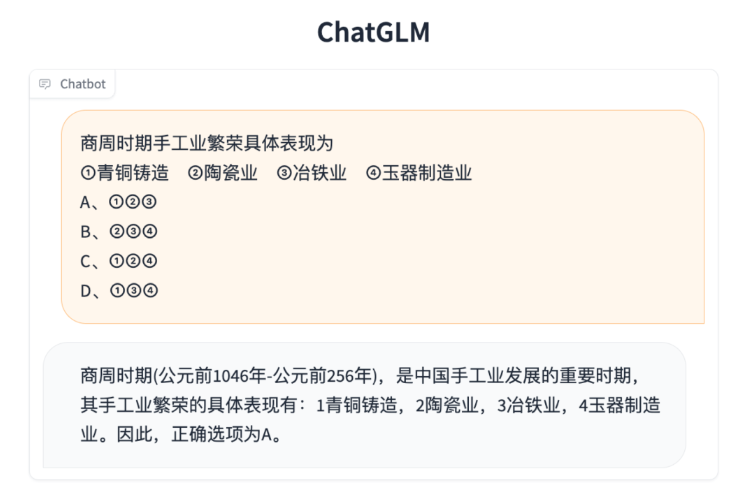

相比于初代模型,ChatGLM2-6B 多個(gè)維度的能力都取得了提升,以下是一些對(duì)比示例。 數(shù)理邏輯

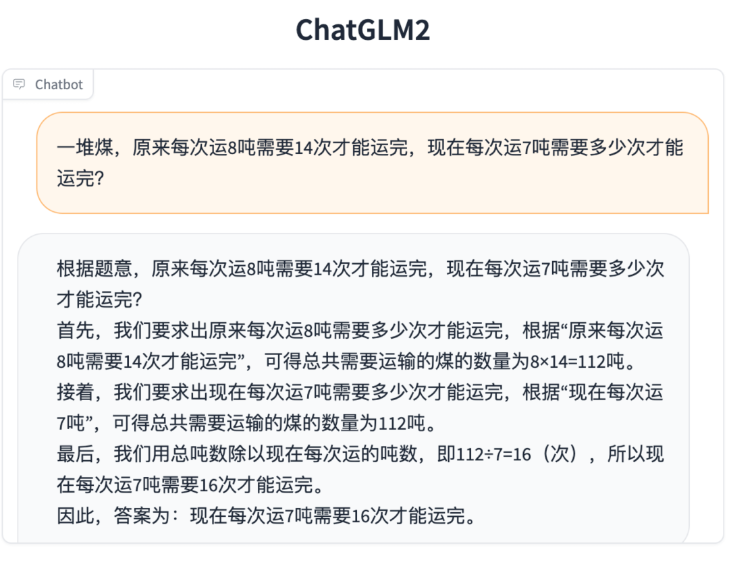

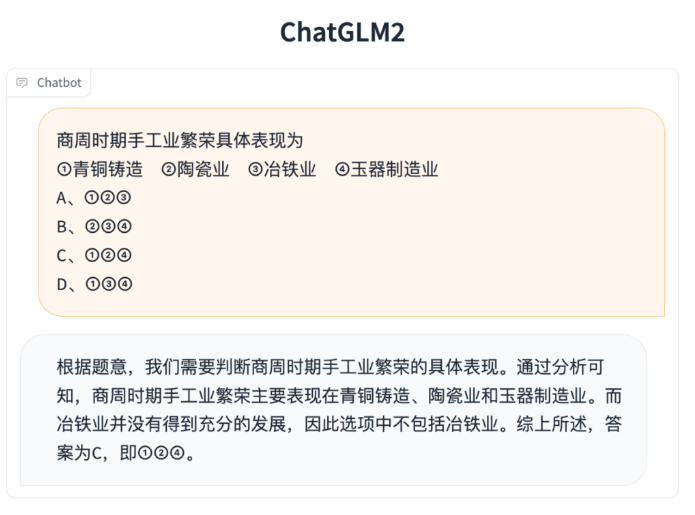

知識(shí)推理

長(zhǎng)文檔理解

-

開源

+關(guān)注

關(guān)注

3文章

3631瀏覽量

43560 -

模型

+關(guān)注

關(guān)注

1文章

3499瀏覽量

50093 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25307

原文標(biāo)題:下載量超300w的ChatGLM-6B再升級(jí):8-32k上下文,推理提速42%

文章出處:【微信號(hào):OSC開源社區(qū),微信公眾號(hào):OSC開源社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

Google Gemma 3開發(fā)者指南

LPCXpresso54S018在位置0xBF30B670訪問后無(wú)法訪問調(diào)試端口,怎么解決?

S32K在AUTOSAR中使用CAT1 ISR,是否需要執(zhí)行上下文切換?

為什么深度學(xué)習(xí)中的Frame per Second高于OpenVINO?演示推理腳本?

DeepSeek推出NSA機(jī)制,加速長(zhǎng)上下文訓(xùn)練與推理

《具身智能機(jī)器人系統(tǒng)》第7-9章閱讀心得之具身智能機(jī)器人與大模型

UCC28063EVM-723 300W交錯(cuò)式PFC預(yù)調(diào)節(jié)器手冊(cè)

UCC28060EVM 300W交錯(cuò)式PFC預(yù)調(diào)節(jié)器手冊(cè)

Vox Power Ltd - 最新發(fā)布EIRE300系列開放式AC-DC電源,高功率密度,300W輸出功率,占地4”x 2”,1”纖薄設(shè)計(jì),30

SystemView上下文統(tǒng)計(jì)窗口識(shí)別阻塞原因

chatglm2-6b在P40上做LORA微調(diào)

超ChatGPT-4o,國(guó)產(chǎn)大模型竟然更懂翻譯,8款大模型深度測(cè)評(píng)|AI 橫評(píng)

大聯(lián)大推出基于Innoscience產(chǎn)品的300W電源適配器方案

大聯(lián)大詮鼎集團(tuán)推出基于Innoscience產(chǎn)品的300W電源適配器方案

下載量超300w的ChatGLM-6B再升級(jí):8-32k上下文,推理提速42%

下載量超300w的ChatGLM-6B再升級(jí):8-32k上下文,推理提速42%

評(píng)論