以下文章來(lái)源于谷歌云服務(wù),作者 Google Cloud

Amin Vahdat

Google Cloud ML、系統(tǒng)和 Cloud AI 副總裁暨總經(jīng)理

在 Google Cloud Next 25 大會(huì)上,我們隆重推出第 7 代 Tensor Processing Unit (TPU) — Ironwood。這不僅是我們迄今為止性能最高、擴(kuò)展性最佳的定制 AI 加速器,更是第一款專(zhuān)為推理而設(shè)計(jì)的 TPU。

十多年來(lái),TPU 一直為 Google 最嚴(yán)苛的 AI 訓(xùn)練與執(zhí)行工作負(fù)載提供支持,并助力我們的云端客戶(hù)實(shí)現(xiàn)相同目標(biāo)。Ironwood 是我們至今最強(qiáng)大、功能最全面且能效最高的 TPU,專(zhuān)為大規(guī)模驅(qū)動(dòng)思考型(thinking)、推理型(inferential)的 AI 模型而打造。

Ironwood 的問(wèn)世,代表著 AI 發(fā)展及其底層基礎(chǔ)架構(gòu)演進(jìn)的重大轉(zhuǎn)變。從為人們提供實(shí)時(shí)信息以供解讀的響應(yīng)式 AI (responsive AI)模型,轉(zhuǎn)向能夠主動(dòng)生成洞察和解讀的模型。這就是我們所說(shuō)的「推理時(shí)代」(age of inference),在這個(gè)時(shí)代,AI agent 將主動(dòng)檢索和生成數(shù)據(jù),以協(xié)同方式提供洞察與解答,而不僅僅是提供數(shù)據(jù)。

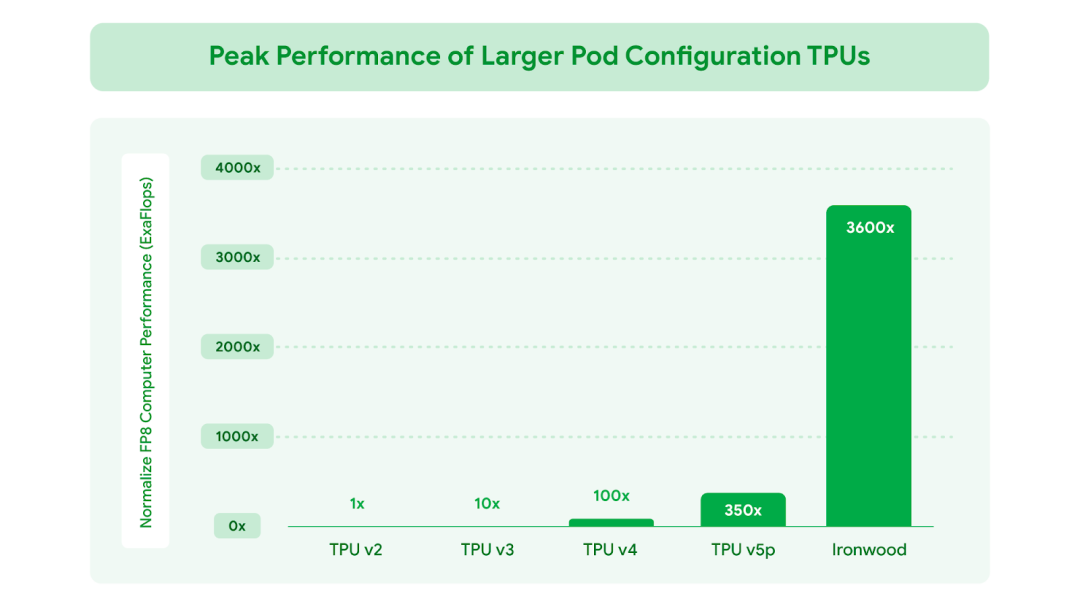

Ironwood 的構(gòu)建旨在支持生成式 AI 的下一個(gè)發(fā)展階段及其龐大的計(jì)算和通信需求。Ironwood 可以擴(kuò)展到高達(dá) 9,216 顆液冷芯片(liquid cooled chips),這些芯片通過(guò)突破性的芯片間互連 (Inter-Chip Interconnect, ICI) 網(wǎng)絡(luò)相連。它是 Google Cloud AI Hypercomputer 架構(gòu)的多項(xiàng)新組件之一,該架構(gòu)旨在整合優(yōu)化硬件與軟件層面,以應(yīng)對(duì)最嚴(yán)苛的 AI 工作負(fù)載。通過(guò) Ironwood,開(kāi)發(fā)者還能利用 Google 自家的 Pathways 軟件堆棧,可靠且輕松地利用數(shù)萬(wàn)個(gè) Ironwood TPU 的組合計(jì)算能力。

以下我們將深入探討這些創(chuàng)新如何協(xié)同運(yùn)作,以無(wú)與倫比的性能、成本和能效來(lái)處理最嚴(yán)苛的訓(xùn)練與執(zhí)行工作負(fù)載。

以 Ironwood 驅(qū)動(dòng)推理時(shí)代

Ironwood 的設(shè)計(jì)旨在從容應(yīng)對(duì)「思考模型」的復(fù)雜計(jì)算和通信需求,這類(lèi)模型涵蓋了大語(yǔ)言模型 (LLMs)、專(zhuān)家混和模型 (Mixture of Experts, MoEs) 和進(jìn)階推理任務(wù)。這些模型需要大規(guī)模并行處理能力和高效的內(nèi)存訪(fǎng)問(wèn)。

特別的是,Ironwood 的設(shè)計(jì)著重于在執(zhí)行大量的張量運(yùn)算的同時(shí),最大限度地降低芯片上的數(shù)據(jù)移動(dòng)和延遲。在前沿應(yīng)用方面,思考模型的計(jì)算需求遠(yuǎn)遠(yuǎn)超出任何單一芯片的處理容量。我們?yōu)?Ironwood TPU 設(shè)計(jì)了低延遲、高帶寬的 ICI 網(wǎng)絡(luò),以支持在整個(gè) TPU Pod 規(guī)模下進(jìn)行協(xié)調(diào)且同步的通信。

針對(duì) Google Cloud 客戶(hù),Ironwood 根據(jù) AI 工作負(fù)載的需求提供兩種規(guī)模配置:256 顆芯片配置和 9,216 顆芯片配置。

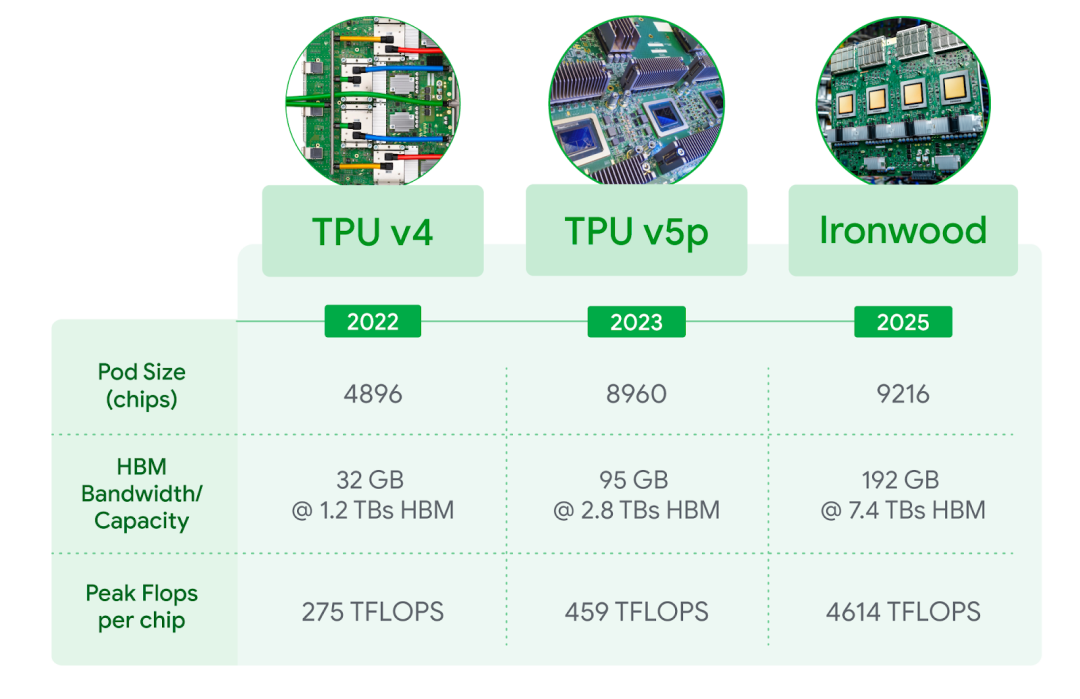

當(dāng)擴(kuò)展到每個(gè) Pod 達(dá) 9,216 顆芯片時(shí),總運(yùn)算能力可達(dá) 42.5 百億億次浮點(diǎn)運(yùn)算每秒(42.5 Exaflops),是世界上最大的超級(jí)計(jì)算機(jī) El Capitan 的24 倍以上,后者每個(gè) Pod 僅提供 1.7 百億億次浮點(diǎn)運(yùn)算每秒 (1.7 Exaflops)。Ironwood 提供的大規(guī)模并行處理能力,能夠支持最嚴(yán)苛的 AI 工作負(fù)載,例如用于訓(xùn)練和推理、具備思考能力的超大型密集 LLM 或 MoE 模型。每顆獨(dú)立芯片的峰值計(jì)算能力高達(dá) 4,614 萬(wàn)億次浮點(diǎn)運(yùn)算每秒(4,614 TFLOPs),代表著 AI 能力的巨大飛躍。此外,Ironwood 的內(nèi)存和網(wǎng)絡(luò)架構(gòu)確保了在如此龐大的規(guī)模下,始終能夠提供正確的數(shù)據(jù)可支持峰值性能。

Ironwood 還配備了增強(qiáng)版的 SparseCore,這是一種專(zhuān)門(mén)用于處理高級(jí)排名和推薦系統(tǒng)工作負(fù)載中常見(jiàn)的超大規(guī)模嵌入(embeddings)的加速器。Ironwood 對(duì) SparseCore 的支持?jǐn)U大,使其能加速更廣泛的工作負(fù)載,甚至跨越傳統(tǒng) AI 領(lǐng)域,進(jìn)入金融和科學(xué)等領(lǐng)域。

Google DeepMind 開(kāi)發(fā)的機(jī)器學(xué)習(xí)運(yùn)行時(shí)架構(gòu) Pathways,能在多個(gè) TPU 芯片間實(shí)現(xiàn)高效的分布式計(jì)算。Google Cloud 上的 Pathways 讓使用者能輕易超越單個(gè) Ironwood Pod 的限制,將數(shù)十萬(wàn)顆 Ironwood 芯片組合在一起,以快速推進(jìn)生成式 AI 計(jì)算的前沿發(fā)展。

圖一:相較于 Google 首款對(duì)外提供的 Cloud TPU v2, FP8 總峰值浮點(diǎn)運(yùn)算性能提升幅度。

圖二:包括最新一代 Ironwood 在內(nèi)的 Cloud TPU 產(chǎn)品 (3D 環(huán)形拓?fù)浣Y(jié)構(gòu), 3D torus version) 技術(shù)規(guī)格并列比較。FP8 峰值 TFlops 在 v4 與 v5p 上為模擬值,Ironwood 則提供原生支持。

Ironwood 的主要功能

Google Cloud 是唯一一家擁有超過(guò)十年提供 AI 計(jì)算經(jīng)驗(yàn)的超大規(guī)模云提供商,不僅支持尖端研究,更將這些技術(shù)無(wú)縫整合到全球規(guī)模等級(jí)的服務(wù)中,每天為數(shù)十億使用者提供 Gmail、Google 搜索等服務(wù)。這些專(zhuān)業(yè)知識(shí)正是 Ironwood 性能的核心所在。主要功能包括:

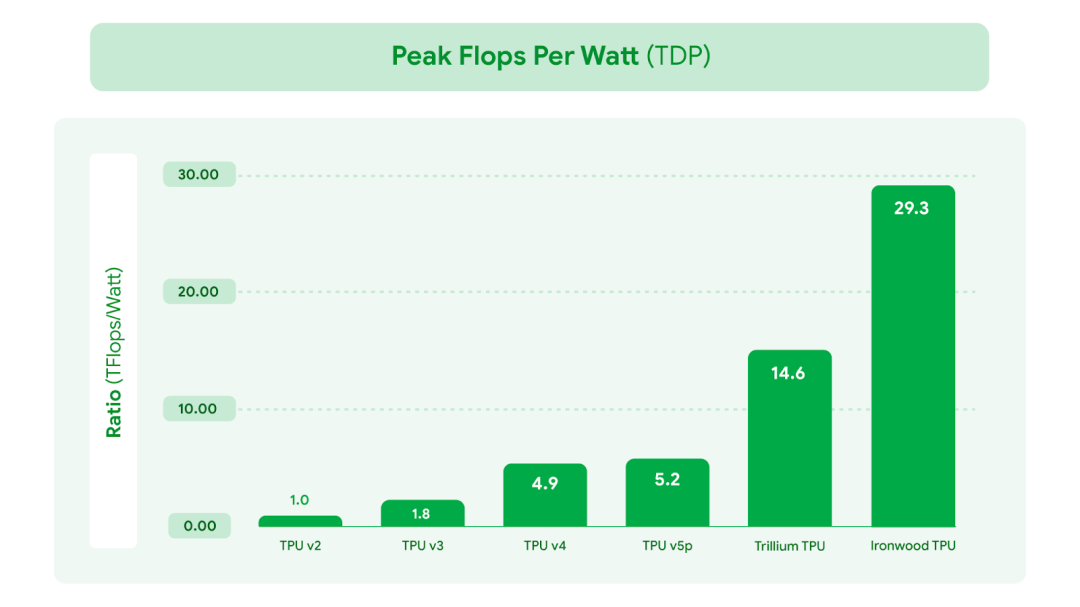

在性能大幅提升的同時(shí)也注重能效,使 AI 工作負(fù)載能夠以更符合成本效益的方式運(yùn)行。Ironwood 的性能功耗比是 2024 年推出的第 6 代 TPU Trillium 的 2 倍。在當(dāng)前可用電力成為 AI 發(fā)展限制因素之一的時(shí)代,我們?yōu)榭蛻?hù)的工作負(fù)載提供了每瓦更多的計(jì)算能力。我們先進(jìn)的液冷解決方案和優(yōu)化的芯片設(shè)計(jì),即使面對(duì)持續(xù)繁重的 AI 工作負(fù)載,也能可靠地維持高達(dá)標(biāo)準(zhǔn)風(fēng)冷兩倍的性能。事實(shí)上,Ironwood 的能效較我們 2018 年推出的首款 Cloud TPU 提升近 30 倍。

大幅增加高帶寬內(nèi)存 (HBM) 容量。Ironwood 每顆芯片提供 192 GB 容量,是 Trillium 的 6 倍,能處理更大的模型和數(shù)據(jù)集計(jì)算,減少頻繁的數(shù)據(jù)傳輸需求,進(jìn)而提升整體性能。

HBM 帶寬大幅提升,單顆芯片可達(dá) 7.2 Tbps,是 Trillium 的 4.5 倍。這種高帶寬能確保數(shù)據(jù)快速訪(fǎng)問(wèn),這對(duì)于現(xiàn)代 AI 中常見(jiàn)的內(nèi)存密集型工作負(fù)載至關(guān)重要。

增強(qiáng)芯片間互連 (ICI) 帶寬。雙向傳輸已提高到 1.2 Tbps,是 Trillium 的 1.5 倍,能加速芯片間的通信,有助于提升大規(guī)模分布式訓(xùn)練和推理的效率。

圖三:相較于最早的 Cloud TPU v2,Google TPU 的能效有顯著提升。此數(shù)據(jù)是以每顆芯片封裝在熱設(shè)計(jì)功耗(TDP)下所能達(dá)到的 FP8 峰值運(yùn)算性能(flops per watt)進(jìn)行衡量。

Ironwood 滿(mǎn)足了未來(lái) AI 的需求

Ironwood 憑借其全面提升的計(jì)算能力、內(nèi)存容量、芯片互連技術(shù)進(jìn)展與可靠性,代表推理時(shí)代的一項(xiàng)獨(dú)特關(guān)鍵突破。這些突破,加上近 2 倍的能效提升,意味著我們需求最高的客戶(hù)能以最高的性能與最低的延遲來(lái)處理訓(xùn)練與推理執(zhí)行工作負(fù)載,同時(shí)滿(mǎn)足暴增的計(jì)算需求。

當(dāng)前尖端 AI 模型如 Gemini 2.5 和榮獲諾貝爾獎(jiǎng)的 AlphaFold, 如今都在 TPU 上運(yùn)行。我們迫不及待地想看到我們自己的開(kāi)發(fā)人員和 Google Cloud 客戶(hù)在 Ironwood 今年晚些時(shí)候推出后,會(huì)激發(fā)出哪些 AI 領(lǐng)域的突破。

-

Google

+關(guān)注

關(guān)注

5文章

1789瀏覽量

58937 -

加速器

+關(guān)注

關(guān)注

2文章

827瀏覽量

39074 -

AI

+關(guān)注

關(guān)注

88文章

35000瀏覽量

278696 -

TPU

+關(guān)注

關(guān)注

0文章

153瀏覽量

21172

原文標(biāo)題:Ironwood:首款適用于 AI 推理時(shí)代的 Google TPU

文章出處:【微信號(hào):Google_Developers,微信公眾號(hào):谷歌開(kāi)發(fā)者】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

飛虹IGBT單管FHA75T65V1DL產(chǎn)品介紹

小馬智行亮相2025香港車(chē)博會(huì)

小馬智行第七代自動(dòng)駕駛車(chē)輛廣深開(kāi)跑

小馬智行第七代Robotaxi車(chē)型搭載禾賽AT128激光雷達(dá)

谷歌第七代TPU Ironwood深度解讀:AI推理時(shí)代的硬件革命

谷歌新一代 TPU 芯片 Ironwood:助力大規(guī)模思考與推理的 AI 模型新引擎?

新大陸掃碼器測(cè)評(píng):1秒識(shí)別破損碼,一維二維條碼也能高效識(shí)別

CC2564C雙模Bluetooth?控制器數(shù)據(jù)手冊(cè)

全場(chǎng)景紅外光柵-智能紅外入侵探測(cè)器

博世第七季“數(shù)據(jù)時(shí)代”活動(dòng)圓滿(mǎn)結(jié)束

蘋(píng)果iPad mini開(kāi)啟預(yù)購(gòu),搭載全新A17 Pro芯片

蘋(píng)果推出新一代iPad mini,售價(jià)3999元起

英飛凌推出低功耗CIPOS Maxi智能功率模塊(IPM)系列

英飛凌推出高性能 CIPOS? Maxi 智能功率模塊,適用于功率高達(dá) 4 千瓦的工業(yè)電機(jī)驅(qū)動(dòng)器

利用SLC技術(shù)改善熱導(dǎo)率,增強(qiáng)IGBT模塊功率密度

Google推出第七代TPU芯片Ironwood

Google推出第七代TPU芯片Ironwood

評(píng)論