01算力,已經(jīng)成為先進(jìn)生產(chǎn)力

當(dāng)前承載算力的基礎(chǔ)設(shè)施是各種規(guī)模的的數(shù)據(jù)中心,從幾十個服務(wù)器節(jié)點的小規(guī)模企業(yè)級計算中心到數(shù)萬個節(jié)點的巨型數(shù)據(jù)中心,通過云計算的模式對應(yīng)用層客戶提供存儲、軟件、計算平臺等服務(wù)。這個生態(tài)直接承載了全球數(shù)十萬億美元規(guī)模的數(shù)字經(jīng)濟(jì),而且對全球服務(wù)業(yè)、工業(yè)、農(nóng)業(yè)的滲透率隨著大數(shù)據(jù)、5G、人工智能等技術(shù)的發(fā)展還在不斷提高。算力,已不僅僅是一個技術(shù)指標(biāo),它已經(jīng)成為了先進(jìn)生產(chǎn)力的代表。

算力源于芯片,通過基礎(chǔ)軟件的有效組織,最終釋放到終端應(yīng)用上。目前數(shù)據(jù)中心中核心算力芯片包括CPU、GPU、FPGA和少量的ASIC,其中各類通用CPU的占比還是絕對統(tǒng)治地位。數(shù)據(jù)顯示目前CPU的年出貨量超過200億顆,其中數(shù)據(jù)中心中使用的服務(wù)器端CPU的出貨量約2000萬顆,PC(包括桌面、工作站等)端約2.6億顆。僅在2020年第4季,全球基于ARM IP的芯片出貨達(dá)到了創(chuàng)紀(jì)錄的67億顆;GPU的出貨量也非常可觀,超過4億顆(包括Intel、AMD的集成核顯),大部分都應(yīng)用在各種終端設(shè)備中,如大量消費(fèi)級和工業(yè)級電子產(chǎn)品中。在云端,高性能CPU和GPU是主要的兩種算力芯片——也是規(guī)模最大,單價最高,應(yīng)用環(huán)境最復(fù)雜的芯片。

02負(fù)載分化:從存內(nèi)計算到網(wǎng)內(nèi)計算,出現(xiàn)大量可從CPU卸載的任務(wù)

計算的兩個核心要素:數(shù)據(jù)和計算,在數(shù)據(jù)和計算之間通過復(fù)雜的存儲層次來均衡帶寬、延遲、容量、成本等因素,盡可能讓計算芯片對數(shù)據(jù)能做到“隨用隨取”,然而這在物理上是不可能實現(xiàn)的。將數(shù)據(jù)從生產(chǎn)側(cè)或存儲側(cè)搬運(yùn)到計算節(jié)點上也需要時間和能耗。為了把數(shù)據(jù)搬運(yùn)到完成布爾邏輯的計算單元,已經(jīng)消耗了90%以上的能耗了。過去50年,乘著摩爾定律的東風(fēng),單顆計算芯片的處理性能指數(shù)增長,然而訪存帶寬受限于管腳數(shù)和時鐘頻率僅能做到線性增長,相對而言數(shù)據(jù)搬運(yùn)的開銷被繼續(xù)放大了。端到端的延遲越來越難以控制,要把處理器“喂飽”也變得越來越困難。為了不浪費(fèi)處理器計算容量,只好通過各種共享機(jī)制來相互隱藏數(shù)據(jù)搬運(yùn)的延遲和開銷——而這本身就是一種開銷。

一個直接的想法就是將數(shù)據(jù)靠近計算芯片、或者將計算芯片靠近數(shù)據(jù),而且是物理臨近。出現(xiàn)了“存內(nèi)處理(PIM,Process In Memory)”的概念,也稱之為"In-Memory Computing”,存內(nèi)計算。例如,將一些地址計算,地址轉(zhuǎn)換,校驗碼計算、查找表等設(shè)置在存儲控制器中。但這本質(zhì)上是卸載了部分CPU負(fù)載的計算到內(nèi)存控制器,其實并沒有把CPU完全“嵌入”內(nèi)存,但也算是一種間接的存內(nèi)計算的實現(xiàn)方式。還有一種更依賴新型器件技術(shù)的“存算一體”,比如非易失性存儲單元的阻抗(或?qū)Ъ{)作為被存數(shù)據(jù),當(dāng)在一端施加輸入數(shù)據(jù)(電壓),輸出就是二者的乘積,再通過模擬信號處理,模擬-數(shù)字轉(zhuǎn)換后,得到CPU可以處理的二進(jìn)制數(shù)據(jù);當(dāng)把這些節(jié)點組織稱一個陣列,就相當(dāng)于完成了一次兩個向量的乘累加(MAC)操作。

另外一種存算融合的方式是“近內(nèi)存計算(Near-Memory Computing)”, 主要體現(xiàn)為放置更多的存儲器件(包括非易失性存儲器件)到片上,可以視為一種通過片上集成大內(nèi)存作為一級高速緩存,這種方式更多是存儲技術(shù)和集成技術(shù)來驅(qū)動的,比如已經(jīng)開始采用的高帶寬存儲器(HBM), 得益于3D集成技術(shù),單個存儲堆棧帶寬即可以達(dá)到100GB/s,相比于GDDR5的DRAM的28GB/s,有接近4倍的提升!本質(zhì)上來看,CPU的存儲層次之所以發(fā)展為多層、多級,也是為了使處理器更“靠近”數(shù)據(jù)。

中科馭數(shù)SmartNIC產(chǎn)品

這些技術(shù)都是局部計算和存儲的融合技術(shù),即以單機(jī)、單節(jié)點為優(yōu)化對象。如果把一座數(shù)據(jù)中心視為一臺計算機(jī),正所謂"The Datacenter as a Computer", 那么計算的分布就有新的可能性。數(shù)據(jù)中心雖然可以邏輯上被視為一臺計算機(jī),但其中的節(jié)點是需要通過網(wǎng)絡(luò)互連的。計算的分配、存儲的共享、硬件資源的虛擬化等,都將成為整合數(shù)據(jù)中心資源的開銷。而數(shù)據(jù)中心的CPU和GPU都不是針對數(shù)據(jù)中心的這些負(fù)載來設(shè)計的,諸如網(wǎng)絡(luò)協(xié)議處理、存儲壓縮、數(shù)據(jù)加密。網(wǎng)卡設(shè)備在數(shù)據(jù)中心中起到了關(guān)鍵作用。既然網(wǎng)卡可以處理物理層和鏈路層的數(shù)據(jù)幀,為什么不繼續(xù)卸載網(wǎng)絡(luò)層和部分應(yīng)用層的計算到網(wǎng)卡上來呢?所以網(wǎng)卡從只負(fù)責(zé)節(jié)點間的“互連互通”到可以幫助CPU處理一些底層數(shù)據(jù)處理,其名稱也就從NIC(Network Interface Card)升級成了SmartNIC。網(wǎng)卡也從單純的處理數(shù)據(jù)幀變成了附帶更多計算業(yè)務(wù)的“小服務(wù)器”,拓展成真正的“網(wǎng)內(nèi)計算(In- Network Computing)”。

無論是存內(nèi)計算、近內(nèi)存計算、還是網(wǎng)內(nèi)計算、其最終的目的都是將數(shù)據(jù)所經(jīng)歷的的存儲、傳輸、計算的環(huán)節(jié)做有針對性的處理,提升系統(tǒng)的整體效率。

03計算組織:從“端-云”一體,到“端-邊緣-云”一體

為了承載AIoT、自動駕駛、V2X、智慧城市、智能安防等新興產(chǎn)業(yè),計算的組織也有了很多新的變化。從端-云一體,到端-邊緣-云一體,例如未來自動駕駛中,車將會成為邊緣的一個載體;在5G時代,5G基站也可能會成為一個邊緣節(jié)點,云計算的部分計算功能會下放到邊緣端的算力節(jié)點上,獲得更及時響應(yīng)時間,更節(jié)省的網(wǎng)絡(luò)帶寬 。除 了 邊 緣 計 算 , 在 端 - 云 之 間 甚 至 有 研 究 人 員 提 出 了 “ 霧 計 算 (Fog Computing)”,“霾計算(Mist Computing)”,來不斷的將計算進(jìn)行分層處理,以獲得更好的服務(wù)質(zhì)量,更低的成本。類似于一個國家的行政治理結(jié)構(gòu):省、市、區(qū)、縣等,上級負(fù)責(zé)所轄的下一級整體規(guī)劃,下級負(fù)責(zé)具體實施;在下一級能處理的業(yè)務(wù),就不需要往上一級推送。這樣就可以有序得將計算合理分配到各個計算層次。每個終端業(yè)務(wù)無須關(guān)心是哪一朵“云”在提供服務(wù),也不需要關(guān)心有多少層“云”、是“云”還是“霧”在提供服務(wù)。計算能力將會像電力一樣,通過端-邊緣-云一體化系統(tǒng),“輸送”到用戶。至于電來自于哪一座發(fā)電站,并不重要。這個計算組織結(jié)構(gòu)的變化,直接影響了計算指標(biāo)的演變:從高性能到高效能,進(jìn)而到高通量,最終落實到高生產(chǎn)率計算。

04體系結(jié)構(gòu):通用、專用并舉孕育了“X”PU的新機(jī)遇

目前各類CPU(包括服務(wù)器端、桌面端、移動端、工控和各類嵌入式場景等)的年出貨量超過百億顆,全球平均每人都能達(dá)到3顆CPU的消費(fèi)量,基本可以認(rèn)為CPU已經(jīng)成為一個泛在的器件。建立在CPU上的軟硬件生態(tài),無論是x86還是ARM,也自然成為了整個算力系統(tǒng)的載體,CPU也責(zé)無旁貸地成為了這個體系中的主角。隨著對圖形圖像處理的需求,在上世紀(jì)90年代出現(xiàn)了GPU,并逐漸發(fā)展到目前的GPGPU。隨著深度學(xué)習(xí)算法的爆發(fā),GPU找到了除圖像處理之外的施展空間——神經(jīng)網(wǎng)絡(luò)模型的訓(xùn)練。直至目前,神經(jīng)網(wǎng)絡(luò)訓(xùn)練都是GPU占絕對統(tǒng)治地位。伴隨著這第四次AI浪潮,GPU的全球領(lǐng)導(dǎo)廠商N(yùn)VIDIA的市值也在2020年8月一舉超越了X86 CPU的領(lǐng)導(dǎo)廠商Intel,并一騎絕塵。GPU同時也成為了下一代數(shù)據(jù)中心里算力芯片的又一個重要角色。適逢摩爾定律的放緩,GPU這一領(lǐng)域?qū)S眉軜?gòu)(DSA)技術(shù)路線下的代表,終于成為成為了數(shù)據(jù)中心的核心算力芯片之一。DSA這一技術(shù)路線已經(jīng)被業(yè)界在大范圍內(nèi)認(rèn)可,問題是,下一個DSA的代表是誰?

NVIDIA在2020年公布了對這個問題的看法,他認(rèn)為在未來,CPU、GPU、DPU將成為數(shù)據(jù)中心的三個重要算力芯片,這與我們兩年前的看法不謀而合。我們認(rèn)為,CPU優(yōu)勢是通用和所承載的復(fù)雜的業(yè)務(wù)生態(tài),其定義了軟件生態(tài)和系統(tǒng)的可用性。GPU作為流媒體處理的核心,將繼續(xù)朝著AR、VR的方向發(fā)展。行業(yè)預(yù)測在5G時代,90%的數(shù)據(jù)都將是視頻、圖片等非結(jié)構(gòu)化數(shù)據(jù),GPU必將成為這處理這類負(fù)載的主要引擎。而DPU,將會成為SmartNIC的下一代核心引擎,將軟件定義網(wǎng)絡(luò),軟件定義存儲,軟件定義加速器融合到一個有機(jī)的整體中,解決協(xié)議處理,數(shù)據(jù)安全、算法加速等“CPU做不好,GPU做不了”的計算負(fù)載。我們也大膽預(yù)測,未來數(shù)據(jù)中心的算力引擎將出現(xiàn)CPU、GPU和DPU并舉的情景。DPU不僅僅是網(wǎng)卡芯片,而是全面成為“軟件定義硬件”的重點對象。同時,DPU的市場也不會局限在服務(wù)器端,也會出現(xiàn)在邊緣端,例如智能駕駛的V2X場景,用于解決實時視頻結(jié)構(gòu)化、傳感器數(shù)據(jù)融合,和一些消費(fèi)級的DPU產(chǎn)品,用于在隱私保護(hù)等業(yè)務(wù)上提升終端的用戶體驗。

05DPU如何變革下一代計算基礎(chǔ)設(shè)施

DPU是 Data Processing Unit的簡稱。

DPU將作為CPU的卸載引擎,釋放CPU的算力到上層應(yīng)用。以網(wǎng)絡(luò)協(xié)議處理為例,要線速處理10G的網(wǎng)絡(luò)需要的大約4個Xeon CPU的核,也就是說,單是做網(wǎng)絡(luò)數(shù)據(jù)包處理,就可以占去一個8核高端CPU的一半的算力。如果考慮40G、100G的高速網(wǎng)絡(luò),性能的開銷就更加難以承受了。Amazon把這些開銷都稱之為“Datacenter Tax”——還未運(yùn)行業(yè)務(wù)程序,先接入網(wǎng)絡(luò)數(shù)據(jù)就要占去的計算資源。AWS Nitro產(chǎn)品家族旨在將數(shù)據(jù)中心開銷(為虛機(jī)提供遠(yuǎn)程資源,加密解密,故障跟蹤,安全策略等服務(wù)程序)全部從CPU卸載到Nitro加速卡上,將給上層應(yīng)用釋放30%的原本用于支付“Tax” 的算力!

DPU將成為新的數(shù)據(jù)網(wǎng)關(guān),將安全隱私提升到一個新的高度。在網(wǎng)絡(luò)環(huán)境下,網(wǎng)絡(luò)接口是理想的隱私的邊界,但是加密、解密的算法開銷都很大,例如國密標(biāo)準(zhǔn)的非對稱加密算法SM2、哈希算法SM3和對稱分組密碼算法SM4。如果用CPU來處理,就只能做少部分?jǐn)?shù)據(jù)量的加密。在未來,隨著區(qū)塊鏈承載的業(yè)務(wù)的逐漸成熟,運(yùn)行共識算法POW,驗簽等也會消耗掉大量的CPU算力。而這些都可以通過將其固化在DPU中來實現(xiàn),甚至DPU將成為一個可信根。

DPU將成為存儲的入口,將分布式的存儲和遠(yuǎn)程訪問本地化。隨著SSD性價比逐漸變得可接受,部分存儲遷移到SSD器件上已經(jīng)成為可能,傳統(tǒng)的面向機(jī)械硬盤的SATA協(xié)議并不適用于SSD存儲,所以,將SSD通過本地PCIE或高速網(wǎng)絡(luò)接入系統(tǒng)就成為必選的技術(shù)路線。NVMe(Non Volatile Memory Express)就是用于接入SSD存儲的高速接口標(biāo)準(zhǔn)協(xié)議,可以通過PCIe作為底層傳輸協(xié)議,將SSD的帶寬優(yōu)勢充分發(fā)揮出來。同時,在分布式系統(tǒng)中,還可通過NVMe over Fabric協(xié)議擴(kuò)展到InfiniBand、或TCP互連的節(jié)點中,實現(xiàn)存儲的共享和遠(yuǎn)程訪問。這些新的協(xié)議處理都可以集成在DPU中來實現(xiàn)對CPU的透明處理。進(jìn)而,DPU將可能承接各種互連協(xié)議控制器的角色,在靈活性和性能方面達(dá)到一個更優(yōu)的平衡點。

DPU將成為算法加速的沙盒,成為最靈活的加速器載體。DPU不完全是一顆固化的ASIC,在CXL, CCIX等標(biāo)準(zhǔn)組織所倡導(dǎo)CPU、GPU與DPU等數(shù)據(jù)一致性訪問協(xié)議的鋪墊下,將更進(jìn)一步掃清DPU編程障礙,結(jié)合FPGA等可編程器件,可定制硬件將有更大的發(fā)揮空間,“軟件硬件化”將成為常態(tài),異構(gòu)計算的潛能將因各種DPU的普及而徹底發(fā)揮出來。在出現(xiàn)“Killer Application”的領(lǐng)域都有可能出現(xiàn)與之相對應(yīng)的DPU,諸如傳統(tǒng)數(shù)據(jù)庫應(yīng)用如OLAP、OLTP, 或新興應(yīng)用如智能駕駛等。

06中科馭數(shù)的DPU方案:KPU1+KPU2+......=DPU

鑒于以上的認(rèn)知,中科馭數(shù)在這條賽道上已經(jīng)布局。馭數(shù)采取了以算法加速為核心,以網(wǎng)絡(luò)加速為切入點的策略,以清晰的行業(yè)應(yīng)用為驅(qū)動,做直接面向應(yīng)用的DPU。先單點打通,再按需擴(kuò)展的策略。

現(xiàn)有的DPU大體上有兩種類型:1)以通用眾核為基礎(chǔ)的同構(gòu)眾核DPU,類似早期以處理數(shù)據(jù)包為目的的網(wǎng)絡(luò)處理器,例如Broadcom的的Stingray架構(gòu),以多核ARM為核心,以眾取勝。得益于通用處理器核(絕大部分都是ARM系列),可編程性比較好,但是應(yīng)用的針對性不夠,對于特殊算法和應(yīng)用的支持相對于通用CPU沒有優(yōu)勢。2)以專用核為基礎(chǔ),構(gòu)建異構(gòu)核陣列。這種結(jié)構(gòu)針對性強(qiáng),性能最好,但犧牲了部分靈活性。現(xiàn)有的最新的產(chǎn)品趨勢都是二者的折中,而且專用核的比重越來越來大,NVIDIA最新的BlueField2系列DPU的結(jié)構(gòu)就包括4個ARM核再加多個專用加速核區(qū)域,F(xiàn)ungible的DPU包含52個MIPS小型通用核,但還包含6個大類的專用核。

中科馭數(shù)的DPU是以KPU為運(yùn)算核心,以高速傳輸和存儲總結(jié)為接口,弱通用化控制的數(shù)據(jù)面領(lǐng)域?qū)S锰幚砥鳌?/span>

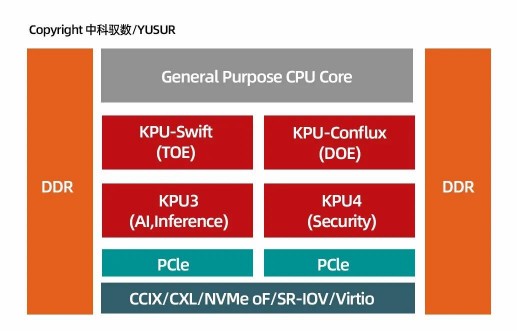

馭數(shù)K2系列DPU架構(gòu)

上圖展示了馭數(shù)DPU的頂層結(jié)構(gòu),其核心是四類KPU的異構(gòu)核陣列,分別處理網(wǎng)絡(luò)協(xié)議,OLAP\OLTP處理,機(jī)器學(xué)習(xí)和安全加密運(yùn)算核。不同于Broadcom,F(xiàn)ungible等廠商,我們將重點放在了異構(gòu)核上,即以針對性算法加速為核心,馭數(shù)提出了KPU架構(gòu),來組織異構(gòu)核。在KPU架構(gòu)下,馭數(shù)提出了完善的L2/ L3/L4層的網(wǎng)絡(luò)協(xié)議處理,提出了直接面向OLAP、OLTP的數(shù)據(jù)查詢處理核,而沒有采用原來眾核為主的架構(gòu)。這一路線與NVIDIA的技術(shù)路線更接近,但更加側(cè)重異構(gòu)核的使用。看似犧牲了部分通用核的可編程性,但換來的是更高效的處理效率,更直接的使用接口,更瘦的運(yùn)行時系統(tǒng)和更佳的虛擬化支持。一個理想的DPU必然不像CPU,才有可能與CPU更好的互補(bǔ)。通用的計算不應(yīng)該、也不需要卸載到DPU上,而可卸載到DPU上的負(fù)載必然也不需要在基礎(chǔ)算子層面來進(jìn)行運(yùn)算控制。

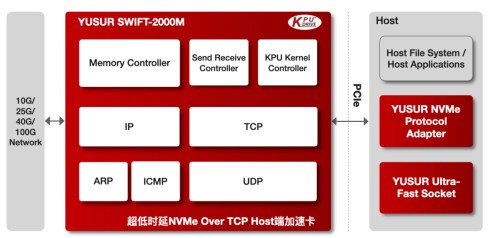

馭數(shù)超低時延NVMeOver TCP Host端加速卡架構(gòu)圖

中科馭數(shù)的DPU頂層架構(gòu)支撐了馭數(shù)其中一條重要產(chǎn)品線:SWIFT系列的網(wǎng)絡(luò)加速卡。SWIFT?-2000M是中科馭數(shù)KPU-SWIFT?網(wǎng)絡(luò)加速產(chǎn)品系列中一款超低時延NVMe Over TCP網(wǎng)絡(luò)端加速卡,基于中科馭數(shù)KPU架構(gòu)和自主研發(fā)的全硬件TCP/IP協(xié)議簇解決方案,它集成了完整的TCP、UDP、ARP、ICMP和IP等協(xié)議處理模塊,配套馭數(shù)的高性能PCIe驅(qū)動和NVMe協(xié)議的軟件接口適配,從而實現(xiàn)NVMe over TCP的網(wǎng)絡(luò) 端全功能極速系統(tǒng)。SWIFT?-2000M集成了豐富的系統(tǒng)運(yùn)行狀態(tài)監(jiān)測功能,擁有硬件處理的TCP包傳輸、數(shù)據(jù)重傳、亂序重排、ping等完備的功能,解決10G/100G高速NVMe-oF場景下網(wǎng)絡(luò)協(xié)議處理CPU資源占用過高、解析過慢的痛點,大幅提升系統(tǒng)吞吐,優(yōu)化遠(yuǎn)端存儲訪問效率。

中科馭數(shù)首顆芯片于2019年成功流片

07未來展望:構(gòu)建專用處理器系統(tǒng)結(jié)構(gòu)的幾個關(guān)鍵點

專用處理器與通用處理器是處理器發(fā)展的兩個互補(bǔ)的方向,雖然單獨(dú)一類專用處理器的市場要遠(yuǎn)小于通用處理器,但是多類專用處理器的市場總和將遠(yuǎn)遠(yuǎn)大于通用處理器的市場。而且,專用處理器的發(fā)展將會在很多增量的應(yīng)用市場中占有絕對的性能優(yōu)勢,而受到的通用計算的生態(tài)限制更少,有利于專用架構(gòu)逐步擴(kuò)展去覆蓋更長尾端的應(yīng)用。

在過去處理器芯片發(fā)展的60年里,前50年都是通用處理器的發(fā)展以絕對優(yōu)勢占據(jù)了處理器芯片的市場份額,相信在接下來的30年,隨著數(shù)據(jù)的爆發(fā)和“端云一體”這種計算范式的繼續(xù)滲透,將形成通用處理器與專用處理器并行的新局面,在2020年7月的COMMUNICATIONS OF THE ACM中,有一篇文章提出了一個新概念:“ASIC Clouds”, 全文標(biāo)題是“ASICClouds: Specializing the Datacenterfor Planet-Scale Applications”,這里的“ASIC”其實就是各種專用處理器的呈現(xiàn)形式,我們相信專用處理器將迎來空前的增長機(jī)遇。

我們認(rèn)為構(gòu)建專用處理器系統(tǒng)結(jié)構(gòu)有以下幾個關(guān)鍵點:

▲ 針對“數(shù)據(jù)平面”的計算架構(gòu)

專用計算體系結(jié)構(gòu)和通用計算體系結(jié)構(gòu)的陣地是不同的,專用計算競爭的焦點是數(shù)據(jù)平面,而通用計算競爭的焦點是控制平面。專用計算好比是造賽車,目標(biāo)就是快,重點是根據(jù)賽道的類型來決定賽車的結(jié)構(gòu);通用計算好比是造民用車,目標(biāo)更加的多元化,不僅要兼顧不同路況下的可用性,還要考慮性價比、代際兼容性。所以,以通用CPU的標(biāo)準(zhǔn)來看待專用XPU可能并不合適,甚至?xí)萍s了專用處理器的發(fā)展。

▲融合創(chuàng)新技術(shù)

計算架構(gòu)的范疇不僅僅是狹義的處理器芯片,還包括相應(yīng)的存儲、傳輸、集成工藝等,是一個系統(tǒng)性概念。專用計算由于其“專用”的屬性,對融合新技術(shù)更有優(yōu)勢,例如,引入高速非易失性存儲(NVMe),利用 “NVMe oF”技術(shù)構(gòu)建更高效的分布式存儲系統(tǒng);將主機(jī)內(nèi)存直接連接在PCIe設(shè)備端,建立更大、更快的遠(yuǎn)程直接內(nèi)存訪問(RDMA);集成HBM支持更大的片上數(shù)據(jù)集,更高效的數(shù)據(jù)平面操作;將神經(jīng)網(wǎng)絡(luò)計算融入網(wǎng)內(nèi)計算,透明賦能需要推理的場景。

▲面向的領(lǐng)域?qū)S妹枋稣Z言

應(yīng)用都是可以進(jìn)行無二意性的語言進(jìn)行描述的,專用計算也不例外。對應(yīng)用的描述層是專用計算架構(gòu)的邊界:描述層之上是客戶的實際應(yīng)用程序,描述層之下都是專用計算系統(tǒng)涉及定制的部分。整個系統(tǒng)的參考邊界由傳統(tǒng)ISA(指令集)上升到了DSL(Domain-specific Language)。例如,P4編程語言是面向SDN的領(lǐng)域?qū)S谜Z言,專門用于定義路由器和交換機(jī)如何轉(zhuǎn)發(fā)數(shù)據(jù)包,屬于數(shù)據(jù)平面的編程語言。至于網(wǎng)絡(luò)處理器是用ARM還是MIPS,或是X86并不重要。現(xiàn)在的深度學(xué)習(xí)框架例如TensorFlow,其實也是提供了一整套定義深度學(xué)習(xí)模型結(jié)構(gòu)、描述模型訓(xùn)練方法的DSL;還有面向數(shù)據(jù)庫的SQL,本身就是一種聲明式(Declaritive)的DSL編程語言,有望成為新專用處理器設(shè)計的參考邊界。

▲先垂直深耕,再水平擴(kuò)展

對于專用計算架構(gòu)業(yè)界的一個普遍的共識是“碎片化”問題,挑戰(zhàn)“one-size-fitall”的ASIC商業(yè)模式。傳統(tǒng)上認(rèn)為碎片化意味著單個產(chǎn)品線難以上量,難以攤薄芯片研發(fā)的巨額一次性投入,即所謂的高昂的NRE成本。一個有商業(yè)價值的技術(shù)必須建立在“技術(shù)閉環(huán)”的基礎(chǔ)上:研發(fā)、使用、反饋、再研發(fā)改進(jìn)、再擴(kuò)大使用范圍……。技術(shù)只有投入使用才能體現(xiàn)價值,有使用價值才有可能商業(yè)化,才能完成技術(shù)閉環(huán)到商業(yè)閉環(huán)的進(jìn)化。技術(shù)閉環(huán)的形成需要集中火力,全鏈條主動出擊才能鋪就。碎片化并不是“專用”障礙,反而應(yīng)該是專用技術(shù)路線充分利用的優(yōu)勢。(END)

發(fā)布評論請先 登錄

貴安發(fā)展集團(tuán)攜手華為開創(chuàng)數(shù)字經(jīng)濟(jì)新未來

中科馭數(shù)攜DPU全棧產(chǎn)品亮相福州數(shù)博會,賦能智算時代算力基建

大算力芯片的生態(tài)突圍與算力革命

DeepSeek對芯片算力的影響

算智算中心的算力如何衡量?

算力經(jīng)濟(jì)下DPU芯片的發(fā)展機(jī)遇

算力經(jīng)濟(jì)下DPU芯片的發(fā)展機(jī)遇

評論