01、背景

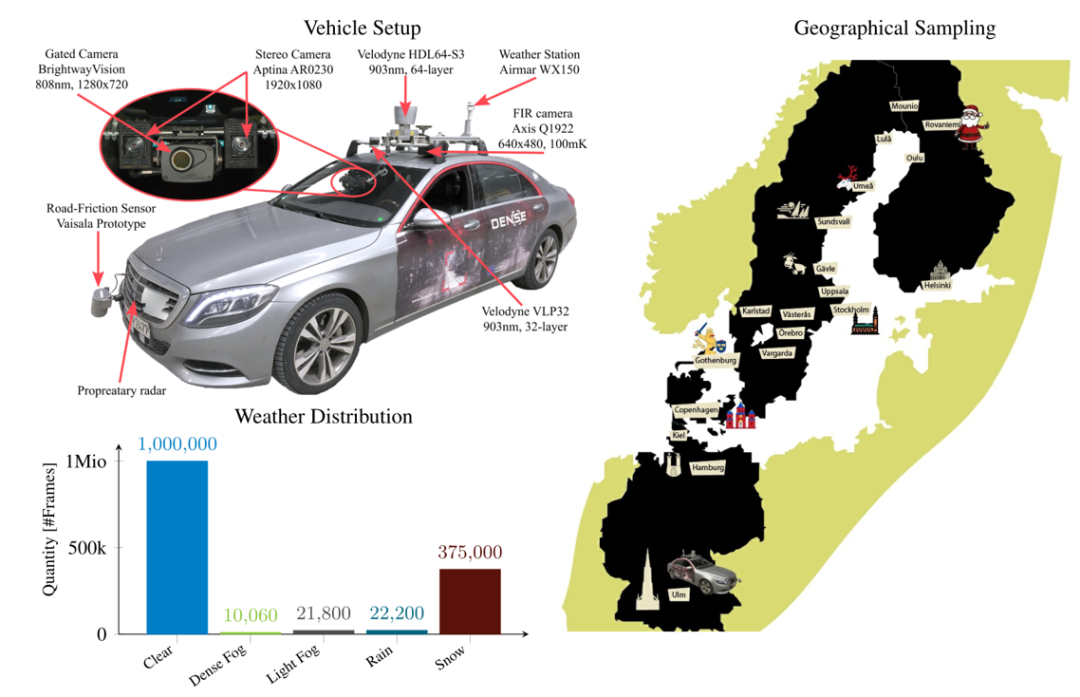

作為計算機視覺中的一項基礎任務,目標檢測受到了廣泛的關注。在惡劣的天氣下,尤其是在霧天環境下,大氣中存在很多渾濁介質(如顆粒、水滴等),傳統相機可見光難以穿透顆粒介質,因此惡劣天氣下的數據非常罕見,現有的檢測架構依賴于未失真的傳感器流,而惡劣天氣下傳感器會產生非對稱的失真,使得戶外場景圖像出現退化和降質,清晰度低和對比度低,細節特征模糊不清等特點,對于在高質量圖像下訓練的目標檢測模型,往往無法準確的定位目標,是當前目標檢測任務中的一大挑戰,同時也是當前如何在復雜天氣環境下進行視覺自主導航的一大挑戰。為解決這個問題,Bijelic提出了一個新的多模式數據集,該數據集是在北歐10,000 多公里的行駛中獲得的。此數據集是惡劣天氣下的第一個大型的多模式數據集,且具有10 萬個激光雷達、相機、雷達和門控NIR傳感器的標簽。同時Bijelic提出了一種深層融合網絡,可進行穩健的融合,而無需涵蓋所有非對稱失真的大量標記訓練數據。從提議級融合出發,提出了一種由測量熵驅動的自適應融合特征的單鏡頭模型。

02、數據集介紹

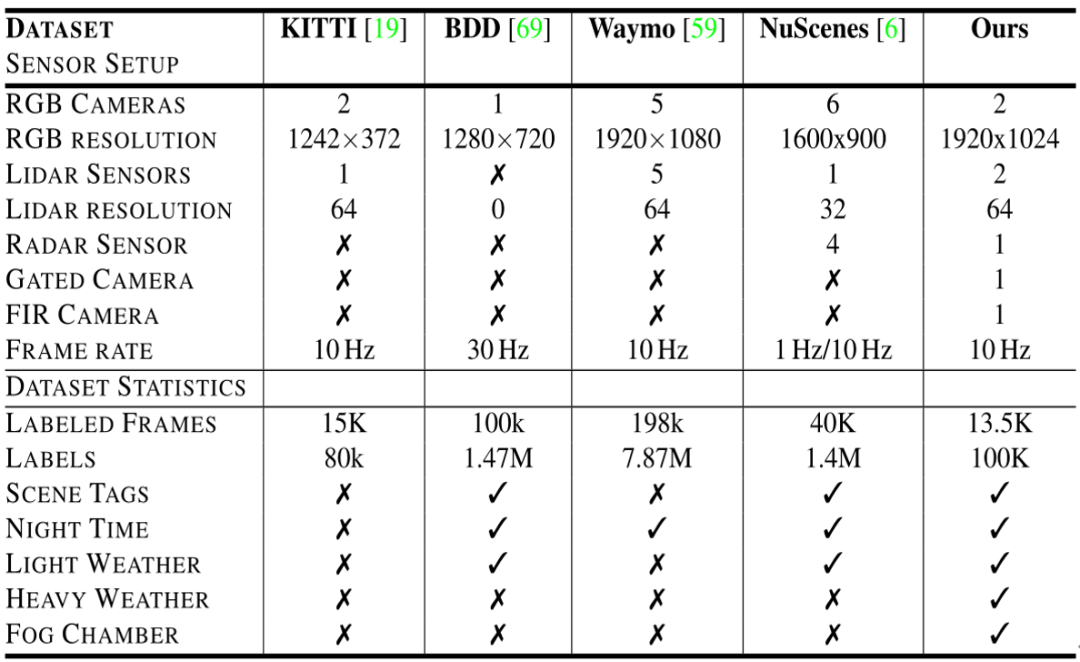

為了評估惡劣天氣中的目標檢測,Bijelic進行了實地測試,構建了一個大型的汽車數據集,該數據集提供了用于多模式數據的2D 和3D 檢測邊界框,并對罕見惡劣天氣情況下的天氣,光照和場景類型進行了精細分類。表中比較了提出的數據集和最近的大規模汽車數據集,例如Waymo,NuScenes,KITTI和BDD數據集。與NuScenes和BDD相比,該數據集不僅包含在晴朗天氣條件下的實驗數據,還包含在大雪,雨天和霧中的實驗數據。

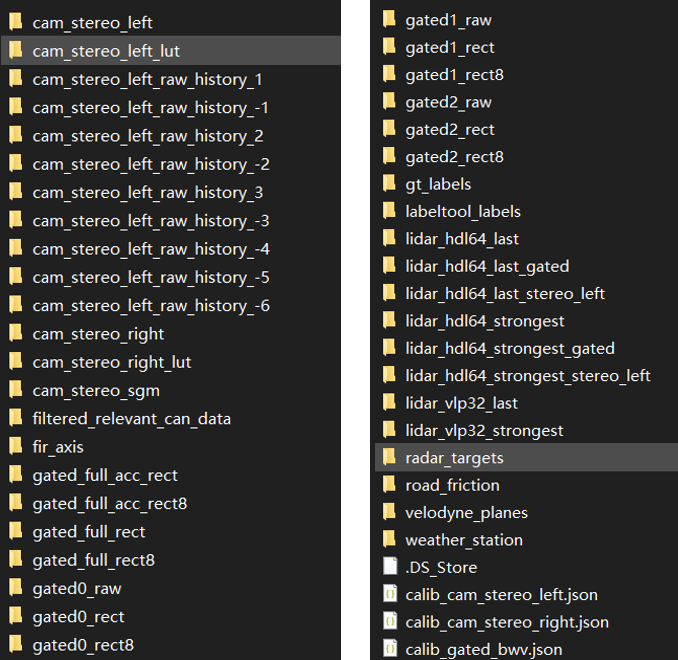

所有實驗數據分別在德國,瑞典,丹麥和芬蘭獲得,在不同的天氣和光照條件下覆蓋了10,000km 的距離。以10Hz 的幀速率共收集了140 萬幀。每第100 幀都經過手動標記,以平衡場景類型的覆蓋范圍。生成的注釋包含5500個晴天,1000個濃霧,1 000個薄霧,4000個雪/雨。本數據集具體包含文件如下圖所示。

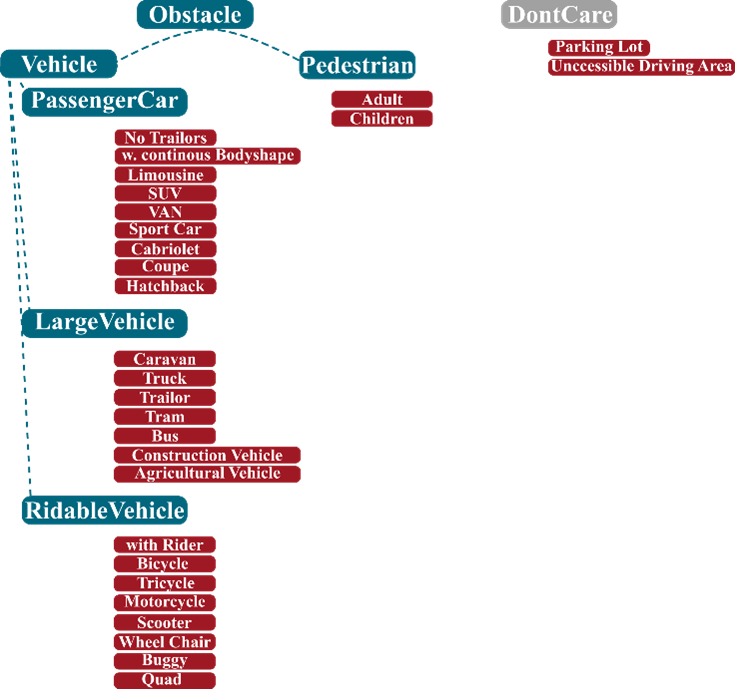

對于該數據集的使用,目前由于作者還未開源融合網絡,暫時只能使用源數據,但是也算為后續惡劣天氣下的多傳感器融合3D目標檢測提供了真實環境下的數據集。若僅針對于純圖像2D目標檢測或3D檢測來說,該數據集中可用于驗證作用,或者以混合數據形式作為訓練集,但是僅使用該數據集做為驗證和訓練可能不足以支撐網絡學習。正如下圖數據集具體標簽所示,其標簽主要包括五類,藍色為注釋標簽,紅色為該標簽所包括的類別。注意若使用該數據集為訓練集,其他數據集為驗證集要重新歸一標簽,與其他數據集標簽重合度較低,重新清洗數據也是使用該數據集的一個難點。

03、自適應多模式單次融合

1、網絡架構

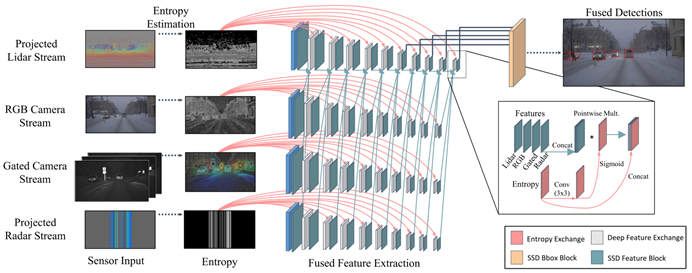

數據表示。相機分支使用常規的三平面RGB 輸入,而對于激光雷達和雷達分支,本文的方法與最近的鳥瞰(BeV)投影方案或原始點云表示不同。BeV 投影或點云輸入不允許進行深度的早期融合,因為早期圖層中的特征表示與相機特征天生不同。因此,現有的BeV 融合方法只能在建議匹配區域之后進行提升空間中的特征融合,而不能提前。圖中可視化了本文提出的輸入數據編碼,該編碼有助于進行深度多模態融合。深度,高度和脈沖強度作為激光雷達網絡的輸入,而不是僅使用樸素的深度輸入編碼。對于雷達網絡,假設雷達在與圖像平面正交和與水平圖像尺寸平行的2D 平面中進行掃描。因此,考慮沿垂直圖像軸雷達的不變性,并沿垂直軸復制掃描。使用單應性映射將門控圖像轉換為RGB 相機的圖像平面。本文所提出的輸入編碼使用不同流之間的逐像素對應,可以實現與位置和強度相關的融合,用零值來編碼缺失的測量樣本。

特征提取。作為每個流中的特征提取堆棧,本文使用了改進的VGG主干。將通道數量減少一半,并在conv4 層上切斷網絡,使用conv4-10中的六個要素層作為SSD 檢測層的輸入。特征圖隨尺寸減小,實現了一個用于不同比例檢測的特征金字塔。如結構圖所示,不同特征提取堆棧的激活進行了交換。為了使融合更加可靠,為每個特征交換塊提供了傳感器熵。首先對熵進行卷積,應用Sigmoid與來自所有傳感器的級聯輸入特征相乘,最后級聯輸入熵。熵的折疊和Sigmoid的應用在區間[0,1] 中生成一個乘法矩陣,這可以根據可用信息分別縮放每個傳感器的級聯特征。具有低熵的區域可以被衰減,而富熵的區域可以在特征提取中被放大。這樣能夠在特征提取堆棧中實現自適應融合特征

2、實驗

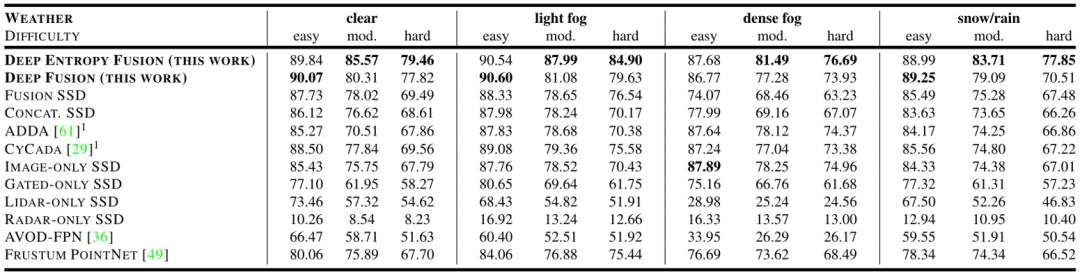

在惡劣天氣的實驗測試數據上驗證所提出的融合模型。將這種方法與現有的單傳感器輸入和融合的檢測器,以及域自適應方法進行比較。由于訓練數據獲取存在天氣偏向,僅使用提出的數據集的晴朗天氣部分進行訓練,使用Bijelic提出新的多模式天氣數據集作為測試集來評估檢測性能。結果如圖所示。

總體而言,由圖中可看到隨著霧密度的增加,特別是在嚴重失真的情況下,該文所提出的自適應融合模型的性能優于所有其他方法,與次佳的特征融合變體相比,它提高了9.69%的幅度。但是在有霧條件下,激光雷達的性能也同樣具有很大的局限性,在僅激光雷達情況下的檢測率,AP下降了45.38%。此外,它還對相機-激光雷達融合模型AVOD,Concat SSD 和Fusion SSD產生了重大影響。它使得學習到的冗余不再成立,這些方法甚至低于僅使用圖像的方法。

04、結論

所提出的數據集解決了自動駕駛中的一個關鍵問題:場景中的多傳感器融合和其中注釋數據稀少且由于自然的天氣偏向而難以獲取的圖像數據。為后續的研究者引入了一個新穎的惡劣天氣數據集,涵蓋了不同天氣情況下的相機、激光雷達、雷達、門控NIR 和FIR 傳感器數據。同時提出的一個實時的深度多模態融合網絡不同于提案層的融合,而是由測量熵驅動自適應融合。

該方法一定程度上改進惡劣天氣條件下智能自主駕駛車輛在戶外環境下進行精確的視覺感知能力,同時也能為后續視覺導航在復雜天氣環境下進行精確建圖提供高精度的目標定位。

雖然該數據集提出一定程度上填補了多模態數據集的缺失,但是由于自然偏向的問題,惡劣天氣采集到的圖像還是較少,仍然不適用于網絡的訓練,如何解決惡劣天氣條件下數據集稀少或者降低深度學習網絡對于數據樣本的依賴性仍亟待改進。

審核編輯:郭婷

-

傳感器

+關注

關注

2565文章

52869瀏覽量

766372 -

計算機

+關注

關注

19文章

7653瀏覽量

90622 -

數據集

+關注

關注

4文章

1223瀏覽量

25392

原文標題:基于多模態自適應熵驅動融合的惡劣天氣自動駕駛視覺感知技術研究

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

智能軟件+硬件解決方案克服實時立體視覺中的挑戰

【「# ROS 2智能機器人開發實踐」閱讀體驗】視覺實現的基礎算法的應用

【「# ROS 2智能機器人開發實踐」閱讀體驗】+ROS2應用案例

【「# ROS 2智能機器人開發實踐」閱讀體驗】+內容初識

智慧路燈如何應對極端天氣?

DLP6500想調用API進行自主二次開發,怎么構建開發環境?

如何在惡劣環境下選擇和應用雷達傳感器

機器人“大腦+小腦”范式:算力魔方賦能智能自主導航

NaVILA:加州大學與英偉達聯合發布新型視覺語言模型

Xsens Sirius-在嚴苛環境中進行3D慣性導航

復雜環境下多無人智能車輛協同調控

Bumblebee X 立體相機提升工業自動化中的立體深度感知

agv叉車激光導航和二維碼導航有什么區別?適用什么場景?選哪種比較好?

如何在復雜天氣環境下進行視覺自主導航

如何在復雜天氣環境下進行視覺自主導航

評論