最近爆火的AI繪圖,相信大家并不陌生了。

從AI繪圖軟件生成的作品打敗一眾人類藝術(shù)家,斬獲數(shù)字藝術(shù)類冠軍,到如今DALL.E、Imagen、novelai等國內(nèi)外平臺遍地開花。也許你也曾點開過相關(guān)網(wǎng)站,嘗試讓AI描繪你腦海中的風(fēng)景,又或者上傳了一張自己帥氣/美美的照片,然后對著最后生成的糙漢哭笑不得。那么,在你感受AI繪圖魅力的同時,有沒有想過(不你肯定想過),它背后的奧妙究竟是什么?

美國科羅拉多州技術(shù)博覽會中獲得數(shù)字藝術(shù)類冠軍的作品——《太空歌劇院》

一切,都要從一個名為DDPM的模型說起…

話說DDPM

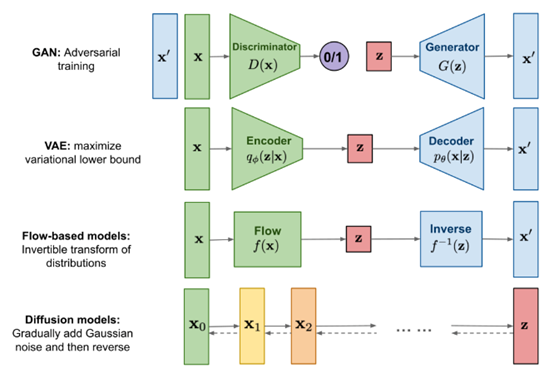

DDPM模型,全稱Denoising Diffusion Probabilistic Model,可以說是現(xiàn)階段diffusion模型的開山鼻祖。不同于前輩GAN、VAE和flow等模型,diffusion模型的整體思路是通過一種偏向于優(yōu)化的方式,逐步從一個純噪音的圖片中生成圖像。

現(xiàn)在已有生成圖像模型的對比

沒有相關(guān)機(jī)器學(xué)習(xí)背景的小伙伴可能會問了,什么是純噪音圖片?

很簡單,老式電視機(jī)沒信號時,伴隨著"刺啦刺啦"噪音出現(xiàn)的雪花圖片,就屬于純噪音圖片。而DDPM在生成階段所做的事情,就是把這些個"雪花"一點點移除,直到清晰的圖像露出它的廬山真面目,我們把這個階段稱之為"去噪"。

純噪音圖片:老電視的雪花屏

通過描述,大家可以感受到,去噪其實是個相當(dāng)復(fù)雜的過程。沒有一定的去噪規(guī)律,可能你忙活了好半天,到最后還是對著奇形怪狀的圖片欲哭無淚。當(dāng)然,不同類型的圖片也會有不同的去噪規(guī)律,至于怎么讓機(jī)器學(xué)會這種規(guī)律,有人靈機(jī)一動,想到了一種絕妙的方法。

"既然去噪規(guī)律不好學(xué),那我為什么不先通過加噪的方式,先把一張圖片變成純噪音圖像,再把整個過程反著來一遍呢?"

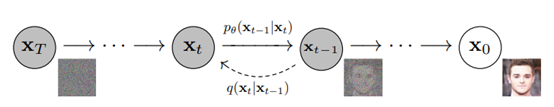

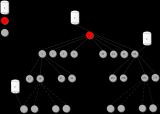

這便奠定了diffusion模型整個訓(xùn)練-推理的流程,先在前向過程(forward process)通過逐步加噪,將圖片轉(zhuǎn)換為一個近似可用高斯分布的純噪音圖像,緊接著在反向過程(reverse process)中逐步去噪,生成圖像,最后以增大原始圖像和生成圖像的相似度作為目標(biāo),優(yōu)化模型,直至達(dá)到理想效果。

DDPM的訓(xùn)練-推理流程

到這里,不知道大家的接受度怎樣?如果感覺沒問題,輕輕松的話。準(zhǔn)備好,我要開始上大招(深入理論)啦。

1.前向過程(forward process)

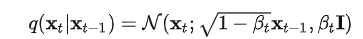

又稱為擴(kuò)散過程(diffusion process),整體是一個參數(shù)化的馬爾可夫鏈(Markov chain)。從初始數(shù)據(jù)分布 出發(fā),每步在數(shù)據(jù)分布中添加高斯噪音,持續(xù)T次。其中從第t-1步到第t步的過程可以用高斯分布表示為:

通過合適的設(shè)置,隨著t不斷增大,原始數(shù)據(jù)會逐漸失去他的特征。我們可以理解為,在進(jìn)行了無限次的加噪步驟后,最終的數(shù)據(jù)會變成沒有任何特征,完全是隨機(jī)噪音的圖片,也就是我們最開始說的"雪花屏"。

在這個過程中,每一步的變化是可以通過設(shè)置超參來控制,在我們知曉最開始的圖片是什么的前提下,前向加噪的整個過程可以說是已知且可控的,我們完全能知道每一步的生成數(shù)據(jù)是什么樣子。

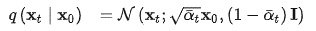

但問題在于,每次的計算都需要從起始點出發(fā),結(jié)合每一步的過程,慢慢推導(dǎo)至你想要的某步數(shù)據(jù),過于麻煩。好在因為高斯分布的一些特性,我們可以一步到位,直接從得到。

(這里的和為組合系數(shù),本質(zhì)上是超參的表達(dá)式)

2.反向過程(reverse process)

和前向過程同理,反向過程也是一個馬爾可夫鏈(Markov chain),只不過這里用到的參數(shù)不同,至于具體參數(shù)是什么,這個就是我們需要機(jī)器來學(xué)習(xí)的部分啦。

在了解機(jī)器如何學(xué)習(xí)前,我們首先思考,基于某一個原始數(shù)據(jù),從第t步,精準(zhǔn)反推回第t-1步的過程應(yīng)該是怎樣的?

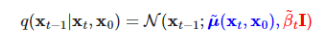

答案是,這個仍可以用高斯分布表示:

注意這里必須要考慮,意思是反向過程最后生成圖像還是要與原始數(shù)據(jù)有關(guān)。輸入貓的圖片,模型生成的圖像應(yīng)該是貓,輸入狗的圖片,生成的圖像也應(yīng)該和狗相關(guān)。若是去除掉,則會導(dǎo)致無論輸入哪種類型的圖片訓(xùn)練,最后diffusion生成的圖像都一樣,"貓狗不分"。

經(jīng)過一系列的推導(dǎo),我們發(fā)現(xiàn),反向過程中的參數(shù)和,竟然還是可以用,,以及參數(shù),表示出來的,是不是很神奇~

當(dāng)然,機(jī)器事先并不知道這個真實的反推過程,它能做到的,只是用一個大概近似的估計分布去模擬,表示為。

3.優(yōu)化目標(biāo)

在最開始我們提到,需要通過增大原始數(shù)據(jù)和反向過程最終生成數(shù)據(jù)的相似度來優(yōu)化模型。在機(jī)器學(xué)習(xí)中,我們計算該相似度參考的是交叉熵(cross entropy )。

關(guān)于交叉熵,學(xué)術(shù)上給出的定義是"用于度量兩個概率分布間的差異性信息"。換句話講,交叉熵越小,模型生成的圖片就越和原始圖片接近。但是,在大多數(shù)情況下,交叉熵是很難或者無法通過計算得出的,所以我們一般會通過優(yōu)化一個更簡單的表達(dá)式,達(dá)到同樣的效果。

Diffusion模型借鑒了VAE模型的優(yōu)化思路,將variational lower bound(VLB,又稱ELBO)替代cross entropy來作為最大優(yōu)化目標(biāo)。通過無數(shù)步的分解,我們最終得到:

看到這么復(fù)雜的公式,好多小伙伴肯定頭都大了。但不慌,這里需要關(guān)注的,只是中間的罷了,它表示的是和之間估計分布和真實分布的差距。差距越小,模型最后生成圖片的效果就越好。

4.上代碼

在了解完DDPM背后的原理,接下來就讓我們看看DDPM模型究竟是如何實現(xiàn)…

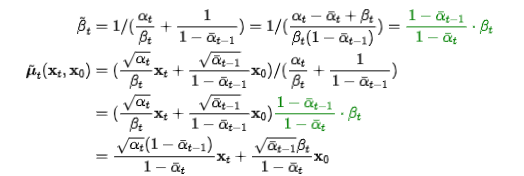

才怪啦。相信看到這里的你,肯定也不想遭受成百上千行代碼的洗禮。好在MindSpore已經(jīng)為大家提供了開發(fā)完備的DDPM模型,訓(xùn)練推理兩手抓,操作簡單,單卡即可運行,想要體驗效果的小伙伴,可以先pip install denoising-diffusion-mindspore后,參考如下代碼配置參數(shù):

對重要的參數(shù)進(jìn)行一些解析:

-

GaussianDiffusion

- image_size: 圖片大小

- timesteps: 加噪步數(shù)

- sampling_timesteps: 采樣步數(shù),為提升推理性能,需小于加噪步數(shù)

-

Trainer

- folder_or_dataset: 對應(yīng)圖片中的path, 可以是已下載數(shù)據(jù)集的路徑(str),也可以是已做好數(shù)據(jù)處理的VisionBaseDataset, GeneratorDataset 或 MindDataset

- train_batch_size:batch大小

- train_lr: 學(xué)習(xí)率

- train_num_steps: 訓(xùn)練步數(shù)

話說MindDiffusion

DDPM只是Diffusion這個故事的開篇。目前,已有無數(shù)的研究人員被其背后瑰麗的世界所吸引,紛紛投身其中。在不斷優(yōu)化模型的同時,也逐漸開發(fā)了Diffusion在各個領(lǐng)域的應(yīng)用。

其中,包括了計算機(jī)視覺領(lǐng)域的圖像優(yōu)化、inpainting、3D視覺,自然語言處理中的text-to-speech,AI for Science領(lǐng)域的分子構(gòu)象生成、材料設(shè)計等,更有來自斯坦福大學(xué)計算機(jī)科學(xué)系的博士生Eric Zelikman大開腦洞,嘗試將DALLE-2與最近另一個大火的對話模型ChatGPT相結(jié)合,制作出了溫馨的繪本故事。

DALLE-2 + ChatGPT合力完成的,關(guān)于一個名叫"羅比"的小機(jī)器人的故事

不過最廣為大眾所知的,應(yīng)該還是它在文生圖(text-to-image)方面的應(yīng)用。輸入幾個關(guān)鍵詞或者一段簡短的描述,模型便可以為你生成相對應(yīng)的圖畫。

比如,輸入"城市夜景 賽博朋克 格雷格.路特科夫斯基",最后生成的便是一張色彩鮮明,頗具未來科幻風(fēng)格的作品。

再比如,輸入"莫奈 撐陽傘的女人 月亮 夢幻",生成的便是一張極具有朦朧感的女人畫像,色彩搭配的風(fēng)格有木有讓你想起莫奈的《睡蓮》?

想要寫實風(fēng)格的風(fēng)景照作為屏保?沒問題!

鄉(xiāng)村 田野 屏保

想要二次元濃度多一點的?也可以!

來自深淵 風(fēng)景 繪畫 寫實風(fēng)格

以上這些圖片,均是由MindDiffusion平臺的下的悟空畫畫制作而成的哦,悟空畫畫是基于擴(kuò)散模型的中文文生圖大模型,由華為諾亞團(tuán)隊攜手中軟分布式并行實驗室,昇騰計算產(chǎn)品部聯(lián)合開發(fā)。模型基于Wukong dataset訓(xùn)練,并使用昇思框架(MindSpore)+昇騰(Ascend)軟硬件解決方案實現(xiàn)。

躍躍欲試的小伙伴先別著急,為了讓大家擁有更好的體驗,更多自行開發(fā)的空間,我們打算讓MindDiffusion中的模型同樣也具備可訓(xùn)練、可推理的特性,預(yù)計在明年就要和大家見面啦,敬請期待,歡迎大家頭腦風(fēng)暴,生成各種別具風(fēng)格的作品哦~

(據(jù)去內(nèi)部打探情報的同事說,有人已經(jīng)開始嘗試"張飛繡花"、"劉華強(qiáng)砍瓜"、"古希臘神大戰(zhàn)哥斯拉"了。ummmm,怎么辦,突然就很期待成品了呢(?ω?))

一個突然正經(jīng)的結(jié)語

最后的最后,在Diffusion爆火的如今,有人也曾發(fā)出過疑問,它為什么可以做到如此的大紅大紫,甚至風(fēng)頭開始超過GAN網(wǎng)絡(luò)?Diffusion的優(yōu)勢突出,劣勢也很明顯;它的諸多領(lǐng)域仍是空白,它的前方還是一片未知。為什么卻有那么多的人在孜孜不倦地對它進(jìn)行研究呢?

興許,馬毅教授的一番話,可以給我們提供一種解答。

"但diffusion process的有效性以及很快取代GAN也充分說明了一個簡單道理:

幾行簡單正確的數(shù)學(xué)推導(dǎo),可以比近十年的大規(guī)模調(diào)試超參調(diào)試網(wǎng)絡(luò)結(jié)構(gòu)有效得多。"

或許,這就是Diffusion模型的魅力吧。

-

圖像

+關(guān)注

關(guān)注

2文章

1094瀏覽量

41187 -

AI

+關(guān)注

關(guān)注

88文章

34936瀏覽量

278258 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8500瀏覽量

134461

原文標(biāo)題:Reference

文章出處:【微信號:vision263com,微信公眾號:新機(jī)器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

運行kmodel模型驗證一直報錯怎么解決?

從芯片市場經(jīng)理說起

如何將一個FA模型開發(fā)的聲明式范式應(yīng)用切換到Stage模型

使用EZ-USB? SUITE構(gòu)建img文件并決定將示例程序下載到開發(fā)板時,遇到一個名為“Bootloader未運行”的錯誤,怎么解決?

大模型領(lǐng)域常用名詞解釋(近100個)

什么是大模型、大模型是怎么訓(xùn)練出來的及大模型作用

為THS3001構(gòu)建一個簡單的SPICE模型

ZX-D37 BLE主從一體藍(lán)牙模塊技術(shù)手冊

ZX-D36 BLE主從一體藍(lán)牙模塊技術(shù)手冊

如何訓(xùn)練一個有效的eIQ基本分類模型

從一個名為DDPM的模型說起

從一個名為DDPM的模型說起

評論