給畫畫AI加個(gè)buff,畫起圖像就像開了掛。

加個(gè)人體骨骼綁定buff,Stable Diffusion直接快進(jìn)到生成3D動漫:

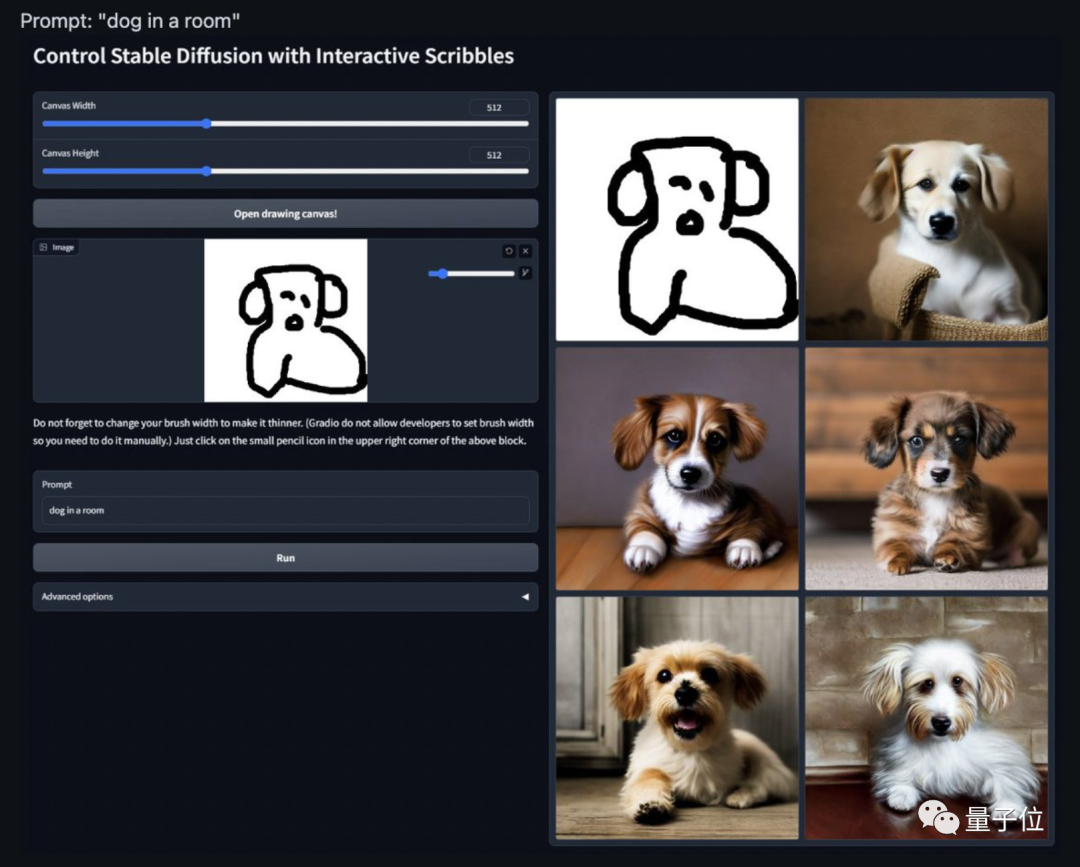

加個(gè)抽象到爆的草圖buff,AI變著風(fēng)格生成“完全一致”的狗子:

就連號稱“AI殺手”的手部細(xì)節(jié),也能在控制之下畫得惟妙惟肖:

這個(gè)名叫ControlNet的新AI插件,可以說是給畫畫AI來了最后的“臨門一腳”——

原本AI無法控制的手部細(xì)節(jié)、整體架構(gòu),有了它之后,加上Stable Diffusion這樣的擴(kuò)散模型,足以生成任何人們想要的圖像。

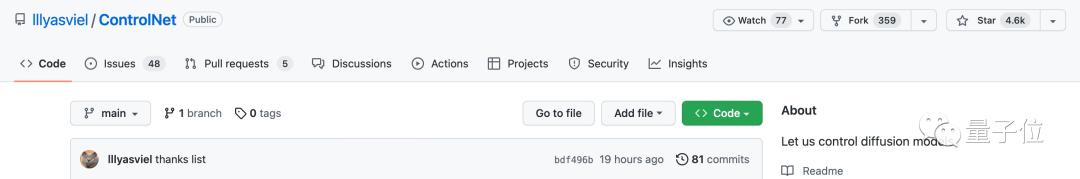

發(fā)出不到兩天,ControlNet就在GitHub上火了,目前已經(jīng)狂攬4.6k星:

△“讓我們控制擴(kuò)散模型”

各種效果圖更是在推特上爆火,試玩過的網(wǎng)友直呼:

游戲結(jié)束!

所以,這個(gè)ControlNet究竟給擴(kuò)散模型加了什么buff?

給AI畫畫模型加buff

ControlNet的原理,本質(zhì)上是給預(yù)訓(xùn)練擴(kuò)散模型增加一個(gè)額外的輸入,控制它生成的細(xì)節(jié)。

這里可以是各種類型的輸入,作者給出來的有8種,包括草圖、邊緣圖像、語義分割圖像、人體關(guān)鍵點(diǎn)特征、霍夫變換檢測直線、深度圖、人體骨骼等。

那么,讓大模型學(xué)會“按輸入條件生成圖片”的原理是什么呢?

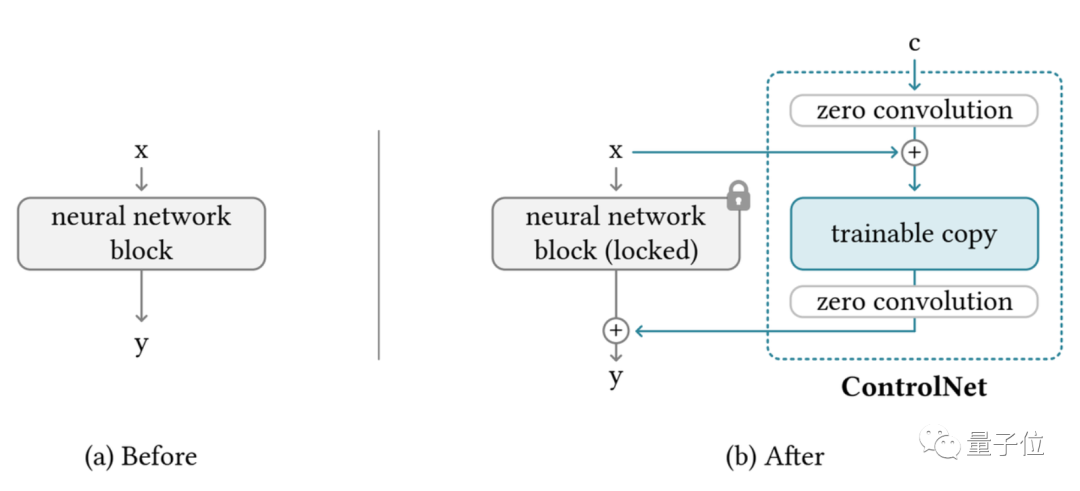

ControlNet整體思路和架構(gòu)分工如下:

具體來說,ControlNet先復(fù)制一遍擴(kuò)散模型的權(quán)重,得到一個(gè)“可訓(xùn)練副本”(trainable copy)。

相比之下,原擴(kuò)散模型經(jīng)過幾十億張圖片的預(yù)訓(xùn)練,因此參數(shù)是被“鎖定”的。而這個(gè)“可訓(xùn)練副本”只需要在特定任務(wù)的小數(shù)據(jù)集上訓(xùn)練,就能學(xué)會條件控制。

據(jù)作者表示,即使數(shù)據(jù)量很少(不超過5萬張圖片),模型經(jīng)過訓(xùn)練后條件控制生成的效果也很好。

“鎖定模型”和“可訓(xùn)練副本”通過一個(gè)1×1的卷積層連接,名叫“0卷積層”。

0卷積層的權(quán)重和偏置初始化為0,這樣在訓(xùn)練時(shí)速度會非常快,接近微調(diào)擴(kuò)散模型的速度,甚至在個(gè)人設(shè)備上訓(xùn)練也可以。

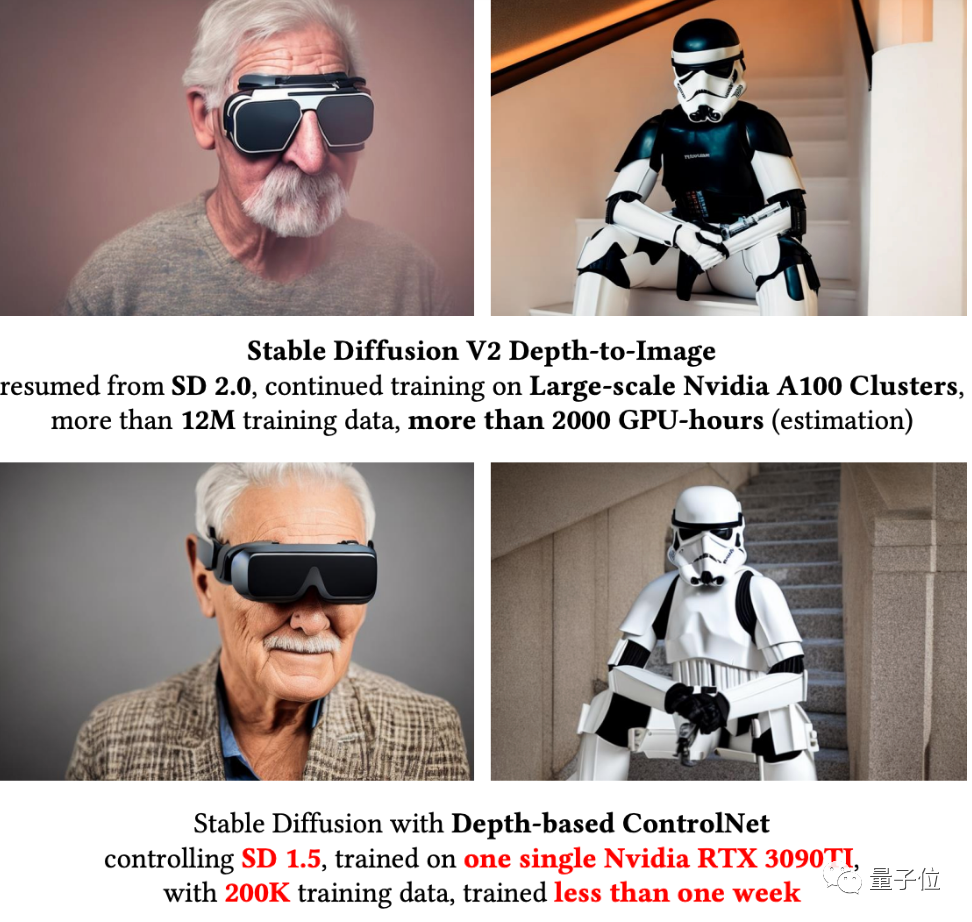

例如一塊英偉達(dá)RTX 3090TI,用20萬張圖像數(shù)據(jù)訓(xùn)練的話只需要不到一個(gè)星期:

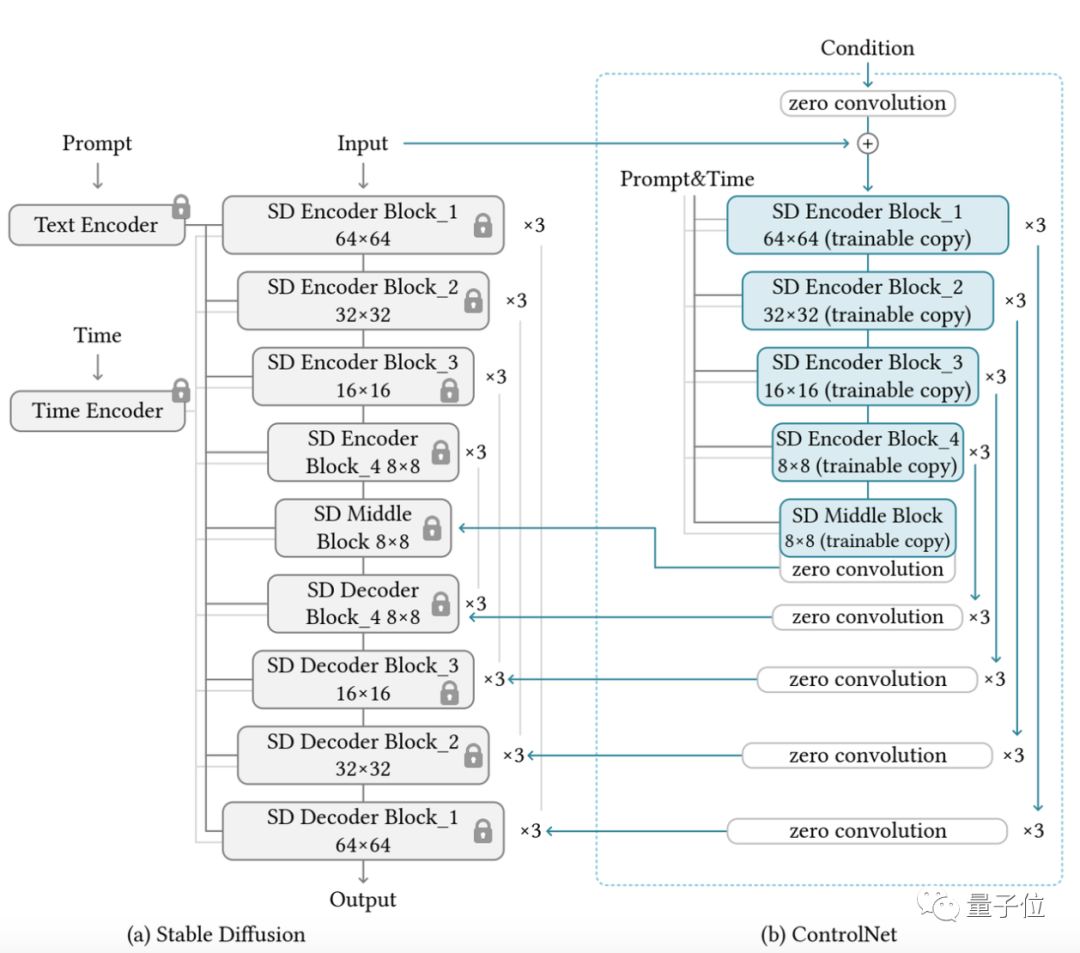

作者基于當(dāng)前大火的Stable Diffusion進(jìn)行了具體實(shí)現(xiàn),主要架構(gòu)如下:

針對不同的輸入,作者也給出了對應(yīng)不同的模型,生成效果也都不錯(cuò)。

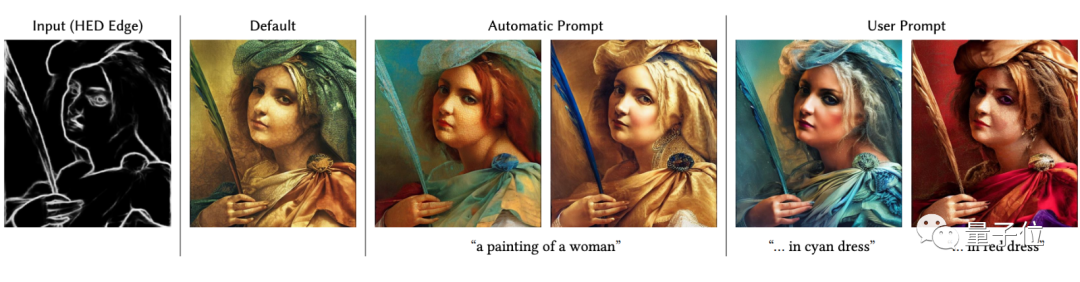

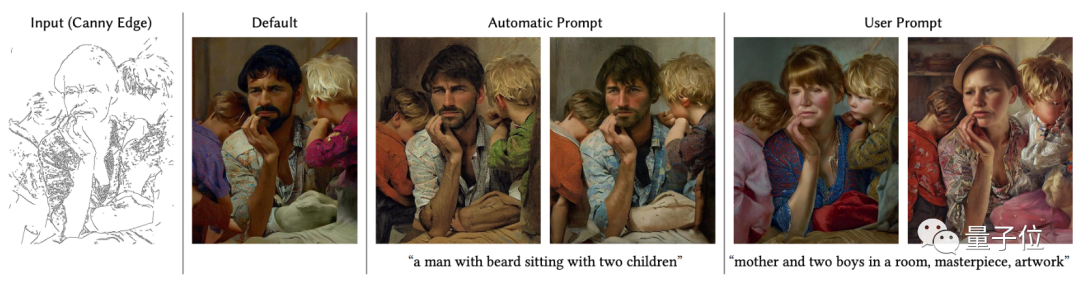

例如這是采用Canny邊緣檢測算法檢測出的邊緣,用于生成圖像:

這是基于霍夫變換的直線檢測算法生成的直線草圖,用于生成各種風(fēng)格的室內(nèi)設(shè)計(jì):

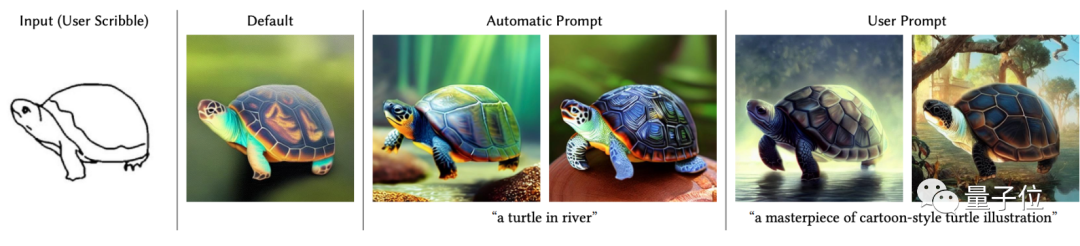

當(dāng)然,自己作畫也可以,例如這是基于用戶草圖生成的小龜:

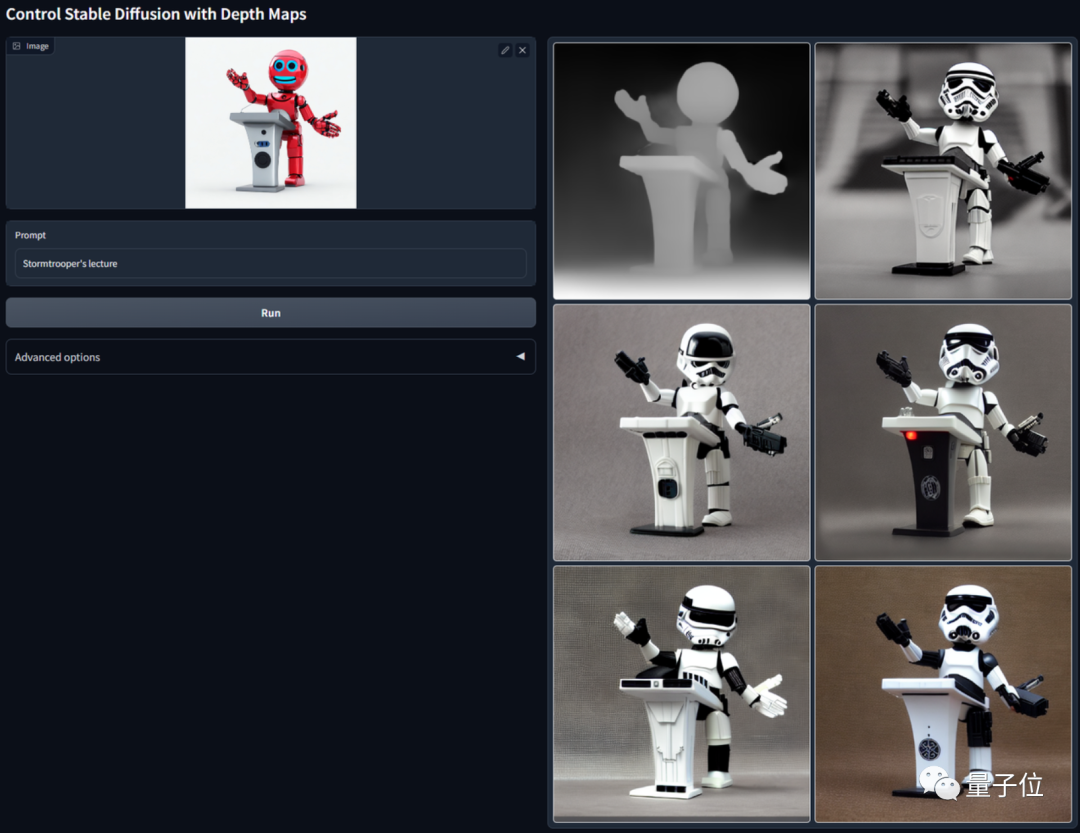

提取深度圖,并讓AI生成一幅相似的圖像,直接舉一反五:

語義分割下的游泳池圖像,不僅水里有倒影細(xì)節(jié),建筑也變化多樣:

不過目前來看,最受歡迎的還是基于人體姿態(tài)估計(jì)算法,控制動漫人物的動作生成:

看到這里,是不是已經(jīng)有了大膽的想法?(手動狗頭)

曾開發(fā)爆火AI上色插件

這個(gè)項(xiàng)目的作者Lvmin Zhang,2021年本科畢業(yè)于東吳大學(xué),目前在斯坦福大學(xué)讀博。

他最出名的項(xiàng)目之一,是2017年開發(fā)的AI上色插件style2paints,目前GitHub上已經(jīng)有15.9k星。

style2paints也經(jīng)過了好幾次迭代,目前即將更新到第五版。

這是第四版的效果,只需要線稿,AI就能自動給你的圖像完成上色:

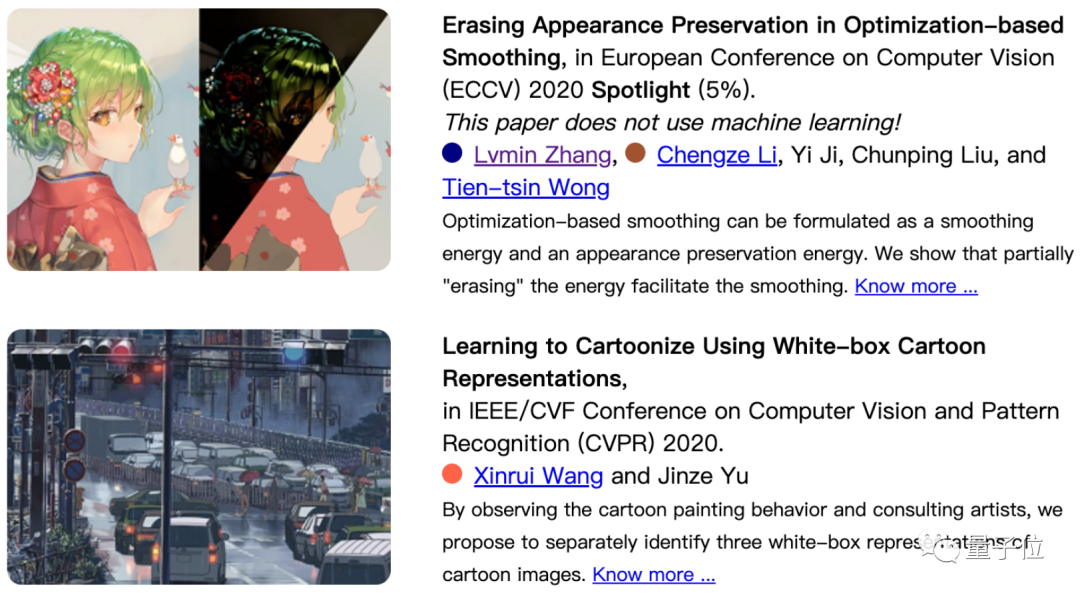

除了這個(gè)項(xiàng)目以外,他也是CV頂會的常客了。

One More Thing

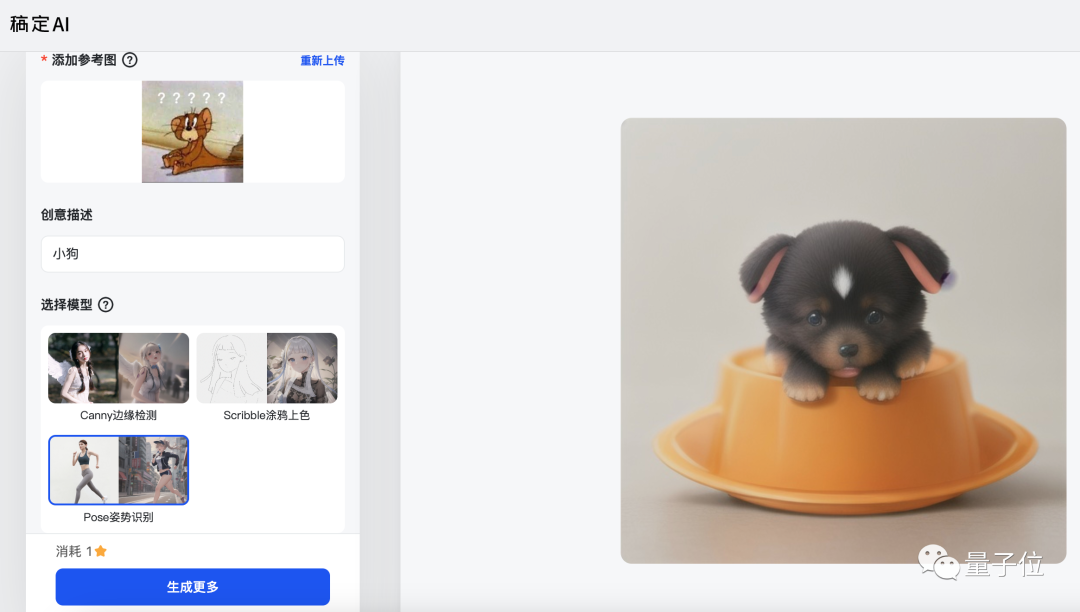

值得一提的是,現(xiàn)在已經(jīng)有基于ControlNet的國內(nèi)產(chǎn)品上線了。

這個(gè)產(chǎn)品名叫稿定AI,包含照片轉(zhuǎn)插畫、插畫線稿上色、插畫優(yōu)化翻新等功能,正是基于ControlNet打造。

作畫效果大概是醬嬸的:

感興趣的小伙伴們可以去試玩一波了~

項(xiàng)目地址: https://github.com/lllyasviel/ControlNet

參考鏈接: [1]https://lllyasviel.github.io/Style2PaintsResearch/ [2]https://twitter.com/search?q=controlnet&src=typed_query [3]https://www.gaoding.com/ai

審核編輯 :李倩

-

AI

+關(guān)注

關(guān)注

88文章

34588瀏覽量

276155 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25318

原文標(biāo)題:讓AI學(xué)會畫手的方法來了,給輸入加個(gè)buff就能控制生成細(xì)節(jié),華人小哥出品丨GitHub 4.6k星

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學(xué)堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

生成式AI如何在智能家居中落地?

如何快速學(xué)會AD?

舒心貼進(jìn)駐《機(jī)會來了》科技庫,4大黑科技讓你安全高效告別疼痛

如何通過使用gm/Id的方法來簡化設(shè)計(jì)運(yùn)放?

可以通過哪些方法來改善MCU掃描附近AP時(shí)出現(xiàn)的故障

給qmail郵件服務(wù)器加個(gè)病毒防火墻

如何通過簡單的方法來增加手機(jī)的續(xù)航時(shí)間

AI給安防行業(yè)帶來了翻天覆地的變化 視頻監(jiān)控是安防最重要的部分

西安交大畢業(yè)生讓機(jī)械手學(xué)會寫字

AI算法5秒鐘就能克隆你的聲音

在線研討會 | 9 月 19 日,利用 GPU 加速生成式 AI 圖像內(nèi)容生成

讓AI學(xué)會畫手的方法來了,給輸入加個(gè)buff就能控制生成細(xì)節(jié)

讓AI學(xué)會畫手的方法來了,給輸入加個(gè)buff就能控制生成細(xì)節(jié)

評論