來源:機(jī)器學(xué)習(xí)研習(xí)院

回歸分析為許多機(jī)器學(xué)習(xí)算法提供了堅(jiān)實(shí)的基礎(chǔ)。在這篇文章中,我們將總結(jié) 10 個(gè)重要的回歸問題和5個(gè)重要的回歸問題的評(píng)價(jià)指標(biāo)。

1、線性回歸的假設(shè)是什么?

線性回歸有四個(gè)假設(shè)

- 線性:自變量(x)和因變量(y)之間應(yīng)該存在線性關(guān)系,這意味著x值的變化也應(yīng)該在相同方向上改變y值。

- 獨(dú)立性:特征應(yīng)該相互獨(dú)立,這意味著最小的多重共線性。

- 正態(tài)性:殘差應(yīng)該是正態(tài)分布的。

- 同方差性:回歸線周圍數(shù)據(jù)點(diǎn)的方差對(duì)于所有值應(yīng)該相同。

2、什么是殘差,它如何用于評(píng)估回歸模型?

殘差是指預(yù)測(cè)值與觀測(cè)值之間的誤差。它測(cè)量數(shù)據(jù)點(diǎn)與回歸線的距離。它是通過從觀察值中減去預(yù)測(cè)值的計(jì)算機(jī)。

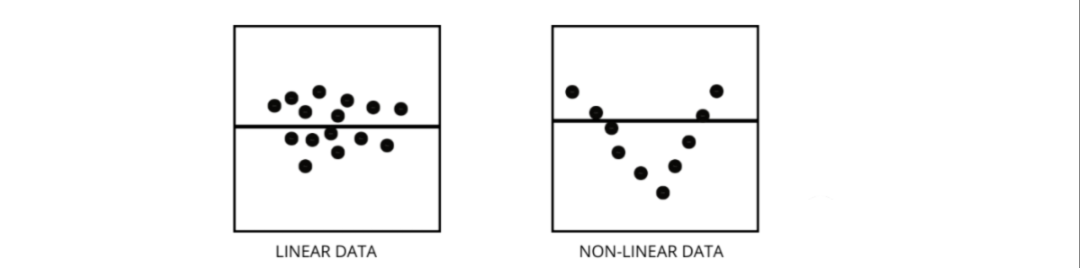

殘差圖是評(píng)估回歸模型的好方法。它是一個(gè)圖表,在垂直軸上顯示所有殘差,在 x 軸上顯示特征。如果數(shù)據(jù)點(diǎn)隨機(jī)散布在沒有圖案的線上,那么線性回歸模型非常適合數(shù)據(jù),否則我們應(yīng)該使用非線性模型。

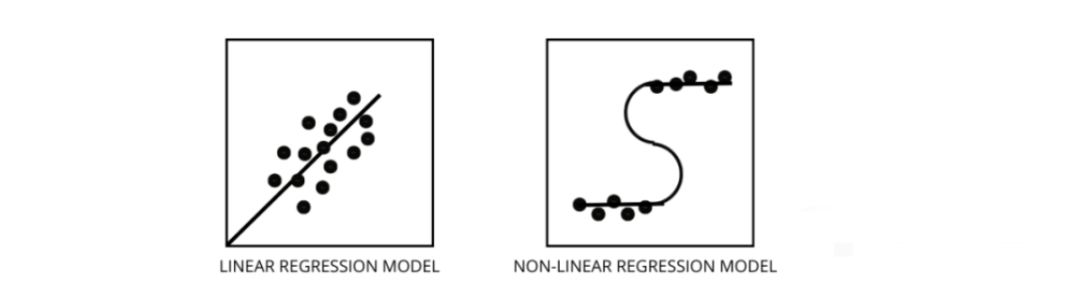

3、如何區(qū)分線性回歸模型和非線性回歸模型?

兩者都是回歸問題的類型。兩者的區(qū)別在于他們訓(xùn)練的數(shù)據(jù)。

線性回歸模型假設(shè)特征和標(biāo)簽之間存在線性關(guān)系,這意味著如果我們獲取所有數(shù)據(jù)點(diǎn)并將它們繪制成線性(直線)線應(yīng)該適合數(shù)據(jù)。

非線性回歸模型假設(shè)變量之間沒有線性關(guān)系。非線性(曲線)線應(yīng)該能夠正確地分離和擬合數(shù)據(jù)。 找出數(shù)據(jù)是線性還是非線性的三種最佳方法 -

找出數(shù)據(jù)是線性還是非線性的三種最佳方法 -

殘差圖

- 散點(diǎn)圖

- 假設(shè)數(shù)據(jù)是線性的,訓(xùn)練一個(gè)線性模型并通過準(zhǔn)確率進(jìn)行評(píng)估。

4、什么是多重共線性,它如何影響模型性能?

當(dāng)某些特征彼此高度相關(guān)時(shí),就會(huì)發(fā)生多重共線性。相關(guān)性是指表示一個(gè)變量如何受到另一個(gè)變量變化影響的度量。

如果特征 a 的增加導(dǎo)致特征 b 的增加,那么這兩個(gè)特征是正相關(guān)的。如果 a 的增加導(dǎo)致特征 b 的減少,那么這兩個(gè)特征是負(fù)相關(guān)的。在訓(xùn)練數(shù)據(jù)上有兩個(gè)高度相關(guān)的變量會(huì)導(dǎo)致多重共線性,因?yàn)樗哪P蜔o法在數(shù)據(jù)中找到模式,從而導(dǎo)致模型性能不佳。所以在訓(xùn)練模型之前首先要盡量消除多重共線性。

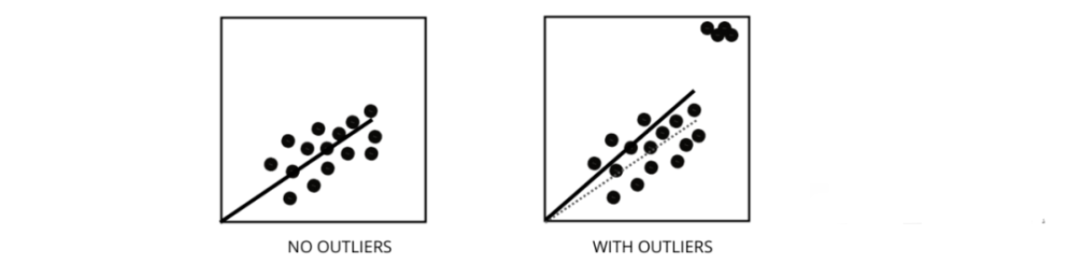

5、異常值如何影響線性回歸模型的性能?

異常值是值與數(shù)據(jù)點(diǎn)的平均值范圍不同的數(shù)據(jù)點(diǎn)。換句話說,這些點(diǎn)與數(shù)據(jù)不同或在第 3 標(biāo)準(zhǔn)之外。 線性回歸模型試圖找到一條可以減少殘差的最佳擬合線。如果數(shù)據(jù)包含異常值,則最佳擬合線將向異常值移動(dòng)一點(diǎn),從而增加錯(cuò)誤率并得出具有非常高 MSE 的模型。

線性回歸模型試圖找到一條可以減少殘差的最佳擬合線。如果數(shù)據(jù)包含異常值,則最佳擬合線將向異常值移動(dòng)一點(diǎn),從而增加錯(cuò)誤率并得出具有非常高 MSE 的模型。

6、什么是 MSE 和 MAE 有什么區(qū)別?

MSE 代表均方誤差,它是實(shí)際值和預(yù)測(cè)值之間的平方差。而 MAE 是目標(biāo)值和預(yù)測(cè)值之間的絕對(duì)差。

MSE 會(huì)懲罰大錯(cuò)誤,而 MAE 不會(huì)。隨著 MSE 和 MAE 的值都降低,模型趨向于一條更好的擬合線。

7、L1 和 L2 正則化是什么,應(yīng)該在什么時(shí)候使用?

在機(jī)器學(xué)習(xí)中,我們的主要目標(biāo)是創(chuàng)建一個(gè)可以在訓(xùn)練和測(cè)試數(shù)據(jù)上表現(xiàn)更好的通用模型,但是在數(shù)據(jù)非常少的情況下,基本的線性回歸模型往往會(huì)過度擬合,因此我們會(huì)使用 l1 和l2 正則化。L1 正則化或 lasso 回歸通過在成本函數(shù)內(nèi)添加添加斜率的絕對(duì)值作為懲罰項(xiàng)。有助于通過刪除斜率值小于閾值的所有數(shù)據(jù)點(diǎn)來去除異常值。

L2 正則化或ridge 回歸增加了相當(dāng)于系數(shù)大小平方的懲罰項(xiàng)。它會(huì)懲罰具有較高斜率值的特征。

l1 和 l2 在訓(xùn)練數(shù)據(jù)較少、方差高、預(yù)測(cè)特征大于觀察值以及數(shù)據(jù)存在多重共線性的情況下都很有用。

8、異方差是什么意思?

它是指最佳擬合線周圍的數(shù)據(jù)點(diǎn)的方差在一個(gè)范圍內(nèi)不一樣的情況。它導(dǎo)致殘差的不均勻分散。如果它存在于數(shù)據(jù)中,那么模型傾向于預(yù)測(cè)無效輸出。檢驗(yàn)異方差的最好方法之一是繪制殘差圖。

數(shù)據(jù)內(nèi)部異方差的最大原因之一是范圍特征之間的巨大差異。例如,如果我們有一個(gè)從 1 到 100000 的列,那么將值增加 10% 不會(huì)改變較低的值,但在較高的值時(shí)則會(huì)產(chǎn)生非常大的差異,從而產(chǎn)生很大的方差差異的數(shù)據(jù)點(diǎn)。

9、方差膨脹因子的作用是什么的作用是什么?

方差膨脹因子(vif)用于找出使用其他自變量可預(yù)測(cè)自變量的程度。

讓我們以具有 v1、v2、v3、v4、v5 和 v6 特征的示例數(shù)據(jù)為例。現(xiàn)在,為了計(jì)算 v1 的 vif,將其視為一個(gè)預(yù)測(cè)變量,并嘗試使用所有其他預(yù)測(cè)變量對(duì)其進(jìn)行預(yù)測(cè)。如果 VIF 的值很小,那么最好從數(shù)據(jù)中刪除該變量。因?yàn)檩^小的值表示變量之間的高相關(guān)性。

10、逐步回歸(stepwise regression)如何工作?

逐步回歸是在假設(shè)檢驗(yàn)的幫助下,通過移除或添加預(yù)測(cè)變量來創(chuàng)建回歸模型的一種方法。它通過迭代檢驗(yàn)每個(gè)自變量的顯著性來預(yù)測(cè)因變量,并在每次迭代之后刪除或添加一些特征。它運(yùn)行n次,并試圖找到最佳的參數(shù)組合,以預(yù)測(cè)因變量的觀測(cè)值和預(yù)測(cè)值之間的誤差最小。

它可以非常高效地管理大量數(shù)據(jù),并解決高維問題。

11、除了MSE 和 MAE 外回歸還有什么重要的指標(biāo)嗎?

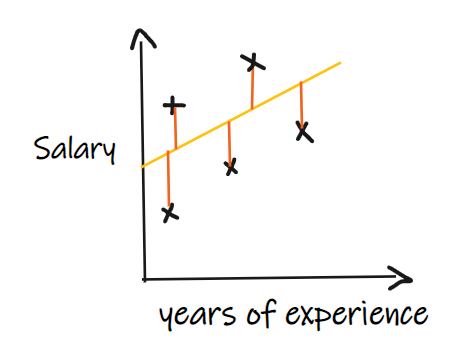

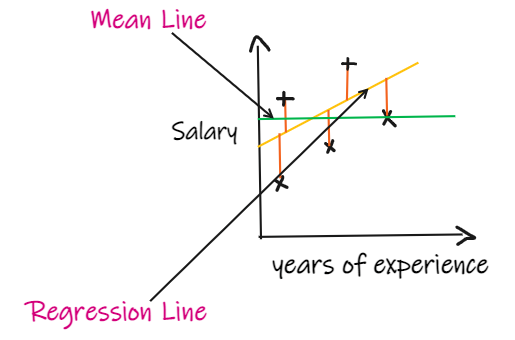

我們用一個(gè)回歸問題來介紹這些指標(biāo),我們的其中輸入是工作經(jīng)驗(yàn),輸出是薪水。下圖顯示了為預(yù)測(cè)薪水而繪制的線性回歸線。

我們用一個(gè)回歸問題來介紹這些指標(biāo),我們的其中輸入是工作經(jīng)驗(yàn),輸出是薪水。下圖顯示了為預(yù)測(cè)薪水而繪制的線性回歸線。

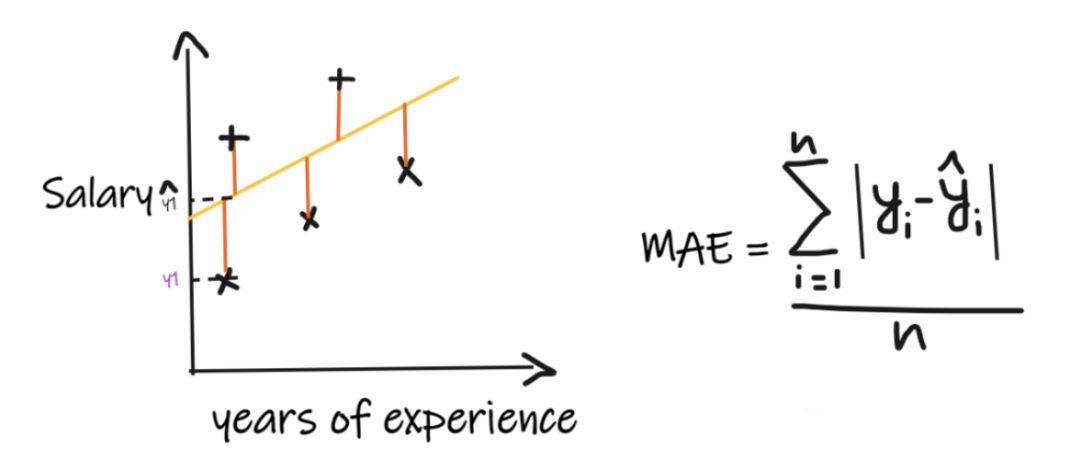

1、平均絕對(duì)誤差(MAE):

平均絕對(duì)誤差 (MAE) 是最簡(jiǎn)單的回歸度量。它將每個(gè)實(shí)際值和預(yù)測(cè)值的差值相加,最后除以觀察次數(shù)。為了使回歸模型被認(rèn)為是一個(gè)好的模型,MAE 應(yīng)該盡可能小。MAE的優(yōu)點(diǎn)是:簡(jiǎn)單易懂。結(jié)果將具有與輸出相同的單位。例如:如果輸出列的單位是 LPA,那么如果 MAE 為 1.2,那么我們可以解釋結(jié)果是 +1.2LPA 或 -1.2LPA,MAE 對(duì)異常值相對(duì)穩(wěn)定(與其他一些回歸指標(biāo)相比,MAE 受異常值的影響較小)。MAE的缺點(diǎn)是:MAE使用的是模函數(shù),但模函數(shù)不是在所有點(diǎn)處都可微的,所以很多情況下不能作為損失函數(shù)。

平均絕對(duì)誤差 (MAE) 是最簡(jiǎn)單的回歸度量。它將每個(gè)實(shí)際值和預(yù)測(cè)值的差值相加,最后除以觀察次數(shù)。為了使回歸模型被認(rèn)為是一個(gè)好的模型,MAE 應(yīng)該盡可能小。MAE的優(yōu)點(diǎn)是:簡(jiǎn)單易懂。結(jié)果將具有與輸出相同的單位。例如:如果輸出列的單位是 LPA,那么如果 MAE 為 1.2,那么我們可以解釋結(jié)果是 +1.2LPA 或 -1.2LPA,MAE 對(duì)異常值相對(duì)穩(wěn)定(與其他一些回歸指標(biāo)相比,MAE 受異常值的影響較小)。MAE的缺點(diǎn)是:MAE使用的是模函數(shù),但模函數(shù)不是在所有點(diǎn)處都可微的,所以很多情況下不能作為損失函數(shù)。

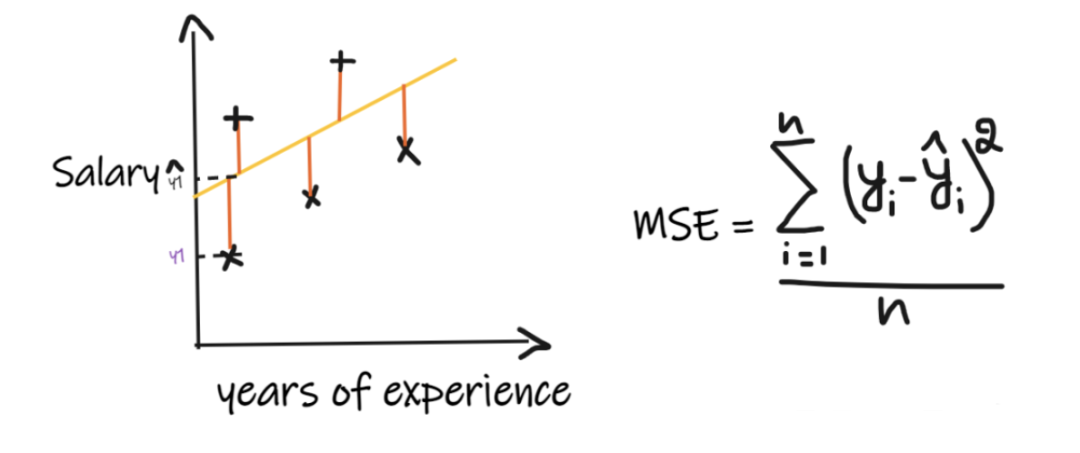

2、均方誤差(MSE):

MSE取每個(gè)實(shí)際值和預(yù)測(cè)值之間的差值,然后將差值平方并將它們相加,最后除以觀測(cè)數(shù)量。為了使回歸模型被認(rèn)為是一個(gè)好的模型,MSE 應(yīng)該盡可能小。MSE的優(yōu)點(diǎn):平方函數(shù)在所有點(diǎn)上都是可微的,因此它可以用作損失函數(shù)。MSE的缺點(diǎn):由于 MSE 使用平方函數(shù),結(jié)果的單位是輸出的平方。因此很難解釋結(jié)果。由于它使用平方函數(shù),如果數(shù)據(jù)中有異常值,則差值也會(huì)被平方,因此,MSE 對(duì)異常值不穩(wěn)定。

MSE取每個(gè)實(shí)際值和預(yù)測(cè)值之間的差值,然后將差值平方并將它們相加,最后除以觀測(cè)數(shù)量。為了使回歸模型被認(rèn)為是一個(gè)好的模型,MSE 應(yīng)該盡可能小。MSE的優(yōu)點(diǎn):平方函數(shù)在所有點(diǎn)上都是可微的,因此它可以用作損失函數(shù)。MSE的缺點(diǎn):由于 MSE 使用平方函數(shù),結(jié)果的單位是輸出的平方。因此很難解釋結(jié)果。由于它使用平方函數(shù),如果數(shù)據(jù)中有異常值,則差值也會(huì)被平方,因此,MSE 對(duì)異常值不穩(wěn)定。

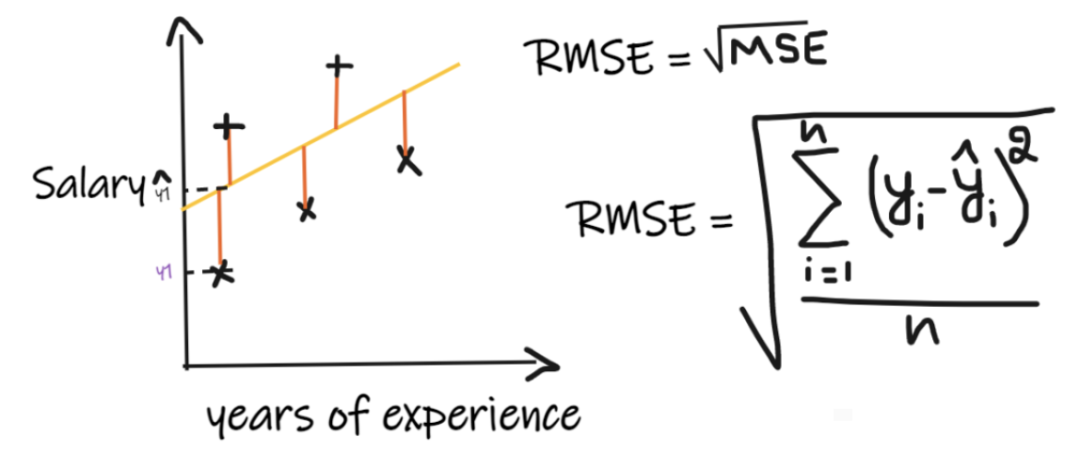

3、均方根誤差 (RMSE):

均方根誤差(RMSE)取每個(gè)實(shí)際值和預(yù)測(cè)值之間的差值,然后將差值平方并將它們相加,最后除以觀測(cè)數(shù)量。然后取結(jié)果的平方根。因此,RMSE 是 MSE 的平方根。為了使回歸模型被認(rèn)為是一個(gè)好的模型,RMSE 應(yīng)該盡可能小。RMSE 解決了 MSE 的問題,單位將與輸出的單位相同,因?yàn)樗∑椒礁匀粚?duì)異常值不那么穩(wěn)定。

均方根誤差(RMSE)取每個(gè)實(shí)際值和預(yù)測(cè)值之間的差值,然后將差值平方并將它們相加,最后除以觀測(cè)數(shù)量。然后取結(jié)果的平方根。因此,RMSE 是 MSE 的平方根。為了使回歸模型被認(rèn)為是一個(gè)好的模型,RMSE 應(yīng)該盡可能小。RMSE 解決了 MSE 的問題,單位將與輸出的單位相同,因?yàn)樗∑椒礁匀粚?duì)異常值不那么穩(wěn)定。

上述指標(biāo)取決于我們正在解決的問題的上下文, 我們不能在不了解實(shí)際問題的情況下,只看 MAE、MSE 和 RMSE 的值來判斷模型的好壞。

4、R2 score:

如果我們沒有任何輸入數(shù)據(jù),但是想知道他在這家公司能拿到多少薪水,那么我們能做的最好的事情就是給他們所有員工薪水的平均值。

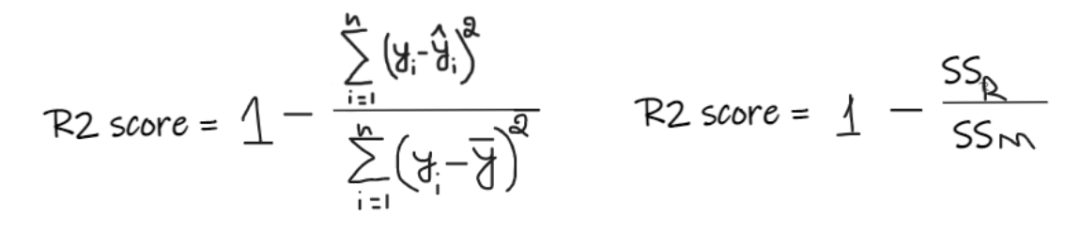

如果我們沒有任何輸入數(shù)據(jù),但是想知道他在這家公司能拿到多少薪水,那么我們能做的最好的事情就是給他們所有員工薪水的平均值。 R2 score 給出的值介于 0 到 1 之間,可以針對(duì)任何上下文進(jìn)行解釋。它可以理解為是擬合度的好壞。SSR 是回歸線的誤差平方和,SSM 是均線誤差的平方和。我們將回歸線與平均線進(jìn)行比較。

R2 score 給出的值介于 0 到 1 之間,可以針對(duì)任何上下文進(jìn)行解釋。它可以理解為是擬合度的好壞。SSR 是回歸線的誤差平方和,SSM 是均線誤差的平方和。我們將回歸線與平均線進(jìn)行比較。

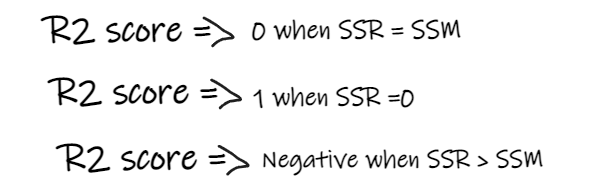

- 如果 R2 得分為 0,則意味著我們的模型與平均線的結(jié)果是相同的,因此需要改進(jìn)我們的模型。

- 如果 R2 得分為 1,則等式的右側(cè)部分變?yōu)?0,這只有在我們的模型適合每個(gè)數(shù)據(jù)點(diǎn)并且沒有出現(xiàn)誤差時(shí)才會(huì)發(fā)生。

- 如果 R2 得分為負(fù),則表示等式右側(cè)大于 1,這可能發(fā)生在 SSR > SSM 時(shí)。這意味著我們的模型比平均線最差,也就是說我們的模型還不如取平均數(shù)進(jìn)行預(yù)測(cè)

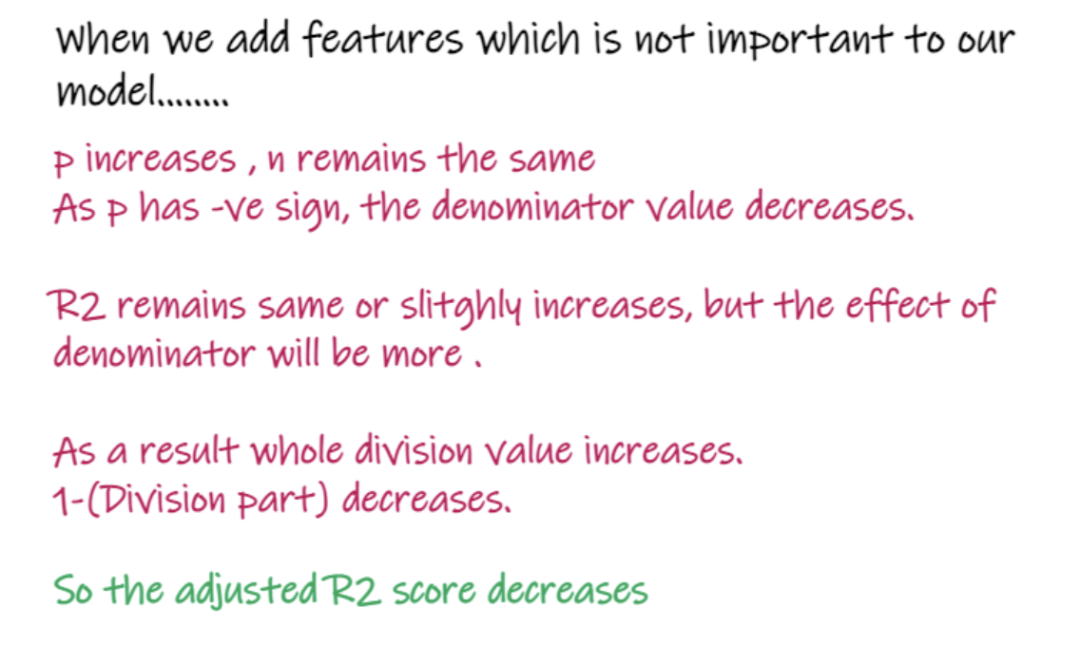

如果我們模型的 R2 得分為 0.8,這意味著可以說模型能夠解釋 80% 的輸出方差。也就是說,80%的工資變化可以用輸入(工作年限)來解釋,但剩下的20%是未知的。如果我們的模型有2個(gè)特征,工作年限和面試分?jǐn)?shù),那么我們的模型能夠使用這兩個(gè)輸入特征解釋80%的工資變化。R2的缺點(diǎn):隨著輸入特征數(shù)量的增加,R2會(huì)趨于相應(yīng)的增加或者保持不變,但永遠(yuǎn)不會(huì)下降,即使輸入特征對(duì)我們的模型不重要(例如,將面試當(dāng)天的氣溫添加到我們的示例中,R2是不會(huì)下降的即使溫度對(duì)輸出不重要)。

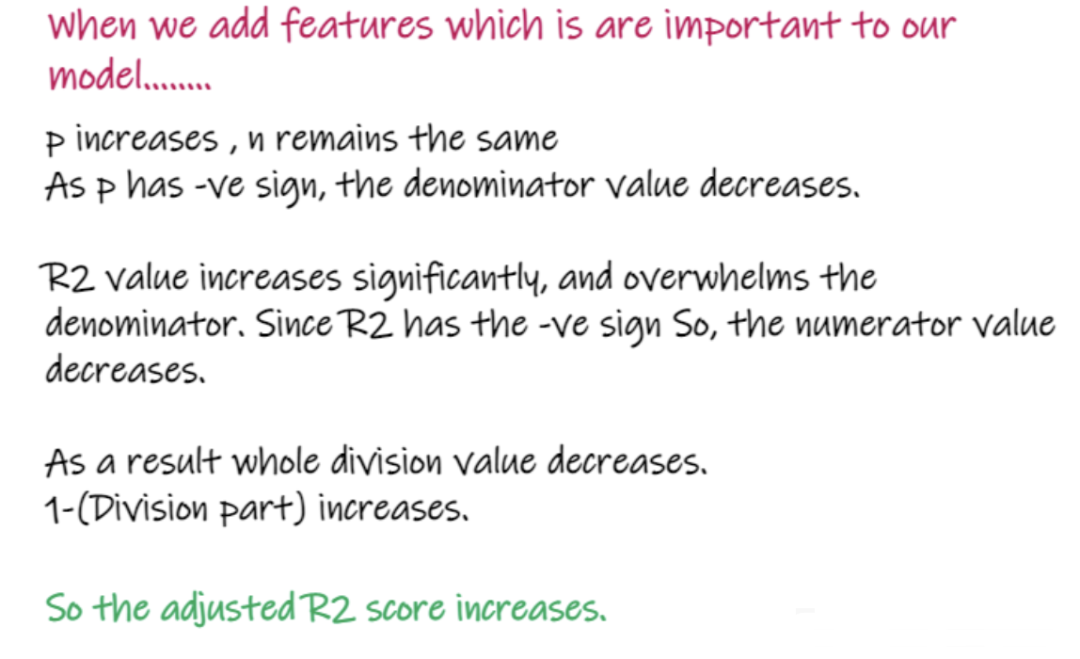

5、Adjusted R2 score:

上式中R2為R2,n為觀測(cè)數(shù)(行),p為獨(dú)立特征數(shù)。Adjusted R2解決了R2的問題。當(dāng)我們添加對(duì)我們的模型不那么重要的特性時(shí),比如添加溫度來預(yù)測(cè)工資..... 當(dāng)添加對(duì)模型很重要的特性時(shí),比如添加面試分?jǐn)?shù)來預(yù)測(cè)工資……

當(dāng)添加對(duì)模型很重要的特性時(shí),比如添加面試分?jǐn)?shù)來預(yù)測(cè)工資……

以上就是回歸問題的重要知識(shí)點(diǎn)和解決回歸問題使用的各種重要指標(biāo)的介紹及其優(yōu)缺點(diǎn),希望對(duì)你有所幫助。

-

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8501瀏覽量

134531

發(fā)布評(píng)論請(qǐng)先 登錄

最新人工智能硬件培訓(xùn)AI基礎(chǔ)入門學(xué)習(xí)課程參考2025版(離線AI語音視覺識(shí)別篇)

電機(jī)選型計(jì)算公式與知識(shí)點(diǎn)匯總

Linux常用命令行總結(jié)

機(jī)器學(xué)習(xí)模型市場(chǎng)前景如何

Kaggle知識(shí)點(diǎn):7種超參數(shù)搜索方法

Aigtek功率放大器應(yīng)用:電感線圈的知識(shí)點(diǎn)分享

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】1.全書概覽與第一章學(xué)習(xí)

《具身智能機(jī)器人系統(tǒng)》第7-9章閱讀心得之具身智能機(jī)器人與大模型

Kaggle知識(shí)點(diǎn):使用大模型進(jìn)行特征篩選

接口測(cè)試?yán)碚摗⒁蓡柺珍浥c擴(kuò)展相關(guān)知識(shí)點(diǎn)

機(jī)器學(xué)習(xí)回歸模型相關(guān)重要知識(shí)點(diǎn)總結(jié)

機(jī)器學(xué)習(xí)回歸模型相關(guān)重要知識(shí)點(diǎn)總結(jié)

評(píng)論