英偉達在世界電腦會議(sc2023)上發布了最新ai芯片h200,對ai模型進行了訓練。

英偉達大幅升級了熱門的h100人工智能gpu。新高端芯片芯片h200基于英偉達的hopper架構,是第一個使用高帶寬內存的gpu,速度更快。建立一個大的語言模型是必要的。推理或生成問題答案時性能比h100提高60 ~ 90%。

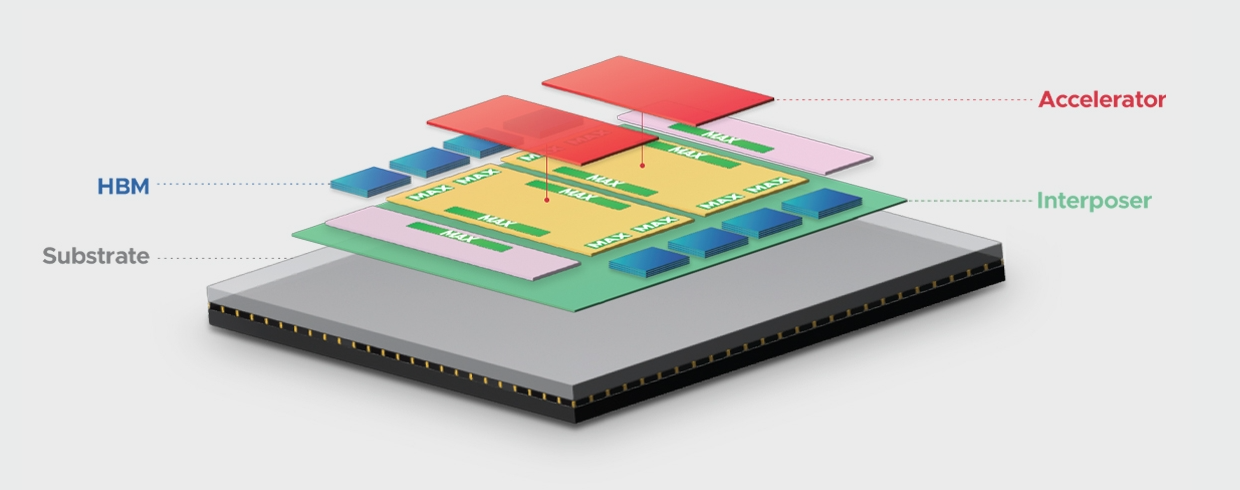

英偉達方面表示,以hbm3e為基礎,h200每秒提供4.8tb、141gb的存儲器,與a100相比,容量和帶寬分別增加2倍和2.4倍。

在備受關注的人工智能領域,英偉達表示,h200將進一步提高性能。llama 2(700億個llm)的推理速度是h100的兩倍。未來的軟件更新有望為h200帶來更多的性能和改進。

h200由英偉達hgx h200服務器主板4頻道和8頻道組成,可與hgx h100系統的硬件和軟件兼容。

據悉,大型計算機制造企業和云服務提供企業將從明年第二季度開始使用h200。亞馬遜的aws、Alphabet公司的谷歌云、微軟的azure、甲骨文的云基礎設施已承諾從明年開始使用該新芯片。

英偉達表示,希望通過推出新產品,趕上人工智能(ai)模型和服務數據集規模的增加。隨著內存容量的增加,h200向軟件提供數據的速度將會加快,這一過程將訓練人工智能來完成圖像和語音識別等工作。

過去英偉達通常每兩年更新一次芯片架構,而最新的芯片架構是hopper。但nvidia向投資者表示,隨著上月對gpu的需求劇增,原本每2年推出新的架構,現在改為每1年推出新的架構。

-

存儲器

+關注

關注

38文章

7644瀏覽量

167102 -

人工智能

+關注

關注

1806文章

48971瀏覽量

248699 -

英偉達

+關注

關注

22文章

3938瀏覽量

93502

發布評論請先 登錄

AMD最強AI芯片,性能強過英偉達H200,但市場仍不買賬,生態是最大短板?

特朗普要叫停英偉達對華特供版 英偉達H20出口限制 或損失55億美元

新思科技攜手英偉達加速芯片設計,提升芯片電子設計自動化效率

GMI Cloud推出基于英偉達H200的DeepSeek系列模型

英偉達發布DeepSeek R1于NIM平臺

一顆芯片面積頂4顆H200,博通推出3.5D XDSiP封裝平臺

軟銀攜手英偉達打造日本最強AI超算

英偉達地表最強AI芯片GB200 NVL72服務器遭搶購

聯發科與英偉達合作AI PC 3nm CPU即將流片

英特爾發布Gaudi3 AI加速器,押注低成本優勢挑戰市場

亞馬遜云科技宣布Amazon EC2 P5e實例正式可用 由英偉達H200 GPU提供支持

三星電子HBM3E內存獲英偉達認證,加速AI GPU市場布局

英偉達或取消B100轉用B200A代替

世界最強AI芯H200發布,英偉達:性能提升90%

世界最強AI芯H200發布,英偉達:性能提升90%

評論