PyTorch是一個(gè)廣泛使用的深度學(xué)習(xí)框架,它以其靈活性、易用性和強(qiáng)大的動態(tài)圖特性而聞名。在訓(xùn)練深度學(xué)習(xí)模型時(shí),數(shù)據(jù)集是不可或缺的組成部分。然而,很多時(shí)候,我們可能需要使用自己的數(shù)據(jù)集而不是現(xiàn)成的數(shù)據(jù)集。本文將深入解讀如何使用PyTorch訓(xùn)練自己的數(shù)據(jù)集,包括數(shù)據(jù)準(zhǔn)備、模型定義、訓(xùn)練過程以及優(yōu)化和評估等方面。

一、數(shù)據(jù)準(zhǔn)備

1.1 數(shù)據(jù)集整理

在訓(xùn)練自己的數(shù)據(jù)集之前,首先需要將數(shù)據(jù)集整理成模型可以識別的格式。這通常包括以下幾個(gè)步驟:

- 數(shù)據(jù)收集 :收集與任務(wù)相關(guān)的數(shù)據(jù),如圖像、文本、音頻等。

- 數(shù)據(jù)清洗 :去除噪聲、錯(cuò)誤或重復(fù)的數(shù)據(jù),確保數(shù)據(jù)質(zhì)量。

- 數(shù)據(jù)標(biāo)注 :對于監(jiān)督學(xué)習(xí)任務(wù),需要對數(shù)據(jù)進(jìn)行標(biāo)注,如分類標(biāo)簽、回歸值等。

- 數(shù)據(jù)劃分 :將數(shù)據(jù)集劃分為訓(xùn)練集、驗(yàn)證集和測試集,通常的比例為70%、15%和15%。這一步是為了在訓(xùn)練過程中能夠評估模型的性能,避免過擬合。

1.2 數(shù)據(jù)加載

在PyTorch中,可以使用torch.utils.data.Dataset和torch.utils.data.DataLoader來加載數(shù)據(jù)。如果使用的是自定義數(shù)據(jù)集,需要繼承Dataset類并實(shí)現(xiàn)__getitem__和__len__方法。

- ** getitem (self, index)** :根據(jù)索引返回單個(gè)樣本及其標(biāo)簽。

- ** len (self)** :返回?cái)?shù)據(jù)集中樣本的總數(shù)。

例如,如果有一個(gè)圖像分類任務(wù)的數(shù)據(jù)集,可以將圖像路徑和標(biāo)簽保存在一個(gè)文本文件中,然后編寫一個(gè)類來讀取這個(gè)文件并返回圖像和標(biāo)簽。

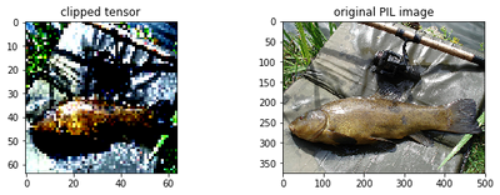

1.3 數(shù)據(jù)預(yù)處理

數(shù)據(jù)預(yù)處理是提高模型性能的關(guān)鍵步驟。在PyTorch中,可以使用torchvision.transforms模塊來定義各種圖像變換操作,如縮放、裁剪、翻轉(zhuǎn)、歸一化等。這些變換可以在加載數(shù)據(jù)時(shí)進(jìn)行應(yīng)用,以提高模型的泛化能力。

二、模型定義

在PyTorch中,可以使用torch.nn.Module來定義自己的模型。模型通常包括多個(gè)層(如卷積層、池化層、全連接層等),這些層定義了數(shù)據(jù)的變換方式。

2.1 層定義

在定義模型時(shí),首先需要定義所需的層。PyTorch提供了豐富的層定義,如nn.Conv2d(卷積層)、nn.MaxPool2d(最大池化層)、nn.Linear(全連接層)等。通過組合這些層,可以構(gòu)建出復(fù)雜的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)。

2.2 前向傳播

在定義模型時(shí),需要實(shí)現(xiàn)forward方法,該方法定義了數(shù)據(jù)通過模型的前向傳播過程。在forward方法中,可以調(diào)用之前定義的層,并按照一定的順序?qū)⑺鼈兘M合起來。

2.3 示例

以下是一個(gè)簡單的卷積神經(jīng)網(wǎng)絡(luò)(CNN)模型的定義示例:

import torch

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self, num_classes=10):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size=3, padding=1) # 輸入通道3,輸出通道16,卷積核大小3x3,padding=1

self.relu = nn.ReLU()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc = nn.Linear(16 * 5 * 5, num_classes) # 假設(shè)輸入圖像大小為32x32,經(jīng)過兩次池化后大小為8x8,然后展平為16*5*5

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = self.pool(x)

x = x.view(-1, 16 * 5 * 5) # 展平操作

x = self.fc(x)

return x

三、訓(xùn)練過程

在定義了模型和數(shù)據(jù)集之后,就可以開始訓(xùn)練過程了。訓(xùn)練過程通常包括以下幾個(gè)步驟:

3.1 初始化模型和優(yōu)化器

首先,需要實(shí)例化模型并定義優(yōu)化器。優(yōu)化器用于調(diào)整模型的參數(shù)以最小化損失函數(shù)。PyTorch提供了多種優(yōu)化器,如SGD、Adam等。

3.2 訓(xùn)練循環(huán)

訓(xùn)練過程是一個(gè)迭代過程,每個(gè)迭代稱為一個(gè)epoch。在每個(gè)epoch中,需要遍歷整個(gè)訓(xùn)練集,并對每個(gè)批次的數(shù)據(jù)進(jìn)行前向傳播、計(jì)算損失、反向傳播和參數(shù)更新。

3.3 前向傳播

在每個(gè)批次的數(shù)據(jù)上,將輸入數(shù)據(jù)通過模型進(jìn)行前向傳播,得到預(yù)測值。這個(gè)過程中,模型會根據(jù)當(dāng)前參數(shù)計(jì)算輸出。

3.4 計(jì)算損失

使用損失函數(shù)計(jì)算預(yù)測值與實(shí)際值之間的差異。損失函數(shù)的選擇取決于任務(wù)類型,如分類任務(wù)常用交叉熵?fù)p失,回歸任務(wù)常用均方誤差損失等。

3.5 反向傳播

通過調(diào)用損失函數(shù)的.backward()方法,計(jì)算損失函數(shù)關(guān)于模型參數(shù)的梯度。這個(gè)過程中,PyTorch會自動進(jìn)行鏈?zhǔn)椒▌t的計(jì)算,將梯度傳播回網(wǎng)絡(luò)的每一層。

3.6 參數(shù)更新

使用優(yōu)化器根據(jù)梯度更新模型的參數(shù)。在調(diào)用optimizer.step()之前,需要先用optimizer.zero_grad()清除之前累積的梯度,防止梯度累加導(dǎo)致更新方向偏離。

3.7 驗(yàn)證與測試

在每個(gè)epoch或每幾個(gè)epoch后,可以在驗(yàn)證集或測試集上評估模型的性能。這有助于監(jiān)控模型的訓(xùn)練過程,防止過擬合,并確定最佳的停止訓(xùn)練時(shí)間。

四、優(yōu)化與調(diào)試

在訓(xùn)練過程中,可能需要對模型進(jìn)行優(yōu)化和調(diào)試,以提高其性能。以下是一些常見的優(yōu)化和調(diào)試技巧:

4.1 學(xué)習(xí)率調(diào)整

學(xué)習(xí)率是優(yōu)化過程中的一個(gè)重要超參數(shù)。如果學(xué)習(xí)率過高,可能會導(dǎo)致模型無法收斂;如果學(xué)習(xí)率過低,則訓(xùn)練過程會非常緩慢。可以使用學(xué)習(xí)率調(diào)度器(如ReduceLROnPlateau、CosineAnnealingLR等)來動態(tài)調(diào)整學(xué)習(xí)率。

4.2 權(quán)重初始化

權(quán)重初始化對模型的訓(xùn)練效果有很大影響。不恰當(dāng)?shù)某跏蓟赡軙?dǎo)致梯度消失或爆炸等問題。PyTorch提供了多種權(quán)重初始化方法(如Xavier、Kaiming等),可以根據(jù)具體情況選擇合適的初始化方式。

4.3 批量歸一化

批量歸一化(Batch Normalization, BN)是一種常用的加速深度網(wǎng)絡(luò)訓(xùn)練的技術(shù)。通過在每個(gè)小批量數(shù)據(jù)上進(jìn)行歸一化操作,BN可以加快收斂速度,提高訓(xùn)練穩(wěn)定性,并且有助于解決內(nèi)部協(xié)變量偏移問題。

4.4 過擬合處理

過擬合是深度學(xué)習(xí)中常見的問題之一。為了防止過擬合,可以采取多種策略,如增加數(shù)據(jù)集的多樣性、使用正則化技術(shù)(如L1、L2正則化)、采用dropout等。

4.5 調(diào)試與可視化

在訓(xùn)練過程中,可以使用PyTorch的調(diào)試工具和可視化庫(如TensorBoard)來監(jiān)控模型的訓(xùn)練狀態(tài)。這有助于及時(shí)發(fā)現(xiàn)并解決問題,如梯度消失、梯度爆炸、學(xué)習(xí)率不合適等。

五、實(shí)際應(yīng)用

PyTorch的靈活性和易用性使得它在許多領(lǐng)域都有廣泛的應(yīng)用,如計(jì)算機(jī)視覺、自然語言處理、強(qiáng)化學(xué)習(xí)等。在訓(xùn)練自己的數(shù)據(jù)集時(shí),可以根據(jù)具體任務(wù)的需求選擇合適的模型結(jié)構(gòu)、損失函數(shù)和優(yōu)化器,并進(jìn)行充分的實(shí)驗(yàn)和調(diào)優(yōu)。

此外,隨著PyTorch生態(tài)的不斷發(fā)展,越來越多的工具和庫被開發(fā)出來,如torchvision、torchtext、torchaudio等,為開發(fā)者提供了更加便捷和高效的解決方案。這些工具和庫不僅包含了預(yù)訓(xùn)練模型和常用數(shù)據(jù)集,還提供了豐富的API和文檔支持,極大地降低了開發(fā)門檻和成本。

總之,使用PyTorch訓(xùn)練自己的數(shù)據(jù)集是一個(gè)涉及多個(gè)步驟和技巧的過程。通過深入理解PyTorch的基本概念、數(shù)據(jù)準(zhǔn)備、模型定義、訓(xùn)練過程以及優(yōu)化和調(diào)試等方面的知識,可以更加高效地構(gòu)建和訓(xùn)練深度學(xué)習(xí)模型,并將其應(yīng)用于實(shí)際問題的解決中。

-

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25394 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5559瀏覽量

122729 -

pytorch

+關(guān)注

關(guān)注

2文章

809瀏覽量

13909

發(fā)布評論請先 登錄

Pytorch模型訓(xùn)練實(shí)用PDF教程【中文】

怎樣使用PyTorch Hub去加載YOLOv5模型

利用 Python 和 PyTorch 處理面向?qū)ο蟮?b class='flag-5'>數(shù)據(jù)集(2)) :創(chuàng)建數(shù)據(jù)集對象

利用Python和PyTorch處理面向?qū)ο蟮?b class='flag-5'>數(shù)據(jù)集(1)

YOLOv7訓(xùn)練自己的數(shù)據(jù)集包括哪些

PyTorch教程4.2之圖像分類數(shù)據(jù)集

PyTorch教程14.6之對象檢測數(shù)據(jù)集

PyTorch教程之15.2近似訓(xùn)練

PyTorch教程15.9之預(yù)訓(xùn)練BERT的數(shù)據(jù)集

PyTorch如何訓(xùn)練自己的數(shù)據(jù)集

PyTorch如何訓(xùn)練自己的數(shù)據(jù)集

評論