面對(duì)人工智能大模型的迅速發(fā)展及其對(duì)算力資源的急劇增長需求,單芯片性能提升遭遇瓶頸,同時(shí)通過Scale Out策略擴(kuò)展多機(jī)集群以增加算力也遇到了局限性。在此背景下,中國信通院與騰訊攜手GPU、CPU、交換機(jī)芯片制造商、服務(wù)器供應(yīng)商、網(wǎng)絡(luò)設(shè)備廠商及互聯(lián)網(wǎng)企業(yè)等多方力量,共同發(fā)起超大帶寬ETH-X(以太網(wǎng))超節(jié)點(diǎn)計(jì)劃,旨在通過技術(shù)創(chuàng)新與行業(yè)合作,構(gòu)建開放可擴(kuò)展的HBD(高帶寬域)超節(jié)點(diǎn)系統(tǒng)樣機(jī),探索AI算力提升新途徑,為構(gòu)建ETH-X超節(jié)點(diǎn)互聯(lián)開放協(xié)作產(chǎn)業(yè)生態(tài)提供支撐。同時(shí),將共同編制相關(guān)技術(shù)規(guī)范,為行業(yè)樹立標(biāo)準(zhǔn),引導(dǎo)超節(jié)點(diǎn)技術(shù)高質(zhì)發(fā)展。

AI大模型發(fā)展與算力需求

AI大模型的發(fā)展依賴于持續(xù)提升算力。根據(jù)Scaling Law(規(guī)模定理),增大模型規(guī)模與增加訓(xùn)練數(shù)據(jù)量是直接提升AI大模型智能水平與性能的關(guān)鍵途徑。但對(duì)集群算力需求的將呈指數(shù)級(jí)增長。

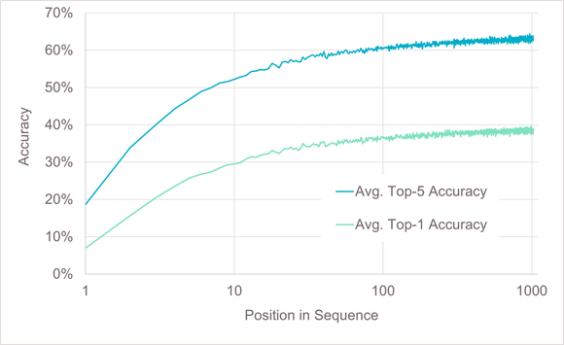

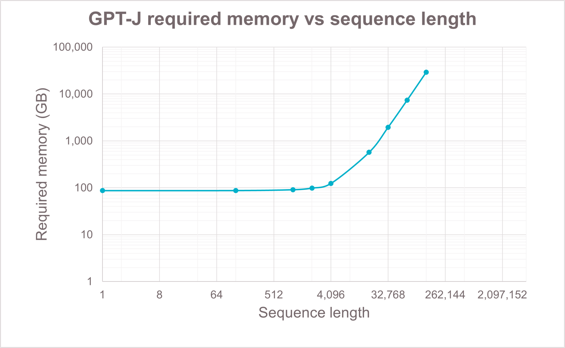

長序列是AI大模型發(fā)展的另一個(gè)重要方向。長序列提高AI大模型回答問題的質(zhì)量、處理復(fù)雜任務(wù)的能力以及更強(qiáng)的記憶力和個(gè)性化能力的同時(shí),也會(huì)加大對(duì)訓(xùn)練和推理算力資源的需求1,尤其是對(duì)顯存資源的需求。因此滿足AI大模型發(fā)展需求,算力能力的持續(xù)提升成為一個(gè)重要基礎(chǔ)。

圖1 長序列帶來的準(zhǔn)確率收益以及顯存需求

單芯片算力提升遇阻、

scale out集群算力提升受限

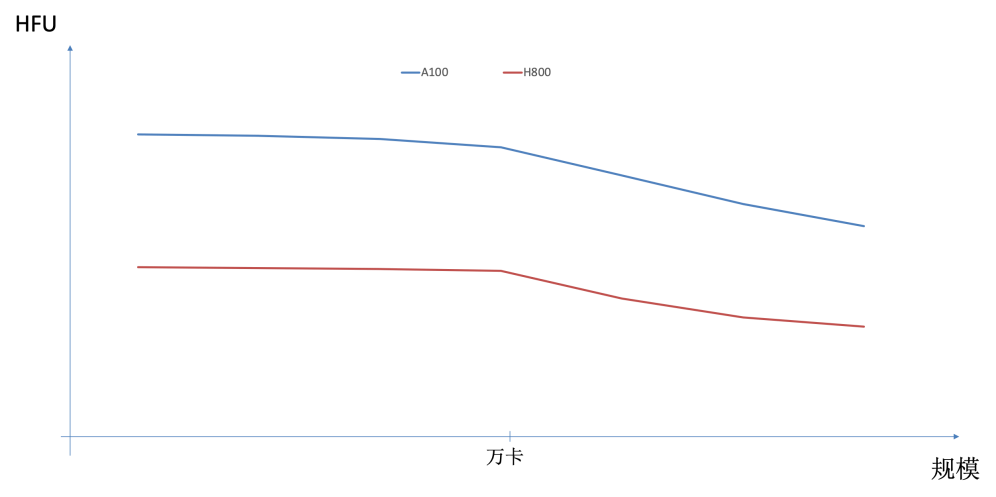

當(dāng)前,提升集群算力已面臨一些明顯的制約因素。首先,單芯片性能提升受到HBM容量帶寬增長趕不上算力增長速度的限制,內(nèi)存墻問題制約算法發(fā)揮。如在典型模型與并行方式下,Nvidia Hopper一代芯片的有效算力(HFU)明顯低于Ampere一代芯片,如圖2所示。另一種通過Scale out擴(kuò)展集群規(guī)模提升整體算力的方式也受到GBS(Global Batch Size)不能無限增長的限制,導(dǎo)致在集群規(guī)模增大到一定程度后,HFU出現(xiàn)明顯下降。最后,模型參數(shù)量增大需要更大的模型并行規(guī)模,模型并行中Tensor并行或MOE類型的Expert并行都會(huì)在GPU之間產(chǎn)生大量的通信,并且這部分通信很難與計(jì)算進(jìn)行overlap。而當(dāng)前典型一機(jī)八卡服務(wù)器限制了Tensor并行的規(guī)模或Expert并行通過機(jī)間網(wǎng)絡(luò),這都會(huì)導(dǎo)致HFU無法提高。

圖2 不同型號(hào)GPU以及不同規(guī)模集群對(duì)HFU的影響

通過scale up擴(kuò)大HBD(超帶寬域)的超節(jié)點(diǎn)成為突破方向

HBD(High Bandwidth Domain)是一組以超帶寬(HB)互聯(lián)GPU-GPU的系統(tǒng)2。HBD內(nèi)GPU-GPU通信帶寬是HBD之間GPU-GPU通信帶寬的數(shù)倍。如Nvidia H100 提供900GBps HB帶寬,HBD間GPU-GPU通信帶寬只有100GBps。因此在模型并行中將數(shù)據(jù)量大、無法overlap的部分限制在一個(gè)HBD內(nèi)完成。

當(dāng)前,HBD限制在一臺(tái)服務(wù)器內(nèi),典型1機(jī)8卡服務(wù)器是8張GPU卡之間通過某種HB連接技術(shù)實(shí)現(xiàn)互聯(lián),構(gòu)成一個(gè)HBD=8的系統(tǒng)。然而更大的參數(shù)規(guī)模、更長的序列長度、更多的MOE專家數(shù)量、更大的集群規(guī)模,都造成了更多的通信數(shù)據(jù)量。HBD=8的情況下,大量的數(shù)據(jù)通信均需經(jīng)過HBD間的scale out網(wǎng)絡(luò),因此通信占比提高、HFU下降的問題凸顯。

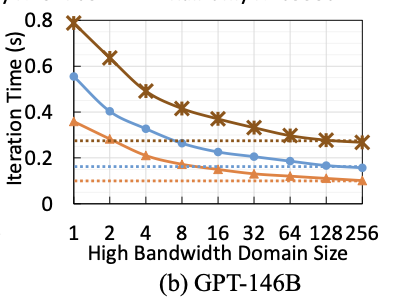

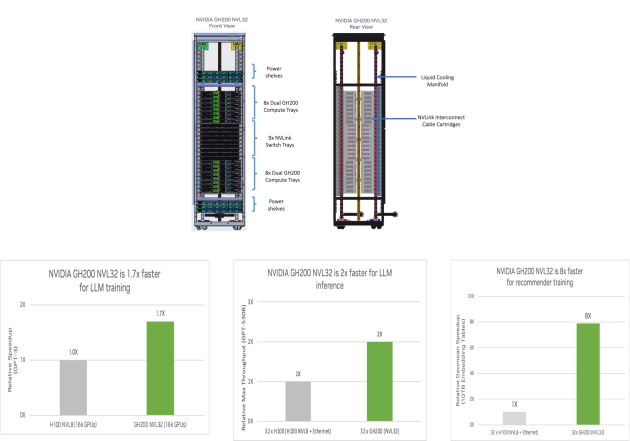

通過構(gòu)建更大的HBD系統(tǒng),以scale up方式提升系統(tǒng)算力是解決上述問題的有效途徑之一。如MIT與Meta的研究論文中,通過建模分析3,論證了擴(kuò)大HBD對(duì)訓(xùn)練性能的提升效果。另外,Nvidia也實(shí)現(xiàn)了不同規(guī)模HBD系統(tǒng)并進(jìn)行了部署與驗(yàn)證4。

圖3 HBD超節(jié)點(diǎn)典型代表與業(yè)務(wù)收益舉例

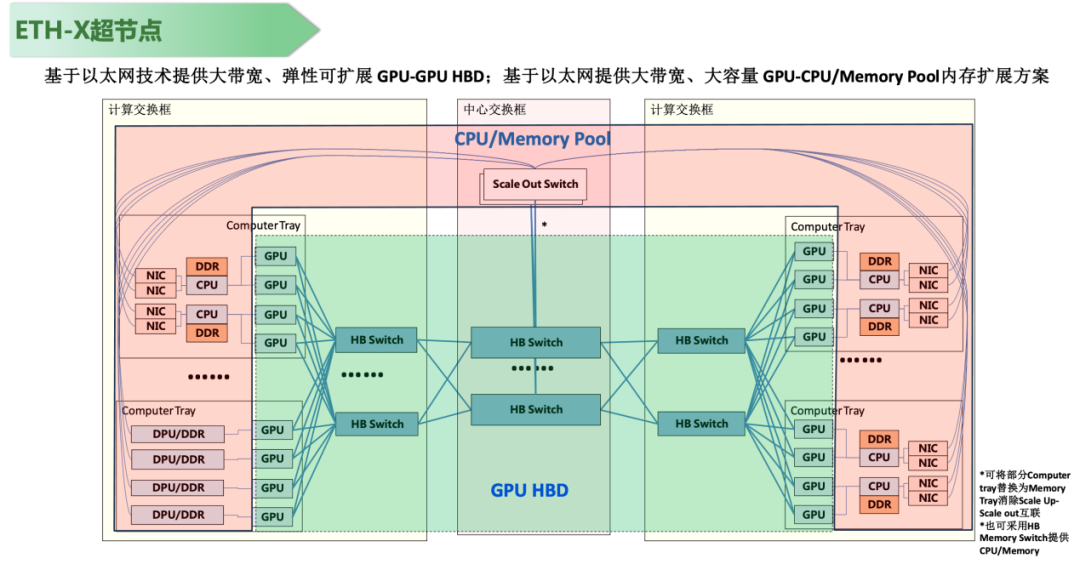

Nvidia將HB互聯(lián)不僅用于GPU-GPU之間,而是將其應(yīng)用到GPU-CPU/Memory的超大帶寬互聯(lián),例如GH200、GB200產(chǎn)品。通過此方式為GPU提供一個(gè)超帶寬訪問CPU/Memory的能力。

Nvidia產(chǎn)品具備支持GPU-CPU/Memory的統(tǒng)一內(nèi)存編制以及GPU通過內(nèi)存語義接口read/write直接訪問CPU/Memory的能力,具有更高效、更直接的特點(diǎn)。但其同步操作的方式會(huì)對(duì)時(shí)延進(jìn)行限制,制約可訪問CPU/Memory的距離與容量。另外,目前的軟件生態(tài)中,未有支持直接通過內(nèi)存語義訪問CPU/Memory的系統(tǒng)。

相反若使用異步的memory offload方式將降低對(duì)時(shí)延的約束,并發(fā)利用多節(jié)點(diǎn)CPU/Memory,發(fā)揮HB互聯(lián)的帶寬優(yōu)勢。另外,當(dāng)前memory offload已具備一定軟件生態(tài)上的基礎(chǔ),例如Zero offload5。

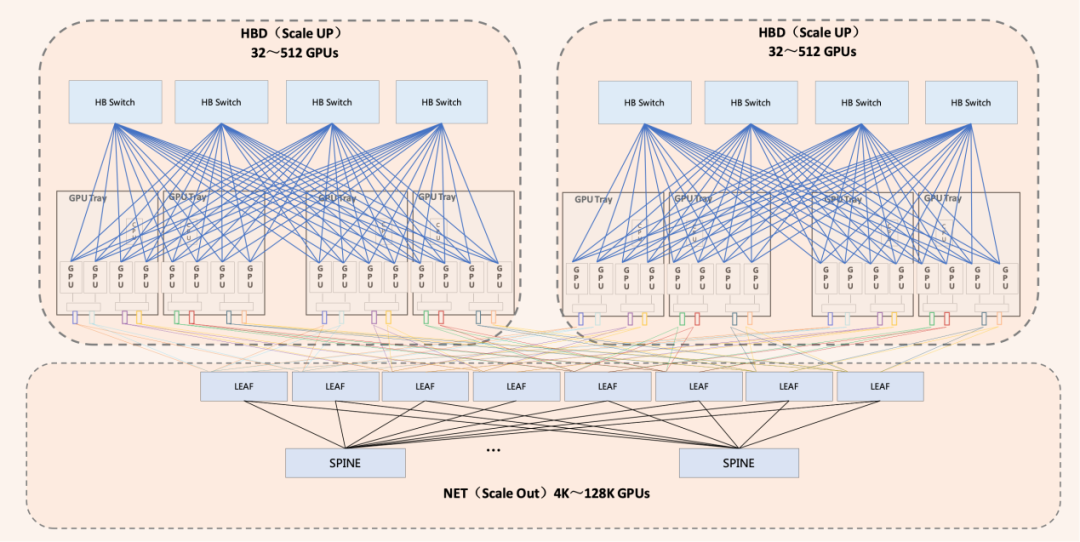

綜上所述,超節(jié)點(diǎn)是一個(gè)以超大帶寬(HB)互聯(lián)16卡以上GPU-GPU以及GPU-CPU/Memory的scale up系統(tǒng),以HBD超節(jié)點(diǎn)為單位,通過傳統(tǒng)scale out擴(kuò)展方式可形成更大規(guī)模、更高效的算力集群。超節(jié)點(diǎn)Scale Up的核心需求是超大帶寬(HB),但規(guī)模不需要很大。Scale Out的核心需求是超大規(guī)模。因此Scale Up網(wǎng)絡(luò)與Scale Out網(wǎng)絡(luò)更適合是相互獨(dú)立共存的兩張網(wǎng)絡(luò)。

圖4 Scale Up超大帶寬與Scale Out超大規(guī)模共同構(gòu)建高算力AI集群

ODCC ETH-X計(jì)劃構(gòu)建開放超節(jié)點(diǎn)產(chǎn)業(yè)生態(tài)

超節(jié)點(diǎn)的核心是HB互聯(lián)技術(shù),當(dāng)前工業(yè)界已實(shí)現(xiàn)的超節(jié)點(diǎn)系統(tǒng)均是采用私有技術(shù)與協(xié)議實(shí)現(xiàn)HB互聯(lián),例如Nvidia的NVLINK。但此類私有技術(shù)與協(xié)議由單一企業(yè)進(jìn)行維護(hù),無法保證技術(shù)長期、高效的發(fā)展。另外,從HBD超節(jié)點(diǎn)產(chǎn)品完善角度也無法保證系統(tǒng)的開放,導(dǎo)致無法形成良性、開放的產(chǎn)業(yè)生態(tài)。

以太網(wǎng)技術(shù)憑借開放的生態(tài)、多樣的產(chǎn)業(yè)鏈環(huán)境,為技術(shù)的長期演進(jìn)發(fā)展提供支撐。當(dāng)前以太網(wǎng)技術(shù)上從端口帶寬及交換容量方面已具有較強(qiáng)的競爭基礎(chǔ)。如以太網(wǎng)單端口800G MAC標(biāo)準(zhǔn)已成熟并產(chǎn)業(yè)化,以太網(wǎng)單芯片51.2T交換容量 ETH-switch也已在2023年產(chǎn)品化商用。

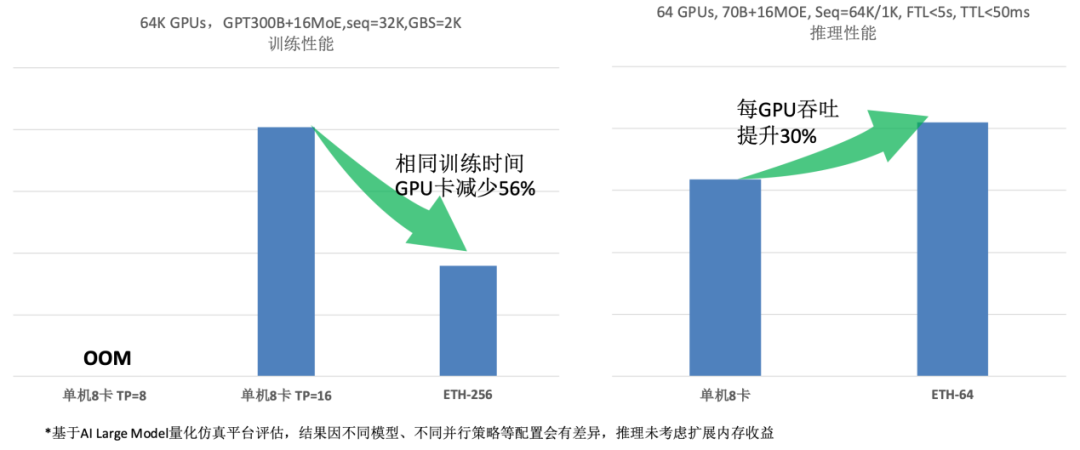

目前,以太網(wǎng)HB接口GPU產(chǎn)品的日益豐富,HBD超節(jié)點(diǎn)系統(tǒng)正逐步依托于以太網(wǎng)互聯(lián)技術(shù),實(shí)現(xiàn)向更為模塊化、多元化的結(jié)構(gòu)轉(zhuǎn)型,有效促進(jìn)了多方廠商的積極參與,各廠商專精于系統(tǒng)內(nèi)的不同組件或子系統(tǒng)開發(fā),顯著提升了HBD超節(jié)點(diǎn)產(chǎn)品化的多樣性和方案的豐富度,為HBD超節(jié)點(diǎn)技術(shù)長期演進(jìn)奠定穩(wěn)固基石,確保其在應(yīng)對(duì)未來挑戰(zhàn)時(shí)能夠持續(xù)進(jìn)化,保持領(lǐng)先的技術(shù)競爭力與生態(tài)活力。

圖5 ETH-X超節(jié)點(diǎn)參考架構(gòu)與預(yù)期收益評(píng)估

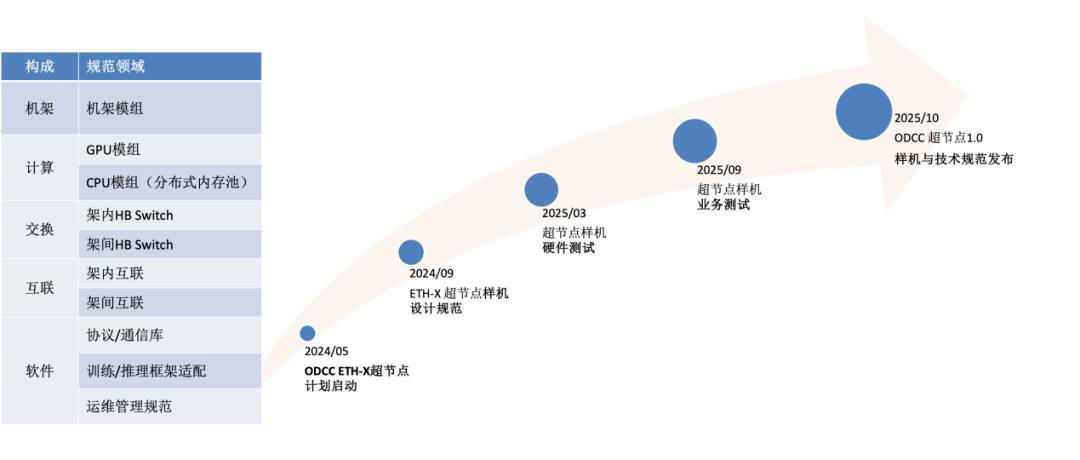

圖6 ETH-X技術(shù)規(guī)范構(gòu)成與項(xiàng)目計(jì)劃

為推動(dòng)算力產(chǎn)業(yè)的發(fā)展,ODCC網(wǎng)絡(luò)組啟動(dòng)了ETH-X超節(jié)點(diǎn)系列項(xiàng)目。該項(xiàng)目由中國信通院、騰訊聯(lián)合快手科技、燧原科技、壁仞科技、華勤技術(shù)、銳捷網(wǎng)絡(luò)、新華三、云豹智能、云合智網(wǎng)、盛科通信、立訊精密、光迅科技等合作伙伴共同推動(dòng),以產(chǎn)品化樣機(jī)以及相關(guān)技術(shù)規(guī)范為目標(biāo),打造大型多GPU互聯(lián)算力集群系統(tǒng)。該項(xiàng)目計(jì)劃在2025年秋季前完成ETH-X超節(jié)點(diǎn)樣機(jī)軟硬件研發(fā)與相關(guān)業(yè)務(wù)系統(tǒng)驗(yàn)證測試,同時(shí)發(fā)布ETH-X超節(jié)點(diǎn)技術(shù)規(guī)范1.0。

-

AI

+關(guān)注

關(guān)注

88文章

34810瀏覽量

277265 -

人工智能

+關(guān)注

關(guān)注

1805文章

48913瀏覽量

248067 -

算力

+關(guān)注

關(guān)注

2文章

1175瀏覽量

15559

原文標(biāo)題:ETH-X超節(jié)點(diǎn):探索突破AI算力約束的新途徑

文章出處:【微信號(hào):SDNLAB,微信公眾號(hào):SDNLAB】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

云XR(AR/VR)算力底座關(guān)鍵特征與技術(shù)路徑

軟通智算完成超億級(jí)A輪融資,加速AI算力產(chǎn)業(yè)布局

奇異摩爾邀您相約2025中國AI算力大會(huì)

華為云黃瑾:昇騰云CloudMatrix 384超節(jié)點(diǎn)六大科技創(chuàng)新,定義下一代AI基礎(chǔ)設(shè)施

華為云超節(jié)點(diǎn)創(chuàng)新算力基礎(chǔ)設(shè)施,推動(dòng)千行萬業(yè)AI應(yīng)用開發(fā)落地

DeepSeek推動(dòng)AI算力需求:800G光模塊的關(guān)鍵作用

存力接棒算力,慧榮科技以主控技術(shù)突破AI存儲(chǔ)極限

信而泰CCL仿真:解鎖AI算力極限,智算中心網(wǎng)絡(luò)性能躍升之道

大模型遭遇算力墻,探索超級(jí)應(yīng)用的發(fā)展路徑

寧暢AI服務(wù)器全面支持DeepSeek大模型

企業(yè)AI算力租賃模式的好處

奇異摩爾分享計(jì)算芯片Scale Up片間互聯(lián)新途徑

ETH-X超節(jié)點(diǎn):開辟AI算力約束突破的新路徑

ETH-X超節(jié)點(diǎn):開辟AI算力約束突破的新路徑

評(píng)論