2025年伊始,后摩智能在三大國(guó)際頂會(huì)(AAAI、ICLR、DAC)中斬獲佳績(jī),共有5篇論文被收錄,覆蓋大語(yǔ)言模型(LLM)推理優(yōu)化、模型量化、硬件加速等前沿方向。

AAAI作為人工智能領(lǐng)域的綜合性頂級(jí)會(huì)議,聚焦AI基礎(chǔ)理論與應(yīng)用創(chuàng)新;ICLR作為深度學(xué)習(xí)領(lǐng)域的權(quán)威會(huì)議,專注于表示學(xué)習(xí)、神經(jīng)網(wǎng)絡(luò)架構(gòu)和優(yōu)化方法等基礎(chǔ)技術(shù);DAC則是電子設(shè)計(jì)自動(dòng)化(EDA)領(lǐng)域最重要的國(guó)際學(xué)術(shù)會(huì)議之一,涵蓋半導(dǎo)體設(shè)計(jì)、計(jì)算機(jī)體系結(jié)構(gòu)、硬件加速、芯片設(shè)計(jì)自動(dòng)化、低功耗計(jì)算、可重構(gòu)計(jì)算以及AI在芯片設(shè)計(jì)中的應(yīng)用等方向。以下為后摩智能本年度入選論文概述:

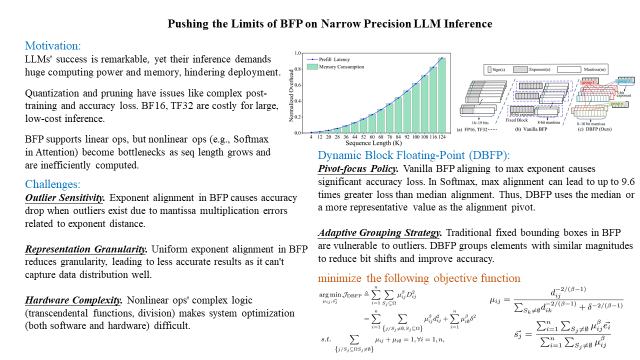

01【AAAI-2025】Pushing the Limits of BFP on Narrow Precision LLM Inference

?論文鏈接:https://arxiv.org/abs/2502.00026

大語(yǔ)言模型(LLMs)在計(jì)算和內(nèi)存方面的巨大需求阻礙了它們的部署。塊浮點(diǎn)(BFP)已被證明在加速線性運(yùn)算(LLM 工作負(fù)載的核心)方面非常有效。然而,隨著序列長(zhǎng)度的增長(zhǎng),非線性運(yùn)算(如注意力機(jī)制)由于其二次計(jì)算復(fù)雜度,逐漸成為性能瓶頸。這些非線性運(yùn)算主要依賴低效的浮點(diǎn)格式,導(dǎo)致軟件優(yōu)化困難和硬件開(kāi)銷較高。

在本論文中,我們深入研究了BFP在非線性運(yùn)算中的局限性和潛力。基于研究結(jié)果,我們提出了一種軟硬件協(xié)同設(shè)計(jì)框架(DB-Attn),其中包括:

DBFP:一種先進(jìn)的 BFP 變體,采用樞軸聚焦策略(pivot-focus strategy)以適應(yīng)不同數(shù)據(jù)分布,并采用自適應(yīng)分組策略(adaptive grouping strategy)以實(shí)現(xiàn)靈活的指數(shù)共享,從而克服非線性運(yùn)算的挑戰(zhàn)。

DH-LUT:一種創(chuàng)新的查找表(LUT)算法,專門(mén)用于基于 DBFP 格式加速非線性運(yùn)算。

基于DBFP的硬件引擎:我們實(shí)現(xiàn)了一個(gè)RTL級(jí)的DBFP 計(jì)算引擎,支持FPGA和ASIC部署。

實(shí)驗(yàn)結(jié)果表明,DB-Attn在LLaMA的Softmax運(yùn)算上實(shí)現(xiàn)了 74%的GPU加速,并在與SOTA設(shè)計(jì)相比,計(jì)算開(kāi)銷降低10 倍,同時(shí)保持了可忽略的精度損失。

02【ICLR-2025】OSTQuant: Refining Large Language Model Quantization with Orthogonal and Scaling Transformations for Better Distribution Fitting

?論文鏈接:https://arxiv.org/abs/2501.13987

后訓(xùn)練量化(Post-Training Quantization, PTQ)已成為廣泛采用的技術(shù),用于壓縮和加速大語(yǔ)言模型(LLMs)。LLM量化的主要挑戰(zhàn)在于,數(shù)據(jù)分布的不均衡性和重尾特性會(huì)擴(kuò)大量化范圍,從而減少大多數(shù)值的比特精度。近年來(lái),一些方法嘗試通過(guò)線性變換來(lái)消異常值并平衡通道間差異,但這些方法仍然具有啟發(fā)性,往往忽略了對(duì)整個(gè)量化空間內(nèi)數(shù)據(jù)分布的優(yōu)化。

在本文中,我們引入了一種新的量化評(píng)估指標(biāo)——量化空間利用率(QSUR, Quantization Space Utilization Rate),該指標(biāo)通過(guò)衡量數(shù)據(jù)在量化空間中的利用情況,有效評(píng)估數(shù)據(jù)的量化能力。同時(shí),我們通過(guò)數(shù)學(xué)推導(dǎo)分析了各種變換的影響及其局限性,為優(yōu)化量化方法提供了理論指導(dǎo),并提出了基于正交和縮放變換的量化方法(OSTQuant)。

OSTQuant 采用 可學(xué)習(xí)的等效變換,包括正交變換和縮放變換,以優(yōu)化權(quán)重和激活值在整個(gè)量化空間中的分布。此外,我們提出了KL-Top損失函數(shù),該方法在優(yōu)化過(guò)程中減少噪聲,同時(shí)在 PTQ 限制的校準(zhǔn)數(shù)據(jù)下保留更多語(yǔ)義信息。

實(shí)驗(yàn)結(jié)果表明,OSTQuant在各種 LLM 和基準(zhǔn)測(cè)試上均優(yōu)于現(xiàn)有方法。在W4-only 量化設(shè)置下,它保留了99.5%的浮點(diǎn)精度。在更具挑戰(zhàn)性的W4A4KV4量化配置中,OSTQuant在 LLaMA-3-8B 模型上的性能差距相比SOTA方法減少了32%。

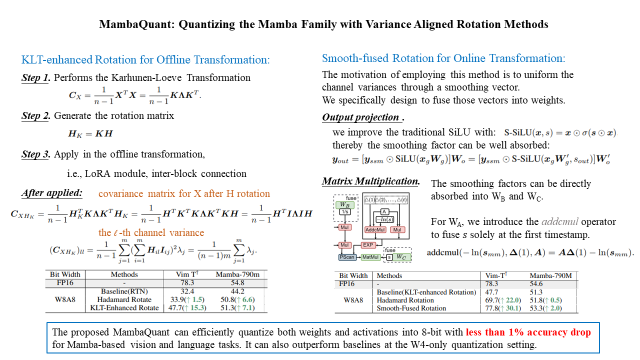

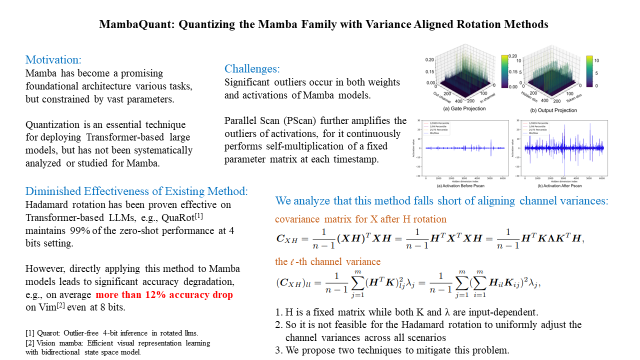

03【ICLR-2025】MambaQuant:Quantizing the Mamba Family with Variance Aligned Rotation Methods

?論文鏈接:https://arxiv.org/abs/2501.13484

Mamba是一種高效的序列模型,其性能可與Transformer相媲美,并在各種任務(wù)中展現(xiàn)出作為基礎(chǔ)架構(gòu)的巨大潛力。量化(Quantization)通常用于神經(jīng)網(wǎng)絡(luò),以減少模型大小并降低計(jì)算延遲。然而,對(duì)于Mamba進(jìn)行量化的研究仍然較少,而現(xiàn)有的量化方法——盡管在CNN和Transformer模型上表現(xiàn)良好——在Mamba模型上的效果卻不理想(例如,即使在W8A8 設(shè)置下,Quarot 在Vim-T?上的準(zhǔn)確率仍下降了 21%)。

我們率先對(duì)這一問(wèn)題進(jìn)行了深入研究,并識(shí)別出了幾個(gè)關(guān)鍵挑戰(zhàn)。首先,在門(mén)控投影(gate projections)、輸出投影(output projections)和矩陣乘法(matrix multiplications)中存在顯著的異常值(outliers)。其次,Mamba 獨(dú)特的并行掃描(Parallel Scan, PScan)進(jìn)一步放大了這些異常值,導(dǎo)致數(shù)據(jù)分布不均衡且具有重尾特性(heavy-tailed distributions)。第三,即便應(yīng)用 Hadamard 變換,不同通道中的權(quán)重和激活值的方差仍然不一致。

為了解決這些問(wèn)題,我們提出了MambaQuant,一個(gè)后訓(xùn)練量化(PTQ)框架,其中包括:

KLT 增強(qiáng)旋轉(zhuǎn)(Karhunen-Loeve Transformation, KLT-Enhanced Rotation):將 Hadamard 變換與 KLT 結(jié)合,使得旋轉(zhuǎn)矩陣能夠適應(yīng)不同通道分布。

平滑融合旋轉(zhuǎn)(Smooth-Fused Rotation):均衡通道方差,并可將額外參數(shù)合并到模型權(quán)重中。

實(shí)驗(yàn)表明,MambaQuant 能夠在Mamba視覺(jué)和語(yǔ)言任務(wù)中將權(quán)重和激活量化至8-bit,且準(zhǔn)確率損失低于1%。據(jù)我們所知,MambaQuant是首個(gè)專門(mén)針對(duì) Mamba家族的全面PTQ方案,為其未來(lái)的應(yīng)用和優(yōu)化奠定了基礎(chǔ)。

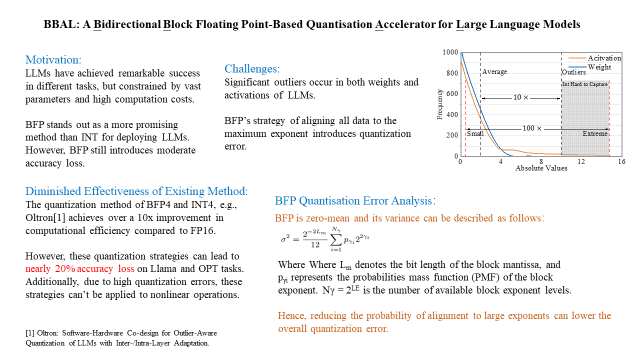

04【DAC-2025】BBAL: A Bidirectional Block Floating Point-Based Quantisation Accelerator for Large Language Models

大語(yǔ)言模型(LLMs)由于其包含數(shù)十億參數(shù),在部署于邊緣設(shè)備時(shí)面臨內(nèi)存容量和計(jì)算資源的巨大挑戰(zhàn)。塊浮點(diǎn)(BFP)量化通過(guò)將高開(kāi)銷的浮點(diǎn)運(yùn)算轉(zhuǎn)換為低比特的定點(diǎn)運(yùn)算,從而減少內(nèi)存和計(jì)算開(kāi)銷。然而,BFP需要將所有數(shù)據(jù)對(duì)齊到最大指數(shù)(max exponent),這會(huì)導(dǎo)致小值和中等值的丟失,從而引入量化誤差,導(dǎo)致LLMs 的精度下降。

為了解決這一問(wèn)題,我們提出了一種雙向塊浮點(diǎn)(BBFP, Bidirectional Block Floating-Point)數(shù)據(jù)格式,該格式降低了選擇最大指數(shù)作為共享指數(shù)的概率,從而減少量化誤差。利用 BBFP 的特性,我們進(jìn)一步提出了一種基于雙向塊浮點(diǎn)的量化加速器(BBAL),它主要包括一個(gè)基于BBFP 的處理單元(PE)陣列,并配備我們提出的高效非線性計(jì)算單元。

實(shí)驗(yàn)結(jié)果表明,與基于異常值感知(outlier-aware)的加速器相比,BBAL在相似計(jì)算效率下,精度提升22%;同時(shí),與傳統(tǒng)BFP量化加速器相比,BBAL在相似精度下計(jì)算效率提升 40%。

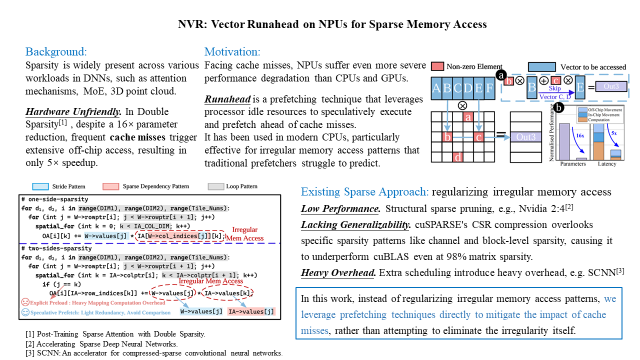

05【DAC-2025】NVR: Vector Runahead on NPUs for Sparse Memory Access

深度神經(jīng)網(wǎng)絡(luò)(DNNs)越來(lái)越多地利用稀疏性來(lái)減少模型參數(shù)規(guī)模的擴(kuò)展。然而,通過(guò)稀疏性和剪枝來(lái)減少實(shí)際運(yùn)行時(shí)間仍然面臨挑戰(zhàn),因?yàn)椴灰?guī)則的內(nèi)存訪問(wèn)模式會(huì)導(dǎo)致頻繁的緩存未命中(cache misses)。在本文中,我們提出了一種專門(mén)針對(duì)NPU(神經(jīng)處理單元)設(shè)計(jì)的預(yù)取機(jī)制——NPU向量超前執(zhí)行(NVR, NPU Vector Runahead),用于解決稀疏DNN任務(wù)中的緩存未命中問(wèn)題。與那些通過(guò)高開(kāi)銷優(yōu)化內(nèi)存訪問(wèn)模式但可移植性較差的方法不同,NVR 采用超前執(zhí)行(runahead execution),并針對(duì)NPU 架構(gòu)的特點(diǎn)進(jìn)行適配。

NVR 提供了一種通用的微架構(gòu)級(jí)解決方案,能夠無(wú)需編譯器或算法支持地優(yōu)化稀疏DNN任務(wù)。它以分離、推測(cè)性(speculative)、輕量級(jí)的硬件子線程的形式運(yùn)行,并行于 NPU,且額外的硬件開(kāi)銷低于5%。

實(shí)驗(yàn)結(jié)果表明,NVR 將L2緩存未命中率降低了90%(相比最先進(jìn)的通用處理器預(yù)取機(jī)制),并在稀疏任務(wù)上使NPU計(jì)算速度提升4倍(與無(wú)預(yù)取 NPU 相比)。此外,我們還研究了在NPU 中結(jié)合小型緩存(16KB)與NVR預(yù)取的優(yōu)勢(shì)。我們的評(píng)估表明,增加這一小型緩存的性能提升效果比等量擴(kuò)展L2緩存高5倍。

這5篇論文聚焦于大語(yǔ)言模型的優(yōu)化、量化和硬件加速等關(guān)鍵技術(shù),從算法創(chuàng)新到硬件適配,系統(tǒng)性地展現(xiàn)了后摩智能在AI軟硬件協(xié)同領(lǐng)域的深厚積累。研究成果從計(jì)算效率、能效優(yōu)化和部署靈活性等多個(gè)維度,突破了大模型高效部署的技術(shù)瓶頸,為邊緣計(jì)算場(chǎng)景下的大模型壓縮與加速提供了創(chuàng)新性解決方案。期待這些工作能夠?yàn)榇竽P驮诙诉厒?cè)的高效部署提供新范式,推動(dòng)通用智能向更普惠、更可持續(xù)的方向演進(jìn)。

接下來(lái),我們將對(duì)5篇論文展開(kāi)深度解析,詳細(xì)探討每篇論文的技術(shù)細(xì)節(jié)、創(chuàng)新點(diǎn)等,敬請(qǐng)關(guān)注。

-

芯片

+關(guān)注

關(guān)注

459文章

52360瀏覽量

438836 -

計(jì)算機(jī)

+關(guān)注

關(guān)注

19文章

7647瀏覽量

90493 -

AI

+關(guān)注

關(guān)注

88文章

34809瀏覽量

277229 -

后摩智能

+關(guān)注

關(guān)注

0文章

34瀏覽量

1345

原文標(biāo)題:后摩前沿 | AAAI+ICLR+DAC,后摩智能5篇論文入選國(guó)際頂會(huì)

文章出處:【微信號(hào):后摩智能,微信公眾號(hào):后摩智能】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

后摩智能入圍工信部算力強(qiáng)基揭榜行動(dòng)

后摩智能四篇論文入選三大國(guó)際頂會(huì)

云知聲四篇論文入選自然語(yǔ)言處理頂會(huì)ACL 2025

后摩智能NPU適配通義千問(wèn)Qwen3系列模型

后摩智能入選中國(guó)移動(dòng)AI能力聯(lián)合艦隊(duì)

后摩智能攜手聯(lián)想開(kāi)天打造基于DeepSeek的信創(chuàng)AI PC

經(jīng)緯恒潤(rùn)功能安全AI 智能體論文成功入選EMNLP 2024!

后摩智能首款存算一體智駕芯片獲評(píng)突出創(chuàng)新產(chǎn)品獎(jiǎng)

后摩智能與聯(lián)想攜手共創(chuàng)AI PC新紀(jì)元

后摩智能與聯(lián)想集團(tuán)簽署戰(zhàn)略協(xié)議 共同探索AI PC技術(shù)創(chuàng)新與應(yīng)用

地平線科研論文入選國(guó)際計(jì)算機(jī)視覺(jué)頂會(huì)ECCV 2024

芯動(dòng)力科技論文入選ISCA 2024,與國(guó)際巨頭同臺(tái)交流研究成果

谷歌DeepMind被曝抄襲開(kāi)源成果,論文還中了頂流會(huì)議

后摩智能5篇論文入選國(guó)際頂會(huì)

后摩智能5篇論文入選國(guó)際頂會(huì)

評(píng)論