近期科技圈對(duì)Deepseek R1的熱度持續(xù)升溫。這款AI模型是否真的如傳聞中那般神奇?讓我通過Raspberry Pi實(shí)測(cè)帶您一探究竟。

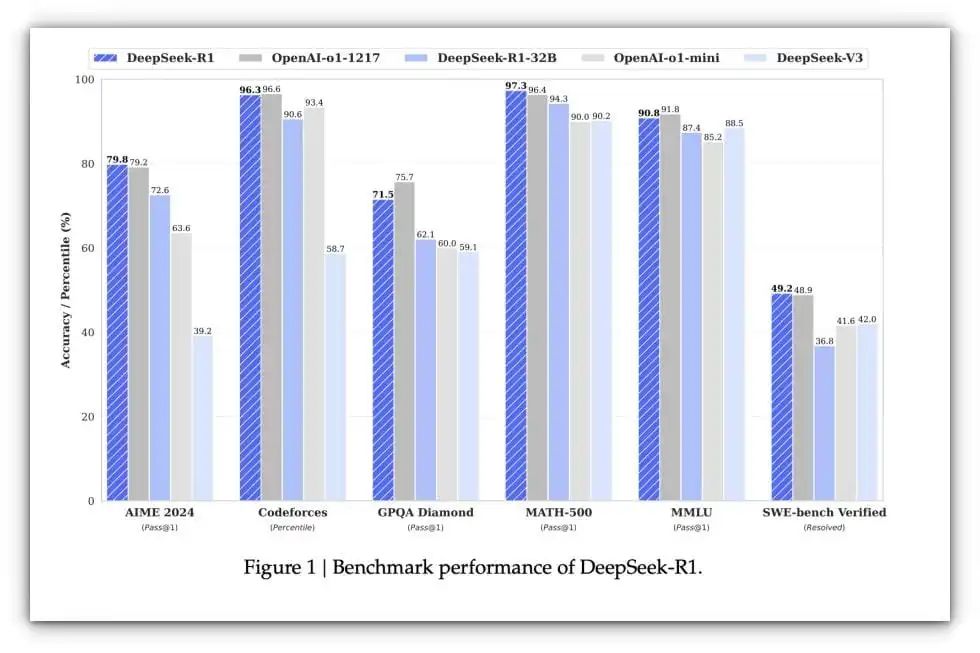

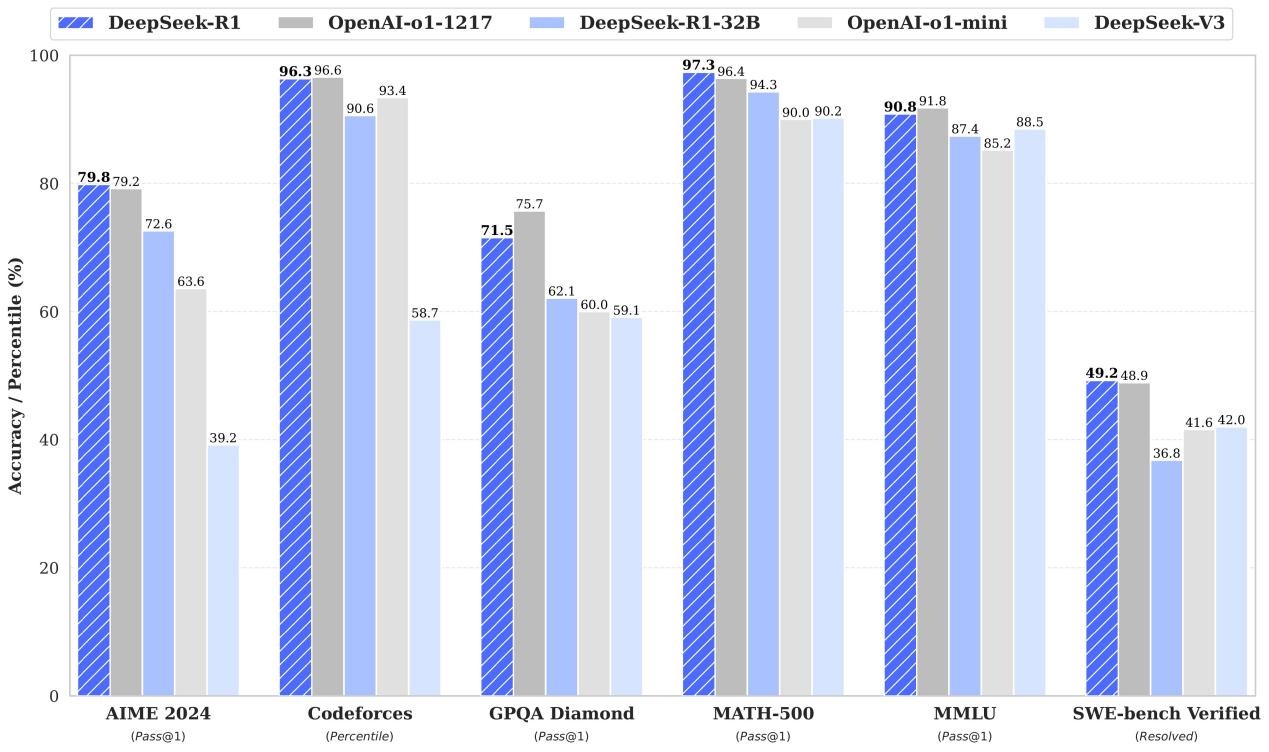

自DeepSeek AI發(fā)布以來(lái),科技媒體圈就掀起了一場(chǎng)風(fēng)暴。這款模型不斷打破性能基準(zhǔn)測(cè)試記錄,儼然已成為AI創(chuàng)新領(lǐng)域的標(biāo)桿。

DeepSeek與OpenAI基準(zhǔn)對(duì)比 | 來(lái)源:Brian Roemmele

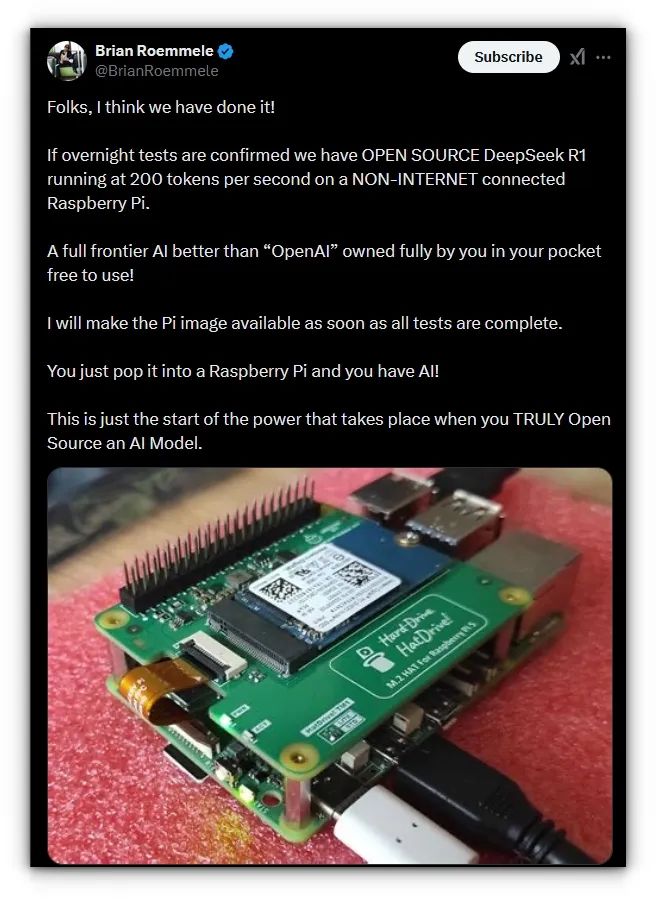

最近我在X平臺(tái)偶然看到有人聲稱在Raspberry Pi上以200 token/秒的速度運(yùn)行Deepseek。

這讓我瞬間懷疑人生:"什么鬼?!"

仔細(xì)研究整個(gè)討論串后發(fā)現(xiàn),該用戶是通過在Raspberry Pi上疊加AI加速模塊才達(dá)成的成績(jī)。但好奇心驅(qū)使我決定挑戰(zhàn)極限:在沒有額外硬件的情況下,用原生Raspberry Pi 5(8GB版)測(cè)試Deepseek的真實(shí)性能。

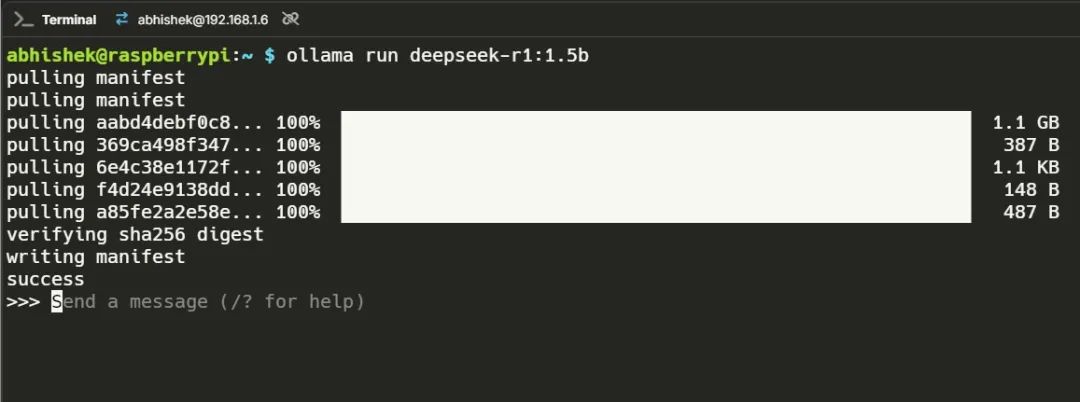

因此,為了這篇文章,我在我的Raspberry Pi 5(8GB內(nèi)存型號(hào))上安裝了Ollama,并下載了具有不同參數(shù)(即15B、70B、80B和140B參數(shù))的Deepseek模型。

Ollama:

https://ollama.com/

Deepseek模型:

https://ollama.com/library/deepseek-r1

以下是每個(gè)模型的性能表現(xiàn):

Deepseek 1.5B

這個(gè)模型反應(yīng)迅速。它出乎意料地靈敏,能夠輕松處理改寫任務(wù)。我沒有遇到任何幻覺(生成不符合邏輯或上下文的內(nèi)容)問題,這使其成為日常任務(wù)(如摘要生成和文本生成)的理想選擇。

性能數(shù)據(jù)

為了進(jìn)一步測(cè)試其能力,我提出了一個(gè)問題:Podman和Docker有什么區(qū)別?

模型給出了相當(dāng)不錯(cuò)的回答,清晰地闡述了這兩種容器化工具之間的區(qū)別。它強(qiáng)調(diào)了Podman是無(wú)守護(hù)進(jìn)程的,而Docker依賴于守護(hù)進(jìn)程,并涉及了無(wú)根操作等安全方面。

這個(gè)回答花了大約兩分鐘,以下是性能數(shù)據(jù):

總時(shí)長(zhǎng):1m33.59302487s加載時(shí)長(zhǎng):44.322672ms提示評(píng)估次數(shù):13個(gè)tokens提示評(píng)估時(shí)長(zhǎng):985ms提示評(píng)估速率:13.20個(gè)tokens/s評(píng)估次數(shù):855個(gè)tokens評(píng)估時(shí)長(zhǎng):1m32.562s評(píng)估速率:9.24個(gè)tokens/s

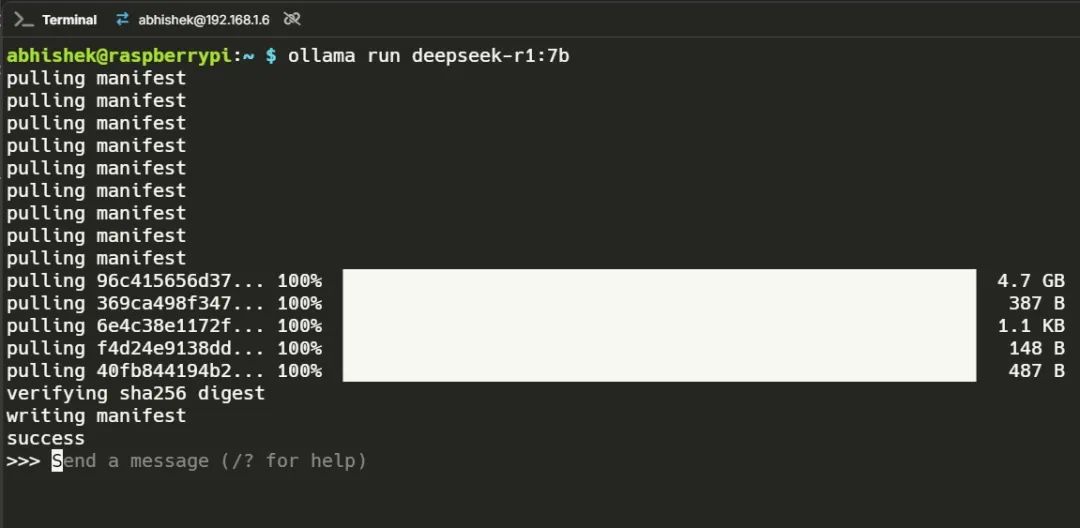

Deepseek 7B

7B模型引入了一定程度的幻覺。我嘗試編寫一個(gè)創(chuàng)意提示,要求生成三首俳句,但它開始生成無(wú)盡的文本,甚至自己?jiǎn)栕约簡(jiǎn)栴}!

雖然很有趣,但并不實(shí)用。為了基準(zhǔn)測(cè)試的目的,我簡(jiǎn)化了提示,如視頻所示。在性能方面,它更慢,但仍然可用。

性能數(shù)據(jù)

為了進(jìn)一步測(cè)試,我問:Docker Compose和Docker Run有什么區(qū)別?回答是準(zhǔn)確信息和不準(zhǔn)確信息的混合體。

它正確地解釋了Docker Compose通過docker-compose.yml文件用于管理多容器應(yīng)用程序,而Docker Run通常用于使用特定標(biāo)志運(yùn)行單個(gè)容器。

然而,它很快就開始自己?jiǎn)枂栴},比如“但是,對(duì)于一個(gè)單應(yīng)用,比如單臺(tái)機(jī)器上的簡(jiǎn)單Flask應(yīng)用,Docker Run可能就足夠了?還是有其他命令或方法?”

以下是性能數(shù)據(jù):

總時(shí)長(zhǎng):4m20.665430872s加載時(shí)長(zhǎng):39.565944ms提示評(píng)估次數(shù):11個(gè)token(s)提示評(píng)估時(shí)長(zhǎng):3.256s提示評(píng)估速率:3.38個(gè)token/秒評(píng)估次數(shù):517個(gè)token評(píng)估時(shí)長(zhǎng):4m17.368s評(píng)估速率:2.01個(gè)token/秒

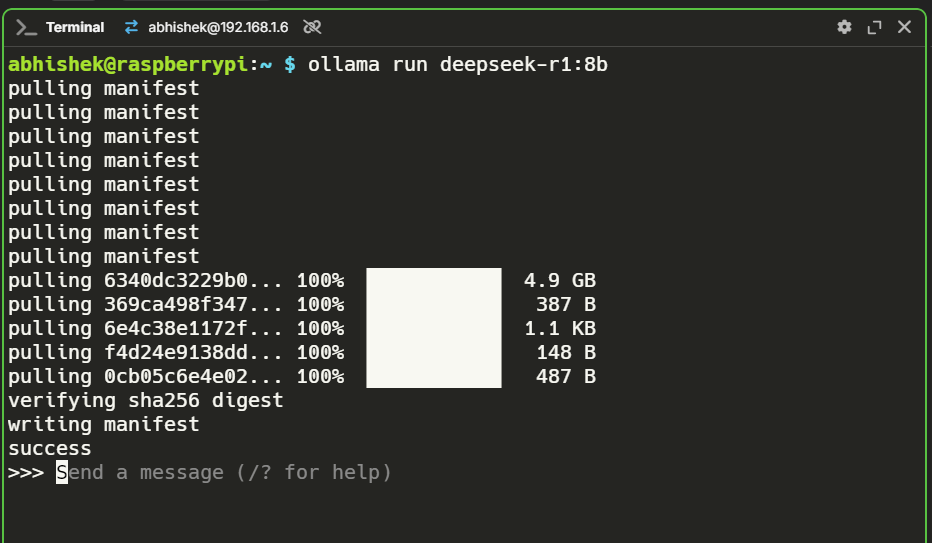

Deepseek 8B

這是一個(gè)變數(shù)。考慮到這些模型對(duì)資源的巨大需求,我沒想到8B模型能運(yùn)行起來(lái)。令我驚訝的是,它竟然成功了!

性能與7B模型相當(dāng),既不快,也不是特別靈敏,但在沒有任何額外硬件的Raspberry Pi上運(yùn)行一個(gè)8B模型,在我看來(lái)就是勝利。

性能數(shù)據(jù)

我通過提問“編寫一個(gè)HTML模板和CSS模板”來(lái)測(cè)試它。模型成功地在單個(gè)代碼塊中生成了一個(gè)功能性的HTML和CSS模板,并確保它們整齊地配對(duì)。

然而,在跳到解決方案之前,模型解釋了它的方法、它將要做什么以及還可以添加什么。

雖然這提供了信息,但對(duì)于一個(gè)直接的查詢來(lái)說(shuō),這感覺是不必要的。如果我更精確地構(gòu)造提示,回答可能會(huì)更直接(即用戶錯(cuò)誤)。

以下是性能數(shù)據(jù):

總時(shí)長(zhǎng):6m53.350371838s加載時(shí)長(zhǎng):44.410437ms提示評(píng)估次數(shù):13個(gè) token(s)提示評(píng)估時(shí)長(zhǎng):4.99s提示評(píng)估速率:2.61個(gè)tokens/s評(píng)估次數(shù):826個(gè)token評(píng)估時(shí)長(zhǎng):6m48.314s評(píng)估速率:2.02個(gè)tokens/s

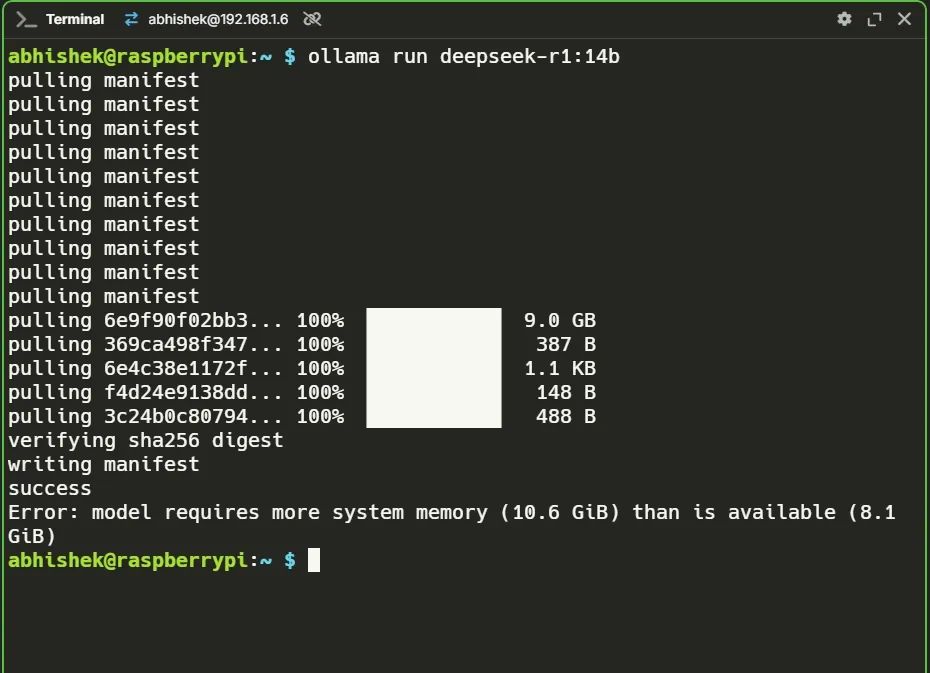

Deepseek 14B?

不幸的是,這并沒有成功。14B模型需要超過10GB的內(nèi)存,而我的8GB Raspberry Pi無(wú)法處理。在8B模型成功后,我充滿希望,但現(xiàn)實(shí)給了我一擊。

結(jié)論

DeepSeek在Raspberry Pi 5上的原始性能展示了單板計(jì)算機(jī)(SBC)在處理AI工作負(fù)載方面的巨大潛力。

1.5B模型是輕量級(jí)任務(wù)的實(shí)際選擇,而7B和8B模型則展示了Raspberry Pi處理更大工作負(fù)載的能力,盡管速度較慢。

-

樹莓派

+關(guān)注

關(guān)注

121文章

1978瀏覽量

107221 -

DeepSeek

+關(guān)注

關(guān)注

1文章

790瀏覽量

1555

發(fā)布評(píng)論請(qǐng)先 登錄

DeepSeek開源新版R1 媲美OpenAI o3

4臺(tái)樹莓派5跑動(dòng)大模型!DeepSeek R1分布式實(shí)戰(zhàn)!

RK3588開發(fā)板上部署DeepSeek-R1大模型的完整指南

OpenAI O3與DeepSeek R1:推理模型性能深度分析

安霸大算力AI芯片接入DeepSeek R1

IBM在watsonx.ai平臺(tái)推出DeepSeek R1蒸餾模型

了解DeepSeek-V3 和 DeepSeek-R1兩個(gè)大模型的不同定位和應(yīng)用選擇

超星未來(lái)驚蟄R1芯片適配DeepSeek-R1模型

景嘉微完成DeepSeek R1系列模型適配

Deepseek R1大模型離線部署教程

扣子平臺(tái)支持DeepSeek R1與V3模型

Krea發(fā)布Deepseek R1驅(qū)動(dòng)的Chat功能

云天勵(lì)飛上線DeepSeek R1系列模型

Deepseek R1在樹莓派5上的真實(shí)表現(xiàn)...

Deepseek R1在樹莓派5上的真實(shí)表現(xiàn)...

評(píng)論