Imagination Technologies 宣布率先完成百度文心大模型(ERNIE 4.5 開源版)在其 GPU 硬件上的端側部署。適配完成后,開發者可在搭載 Imagination GPU 的設備上實現高效本地 AI 推理,同時大幅降低推理成本,這一成果也標志著 Imagination GPU 在端側 AI 推理場景中的技術領先性。

Imagination高度優化軟件棧實現高效本地AI推理、降低成本

本次適配的文心4.5模型為開源版本,具備強大的智能問答、文本生成、語義理解和知識推理能力,廣泛適用于移動設備、語音助手、IoT和教育硬件等資源受限終端。在飛槳框架支持下,Imagination GPU平臺展現出出色的推理性能。

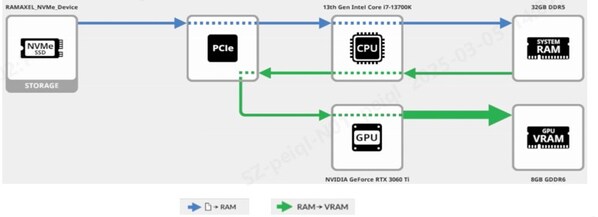

Imagination基于現有的GPU硬件順利完成了本次文心大模型系列開源模型部署軟件棧,并得到實際網絡驗證。同時,Imagination高度優化的計算軟件棧對AI本地推理性能進行優化,該軟件棧包含OpenCL計算庫,編譯器工具鏈,主流編程框架的參考開發套件(Reference Kits)。

其中參考開發套件可協助開發者通過TVM將主流AI框架中的代碼遷移至Imagination的軟件棧。該套件基于Imagination優化的OpenCL計算庫和圖編譯器,使用專屬API調用,提供全面的文檔說明和組件集成參考,便于客戶將其高效融入自身開發流程。

Imagination與百度協同創新,加速大模型端側普及

適配過程中,Imagination與百度團隊緊密合作,針對文心4.5的特點進行了優化。推理方面,百度文心提出了多專家并行協同量化方法和卷積編碼量化算法,實現了效果接近無損的4-bit量化和2-bit量化。此外,還實現了動態角色轉換的預填充、解碼分離部署技術,可以更充分地利用資源,提升文心4.5 MoE模型的推理性能。基于飛槳框架,文心4.5在Imagination GPU硬件平臺上表現出優異的推理性能。

Imagination在今年5月推出了面向邊緣AI的E 系列 GPU,具備高性能、低功耗和靈活可編程的特點,適用于自然語言處理、工業計算機視覺、自動駕駛等應用。此次與文心模型的成功適配,也為未來客戶在采用E系列GPU構建本地AI應用奠定了堅實基礎。

早在此前,Imagination加由入百度飛槳發起的 “硬件生態共創計劃”,將飛槳的先進算法和靈活性與 Imagination IP 技術相結合,為端側開發者提供強大支持。隨著邊緣計算需求的快速增長,Imagination將繼續與百度深入合作,推動大模型在端側設備的普及與落地,共同打造更高效、智能的本地AI體驗。

-

gpu

+關注

關注

28文章

4930瀏覽量

130986 -

AI

+關注

關注

88文章

34868瀏覽量

277554 -

imagination

+關注

關注

1文章

599瀏覽量

62138 -

大模型

+關注

關注

2文章

3101瀏覽量

3994

發布評論請先 登錄

兆芯率先展開文心系列模型深度技術合作

Imagination與澎峰科技攜手推動GPU+AI解決方案,共拓計算生態

MediaTek天璣9400率先完成阿里Qwen3模型部署

摩爾線程GPU率先支持Qwen3全系列模型

AI端側部署案例(SC171開發套件V3)

AI端側部署開發(SC171開發套件V3)

AI大模型端側部署正當時:移遠端側AI大模型解決方案,激活場景智能新范式

AI大模型端側部署正當時:移遠端側AI大模型解決方案,激活場景智能新范式

暢享DeepSeek自由,憶聯高性能CSSD為端側大模型加速

Say Hi to ERNIE!Imagination GPU率先完成文心大模型的端側部署

Say Hi to ERNIE!Imagination GPU率先完成文心大模型的端側部署

評論