機器人必須感知和理解其 3D 環境,才能安全高效地行動。這一點在非結構化或陌生空間中的自主導航、對象操作和遠程操作等任務尤為重要。當前機器人感知技術的進展,越來越多地體現在通過統一的實時工作流與強大的感知模塊,實現 3D 場景理解、可泛化物體跟蹤與持久性空間記憶的集成。

本期“NVIDIA 機器人研究與開發摘要 (R2D2) ”將探討 NVIDIA 研究中心的多個感知模型和系統,這些模型和系統支持統一的機器人 3D 感知堆棧。它們可在不同的真實世界環境中實現可靠的深度估計、攝像頭和物體位姿追蹤以及 3D 重建:

FoundationStereo(CVPR 2025 最佳論文提名):用于立體深度估計的基礎模型,可在各種環境(包括室內、室外、合成和真實場景)中實現零樣本性能的泛化。

PyCuVSLAM:用于 cuVSLAM 的 Python Wrapper,支持 Python 用戶利用 NVIDIA 的 CUDA 加速 SLAM 庫,用于實時攝像頭位姿估計和環境建圖。

BundleSDF:用于 RGB-D 視頻中 6-DoF 物體位姿追蹤和密集 3D 重建的神經系統。

FoundationPose:可泛化的 6D 物體位姿估計器和跟蹤器,適用于僅有最少先驗信息的新物體。

nvblox Pytorch Wrapper:nvblox 庫的 Pytorch wrapper,nvblox 是一個 CUDA 加速庫,用于 PyTorch 的深度攝像頭 3D 重建。

3D 空間表示:機器人感知的核心

這些項目的核心在于強調 3D 空間表示,即以機器人可以使用的形式捕獲環境或物體的結構。FoundationStereo 可處理立體圖像深度估計的基本任務。它引入了一個用于立體深度的基礎模型,專為實現強零樣本泛化而設計。

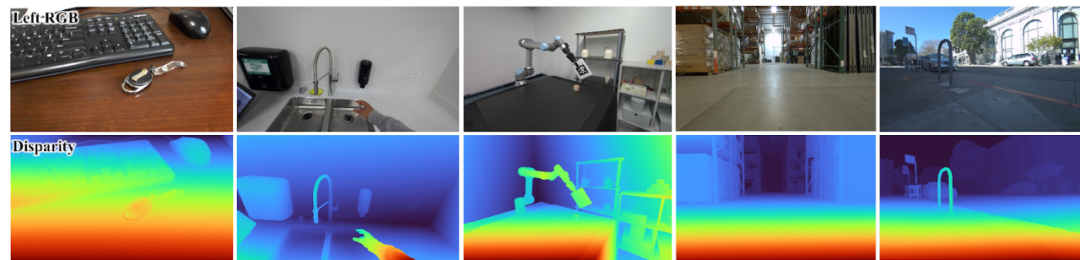

圖 1. 使用 FoundationStereo 生成的視差圖像

FoundationStereo 已在超過 100 萬對合成立體圖像上進行訓練。它無需針對特定場景進行調整,即可在各種環境(包括室內、室外、合成和真實場景,如圖 1 所示)中推斷出準確的視差,從而推理得到 3D 結構。輸出包括表示場景 3D 結構的密集深度圖或點云。

在環境映射方面,nvblox 和 cuVSLAM 等庫會隨著時間的推移構建空間表示。NVIDIA 的 nvblox 是一個 GPU 加速的 3D 重建庫,可重建體素網格體素網格,并輸出用于導航的 Euclidean signed distance field (ESDF) 熱圖。這使移動機器人能夠僅使用視覺進行 3D 避障,為昂貴的 3D 激光雷達傳感器提供了一種經濟高效的替代方案。

雖然 nvblox 擅長幾何映射,但缺乏對環境的語義理解。借助 nvblox_torch,我們引入了一個 PyTorch Wrapper,它可以將 2D VLM 基礎模型的語義嵌入提升到 3D。

同樣,cuVSLAM 通過 Isaac ROS 為機器人提供 GPU 加速的視覺慣性 SLAM。cuVSLAM 以前僅限于 ROS 用戶,現在可以通過名為 PyCuVSLAM 的新 Python API 進行訪問,這簡化了數據工程師和深度學習研究人員的集成工作。

深度和地圖構建模塊可創建幾何支架(無論是點云、signed distance fields,還是特征網格),并在此基礎上構建更高級別的感知和規劃。如果沒有可靠的 3D 呈現,機器人就無法準確感知、記憶或推理世界。

用于場景理解的實時 SLAM和攝像頭位姿估計

將這些項目連接在一起的一個關鍵方面是通過 SLAM(同步定位與地圖構建)實現實時場景理解。cuVSLAM 是一種高效的 CUDA 加速 SLAM 系統,用于在機器人的板載 GPU 上運行的立體視覺慣性 SLAM。

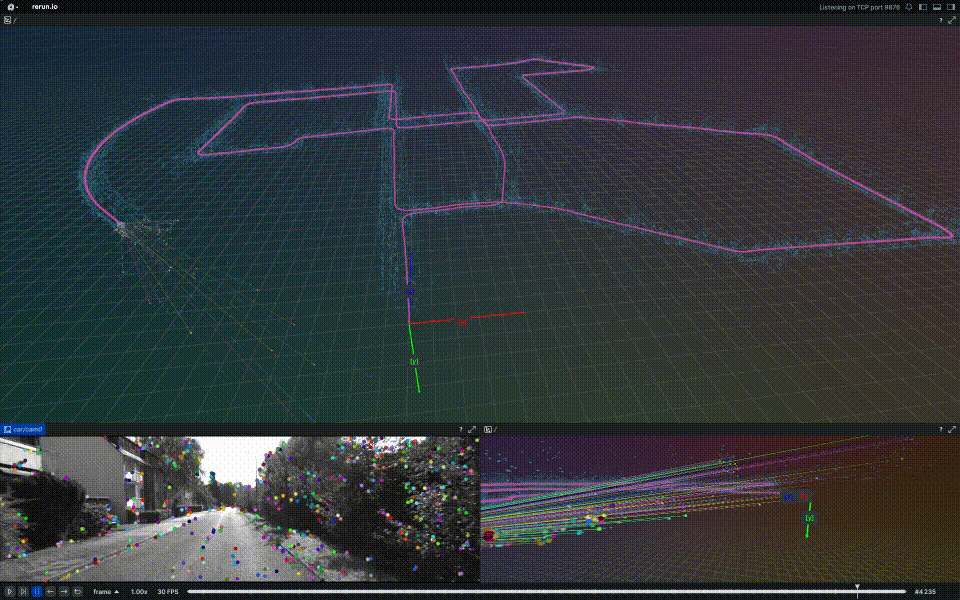

圖 2. 使用 cuVSLAM 生成的定位

對于更偏向使用 Python 的簡單性和通用性的開發者來說,利用強大而高效的 Visual SLAM 系統仍然是一項艱巨的任務。借助 PyCuVSLAM,開發者可以輕松地對 cuVSLAM 進行原型設計并將其用于應用,例如通過互聯網規模的視頻生成機器人訓練數據集。該 API 可以從第一人稱觀看視頻中估計自我攝像頭的位姿和軌跡,從而增強端到端決策模型。此外,將 cuVSLAM 集成到 MobilityGen 等訓練流程中,可以通過學習真實的 SLAM 系統錯誤來創建更穩健的模型。功能示例如圖 2 所示。

實時 3D 映射

圖 3. 上圖顯示了使用 nvblox_torch 構建的重建,左下角展示了將視覺基礎模型特征融合到 3D voxel grid 中的過程,這是表示場景語義內容的常用方法。

右下角顯示了從重建中提取的 3D 距離場切片

nvblox_torch 是一個易于使用的 Python 接口,用于 nvblox CUDA 加速重建庫,允許開發者輕松地對用于操作和導航應用的 3D 地圖構建系統進行原型設計。

空間記憶是機器人完成較長距離任務的核心能力。機器人通常需要推理場景的幾何和語義內容,其中場景的空間范圍通常大于單個攝像頭圖像所能捕獲的空間范圍。3D 地圖將多個視圖中的幾何和語義信息聚合為場景的統一表示。利用 3D 地圖的這些特性可以提供空間記憶,并支持機器人學習中的空間推理。

nvblox_torch 是一個 CUDA 加速的 PyTorch 工具箱,用于使用 RGB-D 攝像頭進行機器人映射。該系統允許用戶在 NVIDIA GPU 上將環境觀察結果與場景的 3D 呈現相結合。然后,可以查詢此 3D 表示形式的數量,例如障礙物距離、表面網格和占用概率(請見圖 3)。nvblox_torch 使用來自 PyTorch 張量的零復制輸入/ 輸出接口來提供超快性能。

此外,nvblox_torch 還添加了深度特征融合這一新功能。此功能允許用戶將視覺基礎模型中的圖像特征融合到 3D 重建中。隨后,生成的重建將同時表示場景的幾何圖形和語義內容。3D 基礎模型特征正在成為基于語義的導航和語言引導操作的熱門表示方法。nvblox_torch 庫中現已提供此表示方法。

6-DoF 物體位姿追蹤和新物體的 3D 重建

以物體為中心的感知也同樣重要:了解場景中的物體是什么、它們在哪里以及它們如何移動。FoundationPose 和 BundleSDF 這兩個項目解決了 6-DoF 物體位姿估計和追蹤的挑戰,其中也包括機器人以前從未見過的物體。

FoundationPose 是一種基于學習的方法:它是用于 6D 物體位姿估計和跟蹤的統一基礎模型,適用于基于模型和無模型的場景。這意味著同一系統可以處理已知對象(如果有可用的 CAD 模型)或全新對象(僅使用少量參考圖像),而無需重新訓練。FoundationPose 通過利用神經隱式表示來合成物體的新視圖來實現這一點,有效地彌合了完整 3D 模型與僅有稀疏觀察之間的差距。

它在大規模合成數據上進行訓練(借助基于 LLM 的數據生成工作流等技術),具有強大的泛化能力。事實上,只要提供最少的信息,比如模型或圖像,就可以在測試時即時應用于新對象。這種基礎模型方法在位姿基準測試中實現了最出色的準確性,在保持對新物體的零樣本能力的同時,性能優于專門方法。

圖 4. FoundationPose 在機器人機械臂中的應用

BundleSDF 采用在線優化驅動的方法來解決此問題,提供了一種近實時 (~ 10 Hz) 方法,用于從 RGB-D 視頻中同時進行 6-DoF 位姿追蹤和神經 3D 重建。它僅假設第一幀中的分割;之后不需要先驗 CAD 模型或類別知識。

BundleSDF 的關鍵是并發學習的 Neural Object Field,一種神經隱式 SDF,可在觀察時捕獲物體的幾何圖形和外觀。當物體移動時,BundleSDF 會使用過去的幀不斷優化位姿圖,隨著時間的推移優化位姿軌跡和形狀估計。位姿估計與形狀學習的集成可有效解決大型位姿變化、遮擋、低紋理表面和鏡面反射等挑戰。在交互結束時,機器人可以擁有一致的 3D 模型并追蹤動態獲取的位姿序列。

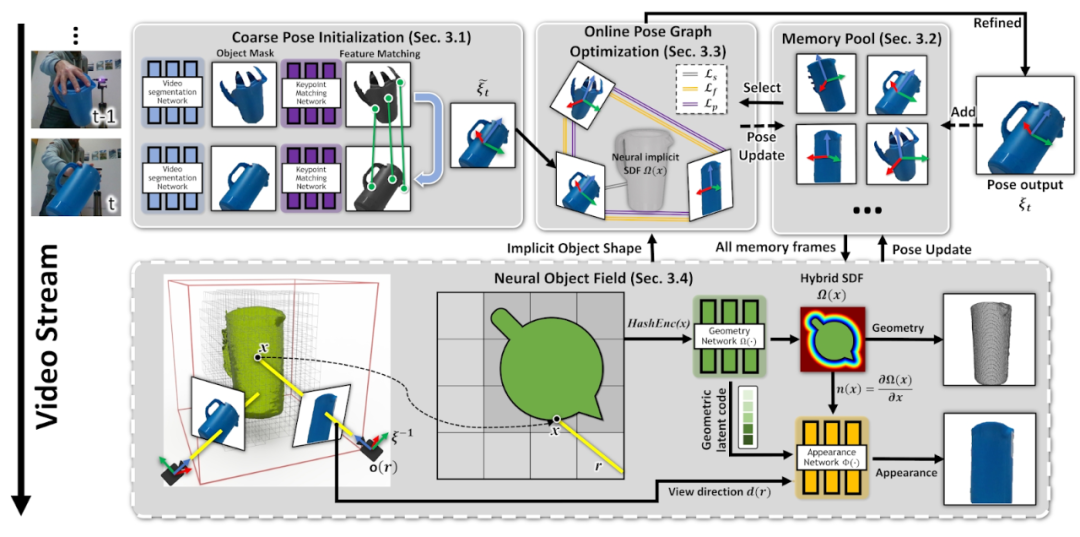

該框架概述如圖 5 所示。首先,在連續圖像之間匹配特征以獲得粗略的位姿估計 (Sec. 3.1),一些位姿幀存儲在內存池中一遍后續進行優化 (Sec. 3.2),根據池中的一個子集動態創建位姿圖 (Sec. 3.3),在線優化會細化圖中的所有位姿以及當前位姿,更新的位姿存儲回池中。最后,池中的所有位姿幀在單獨的線程中,學習 Neural Object Field,用于對幾何和視覺紋理進行建模 (Sec. 3.4),同時調整之前估計的位姿。

圖 5. BundleSDF 框架,該框架使用內存增強的位姿圖來估計和優化視頻流中的 3D 物體位姿,

并學習幾何圖形和外觀的神經物體表示

FoundationPose 和 BundleSDF 都強調了對象級 3D 理解在機器人開發中的重要性。機器人如果需要抓取或操控任意物體,必須能夠感知物體的 3D 位置和方向(位姿),通常還需要感知其形狀。這些項目展示了兩條互補的路徑:預訓練的基礎模型,通過學習廣泛的先驗來泛化到新對象;以及用于構建自定義模型的對象的在線 neural SLAM 。在實踐中,這些功能甚至可以協同工作,例如,基礎模型可以提供初步猜測,然后通過在線重建進行改進。機器人正在朝著新物體的實時 6D 感知發展,而不是局限于識別一組固定的已知物體。

基礎模型:跨任務的泛化和統一

更多的機器人感知系統利用基礎模型,即只需極少調整即可跨任務泛化的大型神經網絡。這在 FoundationStereo 和 FoundationPose 中很明顯,它們分別為立體深度估計和 6D 物體位姿追蹤提供了強有力的基準。

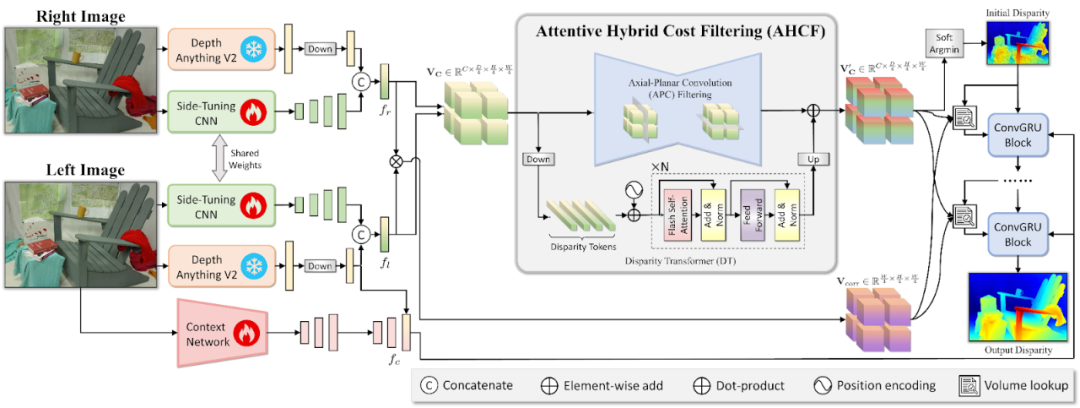

FoundationStereo 將之前于 DepthAnythingV2 的側調整單目深度整合到立體模型框架中,無需重新訓練即可增強魯棒性和域泛化。它在各種環境中使用超過 100 萬個合成立體對進行訓練,在 Middlebury、KITTI 和 ETH3D 數據集等基準測試中實現了先進的零樣本性能。該模型改進了成本體積編碼器和解碼器,增強了遠程差異估計。

在圖 6 中,Side-Tuning Adapter (STA) 利用來自凍結的 DepthAnythingV2 的豐富單目先驗,以及來自多級 CNN 的詳細高頻特征來提取一元特征。Attentive Hybrid Cost Filtering (AHCF) 將 Axial-Planar Convolution (APC) 過濾與 Disparity Transformer (DT) 模塊相結合,在 4D 混合成本體積中有效聚合跨空間和差異維度的特征。根據此過濾后的成本量預測初始差異,并使用 GRU 塊進行細化。每個優化階段都會使用更新后的差異從過濾后的混合成本體積和相關體積中查找特征,從而指導下一個優化步驟,并產生最終的輸出差異。

圖 6. 通過 AHCF 從輸入圖像到輸出差異的 FoundationStereo 流

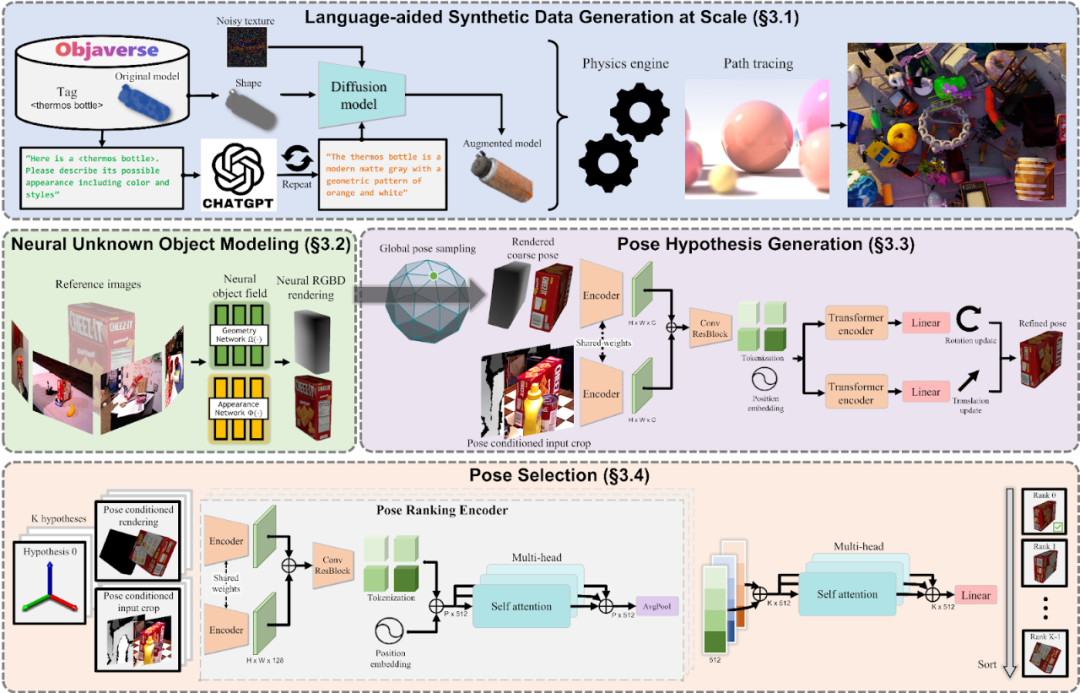

FoundationPose 是一個統一模型,用于對新物體進行單幀 6D 位姿估計和多幀位姿追蹤。它通過學習物體幾何圖形的神經隱式表示,支持基于模型和基于圖像的推理。它使用 CAD 模型或一些 RGB 引用泛化到不可見的對象。它基于大語言模型生成的大型合成數據集進行訓練,包括各種任務提示和場景變體。

FoundationPose 利用對比訓練和基于 Transformer 的編碼器,在 YCB-Video、T-LESS 和 LM-OCC 等基準測試中的表現明顯優于 CosyPose 和 StablePose 等特定任務基準。圖 7 展示了 FoundationPose 的工作原理。為了減少大規模訓練的人工工作量,我們使用新興技術和資源(包括 3D 模型數據庫、LLMs 和 diffusion models)創建了合成數據生成工作流 (Sec. 3.1)。為了將無模型設置和基于模型的設置連接起來,我們使用 object-centric neural field (Sec. 3.2),用于新穎的視圖 RGB-D 渲染和渲染與比較。對于位姿估計,我們會在物體周圍均勻地初始化全局位姿,并通過 refinement network 進行優化 (Sec. 3.3)。最后,我們將優化后的位姿發送到位姿選擇模塊,以預測其分數,并選擇具有最佳分數的姿勢作為輸出 (Sec. 3.4)。

圖 7. 該工作流通過結合神經渲染、細化和位姿假設排序來生成合成訓練數據并估計物體位姿

這些模型共同標志著機器人技術在構建統一可復用感知主干的道路上邁出了關鍵一步。通過將深度和物體幾何的通用先驗知識嵌入實時系統,機器人能夠在零樣本場景中(包括訓練未涉及的環境中以及從未見過的物體交互場景)實現可靠性能,隨著機器人技術朝著更具適應性的開放世界部署發展,基礎模型提供了在通用感知框架內支持廣泛任務所需的靈活性和可擴展性。

邁向集成式 3D 感知堆棧

這些項目共同指向一個統一的 3D 感知堆棧,其中深度估計、SLAM、物體追蹤和重建作為緊密集成的組件運行。FoundationStereo 可提供可靠的深度,cuVSLAM 可跟蹤攝像頭位姿以進行實時定位和映射,而 BundleSDF 和 FoundationPose 可處理物體級理解,包括 6-DoF 追蹤和形狀估計,即使是未見過的物體也不例外。

通過基于 foundation models 和神經 3D 表征構建,這些系統實現了通用的實時感知,支持在復雜環境中進行導航、操作和交互。機器人技術的未來在于這種集成堆棧,其中感知模塊共享表示和上下文,使機器人能夠以空間和語義意識進行感知、記憶和行動。

總結

本期 R2D2 探討了立體深度估計、SLAM、物體位姿跟蹤和 3D 重建等領域的最新進展,以及如何融合到統一的機器人 3D 感知堆棧中。這些工具大多由基礎模型驅動,使機器人能夠實時理解環境并與之交互,即使面對新物體或陌生場景也能應對自如。

-

機器人

+關注

關注

213文章

29664瀏覽量

212413 -

NVIDIA

+關注

關注

14文章

5292瀏覽量

106156 -

AI

+關注

關注

88文章

34916瀏覽量

277941 -

模型

+關注

關注

1文章

3512瀏覽量

50285

原文標題:R2D2:利用 NVIDIA 研究中心的研究成果,構建 AI 驅動的 3D 機器人感知與地圖構建系統

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

物聯網、AR、3D打印、機器人未來將改變我們的生活?

走到哪都不會迷路,全自動機器人是怎么導航的?

Voxel 3D 飛行時間傳感器機器人視覺參考設計

基于Arduino的3D打印2輪機器人

基于VSLAM的移動機器人三維定位與地圖構建

抓取作業機器人3D視覺系統的設計

INDEMIND 3D語義地圖構建技術在機器人上的應用

機器人如何構建3D語義地圖?

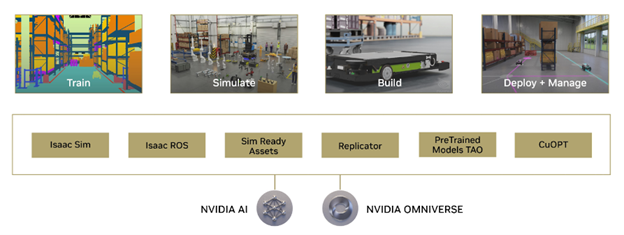

NVIDIA Isaac 平臺先進的仿真和感知工具助力 AI 機器人技術加速發展

利用NVIDIA Isaac平臺構建、設計并部署機器人應用

基于NVIDIA AI的3D機器人感知與地圖構建系統設計

基于NVIDIA AI的3D機器人感知與地圖構建系統設計

評論