人工智能,尤其是深度學習是一種正在改變?nèi)藗兩畹脑S多方面的計算技術。深度學習的算法需要大量的數(shù)據(jù)。數(shù)量確實取決于算法和生成的網(wǎng)絡模型的目標,但對于一些復雜的模式來說,它可能會運行數(shù)億的輸入集合。

人工智能是計算領域的熱門話題之一,并且有著充分的理由。深度學習(DL)中的新技術在某些問題上有能力創(chuàng)建比人類精確度更好的神經(jīng)網(wǎng)絡。圖像識別是深度學習(DL)模型如何在識別圖像中的對象(對象檢測和分類)方面實現(xiàn)比人類準確性更好的一個例子。

ImageNet競賽就是一個例子。自2010年以來,ImageNet大規(guī)模視覺識別挑戰(zhàn)(ILSVRC)已被用作圖像識別改進的衡量標準。在2011年,其錯誤率約為25%(該工具可以正確識別培訓數(shù)據(jù)集之外的75%的圖像)。2012年,深度神經(jīng)網(wǎng)絡(DNN)的錯誤率降低到16%。在接下來的幾年里,其錯誤率將降至個位數(shù)。在2017年,36支參賽團隊中有29人的失誤率低于5%,這通常要比人類識別做的更好。

深度學習使用各種類型的神經(jīng)網(wǎng)絡,可應用于各種各樣的問題。創(chuàng)建深度學習模型通常有兩個主要步驟:第一步就是所謂的訓練。這是讓模型重復讀取輸入數(shù)據(jù)集,并調整模型參數(shù)以最小化錯誤(正確輸出與計算輸出之間的差異)的過程。這一步需要大量的輸入,需要極端大量的計算量。

第二步發(fā)生在模型訓練后,稱之為推理。這是訓練模型在生產(chǎn)中的部署。生產(chǎn)意味著該模型可用于讀取未用于培訓的數(shù)據(jù)。它產(chǎn)生用于某個任務的輸出,而不是訓練神經(jīng)網(wǎng)絡。這一步也有一個計算組件。它不需要大量計算,它需要實現(xiàn)諸如最小化延遲、最佳可能精度,最大化吞吐量,以及最大化能源效率等目標。

用于執(zhí)行這兩個步驟的計算的軟件由框架完成。這些軟件工具和數(shù)據(jù)庫可以讀取通常用Python編寫的腳本,告訴框架需要什么樣的操作以及神經(jīng)網(wǎng)絡是什么樣的。該代碼然后由框架讀取,然后執(zhí)行。框架的例子有Tensorflow、Caffe或PyTorch。

有關IO模式的問題

通過研究深度學習(DL)框架的功能,可以了解IO模式。人們不需要知道具體框架的細節(jié),也不需要了解神經(jīng)網(wǎng)絡背后的數(shù)學知識。

深度學習(DL)框架中訓練步驟的基本流程非常簡單。神經(jīng)網(wǎng)絡需要相當多的輸入數(shù)據(jù)來正確訓練網(wǎng)絡來執(zhí)行任務。它可以是圖像、視頻、音量、數(shù)字或幾乎任何數(shù)據(jù)的組合。

人們需要大量的數(shù)據(jù)。此外,其數(shù)據(jù)必須非常多樣化,并為每個輸入提供廣泛的信息。例如,確定某人是男性還是女性的簡單面部識別需要超過1億張圖像。

輸入數(shù)據(jù)能夠以各種方式進行存儲,從簡單的csv文件中獲取真正少量的輸入數(shù)據(jù),以便了解深度神經(jīng)網(wǎng)絡(DNN)的數(shù)據(jù)庫,以及包含圖像的數(shù)據(jù)庫。只要深度神經(jīng)網(wǎng)絡(DNN)可以訪問數(shù)據(jù)并理解輸入格式,數(shù)據(jù)也可以分布在不同的格式和工具中。它也可以是結構化和非結構化數(shù)據(jù)的組合,只要用戶知道數(shù)據(jù)和格式,并且可以在模型中表達這些數(shù)據(jù)和格式即可。

存儲介質上的數(shù)據(jù)大小可能會有所不同。在極端情況下,來自MNIST數(shù)據(jù)集的簡單圖像是28×28灰度圖像(值從0到255)。總共有784個像素,這格式非常小。如今人們擁有4K分辨率的電視機和相機。這將是4,096 x 4,096像素,總共16,777,216個像素。

4K色彩表示通常以8位(256個選擇)開始,或者可以達到16位信息。這可能導致非常大的圖像。如果將一個4K圖像制作為分辨率為4520 x 2540和8位的單個未壓縮的tiff文件,則其大小為45.9 MB。而對于16位色的圖像來說,其大小為91.8 MB。

如果組織擁有1億張圖片,對于一些面部識別算法來說是合理的,組織擁有這么多文件,這對當今的文件系統(tǒng)來說并不算太壞。在8位圖像情況下使用的總空間是4.59 PB。對于使用大型高分辨率圖像的單個神經(jīng)網(wǎng)絡(NN)來說,這是相當大的空間。

一般來說,神經(jīng)網(wǎng)絡在訓練網(wǎng)絡時有兩個階段。第一階段稱為前饋。它接受輸入并通過網(wǎng)絡進行處理。輸出與正確的輸出進行比較以產(chǎn)生錯誤。然后通過網(wǎng)絡傳播這個錯誤(反向傳播)來調整網(wǎng)絡的參數(shù),以便希望減少網(wǎng)絡產(chǎn)生的錯誤。

這個過程繼續(xù)進行,以便所有圖像通過網(wǎng)絡進行處理。這被稱為epoch(迭代次數(shù),1個epoch等于使用訓練集中的全部樣本訓練一次)。培訓一個網(wǎng)絡達到所需的性能水平可能需要數(shù)百、數(shù)千或數(shù)萬個epoch。深度學習框架(例如Tensorflow或Caffe或PyTorch)負責用戶創(chuàng)建的網(wǎng)絡模型的整個過程。

整體IO進程

深度學習的IO模式的簡要概述是數(shù)據(jù)一次又一次地被讀取。深度學習經(jīng)常重復讀取(重讀)。請注意讀取一些文字,但與閱讀相比,它的工作量是很小的,因為它主要是在神經(jīng)網(wǎng)絡訓練期間檢查指向。但是,為了改進神經(jīng)網(wǎng)絡訓練,可以使用一些影響IO模式的選項。

作為讀取或寫入數(shù)據(jù)量的示例,在此假設網(wǎng)絡需要1億張圖像,其中每張圖像為45.9 MB。此外,假設網(wǎng)絡模型需要大約40MB來保存,并且每100個epoch保存一次,并且需要5000個epoch來訓練模型。

如前所述,一個epoch需要讀取4.59 PB的數(shù)據(jù)。這需要重復5000次。這總共需要讀取22.95EB的數(shù)據(jù)。如果每個圖像是單個文件,它還需要讀取500億個文件。

對于寫入IO,模型需要寫入50次。這是總共2 GB和50個寫入。與讀取相比,其工作量是非常小的。

對于這個例子,總共有459個PB執(zhí)行了100億個讀取IO。隨后是40MB的寫入IO。整個IO模式總共重復50次。

這是面向識別應用的深度神經(jīng)網(wǎng)絡(DNN)的基本IO模式。為了減少訓練時間,可以使用幾種技術。以下的主題是從IO角度對這些技術進行快速概述。

訓練技巧

神經(jīng)網(wǎng)絡(NN)訓練中使用的第一種技術是輸入數(shù)據(jù)的隨機混洗。幾乎所有的時間都用它來減少所需的歷元(參考的時刻點)并防止過擬合(優(yōu)化模型到數(shù)據(jù)集,但是模型在現(xiàn)實世界的數(shù)據(jù)上表現(xiàn)不佳)。

在新的epoch開始之前,數(shù)據(jù)讀取的順序是隨機的。這意味著讀取的IO模式是基于每個圖像的隨機數(shù)。在閱讀個人圖像時是連續(xù)的,但在圖像之間是隨機的。因此,由于隨機性,將模式表征為“重讀”而非“讀取”是困難的。

也有可以從數(shù)據(jù)庫中讀取數(shù)據(jù)的框架。IO模式的讀取仍然非常繁重,可能會隨機對數(shù)據(jù)進行混洗。這可能會使IO模式的細節(jié)更加復雜化,因為數(shù)據(jù)庫位于內(nèi)存和框架之間。

有時框架也會使用IO的mmap()函數(shù)。這是一個將文件或設備映射到內(nèi)存的系統(tǒng)調用。當將虛擬內(nèi)存區(qū)域映射到文件時,它被稱為“基于文件的映射”。讀取某些內(nèi)存區(qū)域將會讀取文件。這是默認行為。

無論是否使用mmap(),IO模式仍然是重讀的,遵循以上討論的模式。然而,使用mmap()會使分析復雜化,因為IO直接從文件到內(nèi)存。

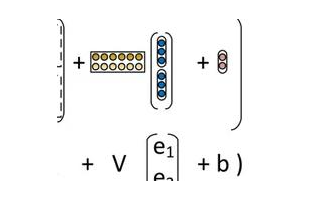

另一種常用的提高訓練性能的技術稱為批處理。在每個輸入圖像(包括向前和向后傳播)之后更新網(wǎng)絡,而不是在輸入“批量”圖像之后更新網(wǎng)絡。網(wǎng)絡的反向傳播部分對錯誤進行操作,例如對它們進行平均,以更新網(wǎng)絡參數(shù)。這通常不會改變IO模式,因為圖像仍然需要被讀取,但它可能會影響收斂速度。一般來說,它可以減緩收斂速度,但后向傳播的發(fā)生較少,提高了計算速度。

在使用GPU(圖形處理單元)進行訓練時,使用批處理還有助于提高性能。批處理不是將文件從CPU移動到GPU,而是允許用戶將多個文件復制到GPU。這可以提高從CPU到GPU的吞吐量,并減少數(shù)據(jù)傳輸時間。以這個例子為例,批處理大小為32將減少數(shù)據(jù)傳輸?shù)?125000個傳輸?shù)臄?shù)量。

批處理確實有助于收斂,但不會真正影響IO模式。該模式仍然是隨機讀取,寫入很少。但它可以改變框架創(chuàng)建的輸出量。

數(shù)據(jù)存儲與深度學習

人工智能,尤其是深度學習是一種正在改變?nèi)藗兩畹脑S多方面的計算技術。深度學習的算法需要大量的數(shù)據(jù)。數(shù)量確實取決于算法和生成的網(wǎng)絡模型的目標,但對于一些復雜的模式來說,它可能會運行數(shù)億的輸入集合。通常,用于訓練模型的數(shù)據(jù)越多,數(shù)據(jù)越多樣化,最終訓練的模型就越好。這指向非常大的數(shù)據(jù)集。

在以往,有人討論數(shù)據(jù)將變得越來越冷。這意味著在創(chuàng)建數(shù)據(jù)后,很少再次使用它。而人們通過檢查數(shù)據(jù),包括工程和企業(yè)數(shù)據(jù),并發(fā)現(xiàn)了一些非常有趣的趨勢:

?這兩種工作負載都更加面向寫入。讀寫字節(jié)比率已顯著下降(從4:1到2:1)

?相對于只讀和只寫訪問模式,讀寫訪問模式增加了30倍。

?文件很少重新打開。超過66%只重開一次,95%少于五次。

?文件很少重新打開。

?研究期間超過90%的活動存儲空間未被使用。

?一小部分客戶占文件活動的很大一部分。不到1%的客戶占文件請求的50%。

而總結數(shù)據(jù)的總體使用非常容易。

?IO模式非常重視寫入。

?數(shù)據(jù)很少被重復使用,但仍然存在。

比較深入學習算法的IO模式,可以發(fā)現(xiàn)它與傳統(tǒng)工程師、HPC和企業(yè)應用程序的做法幾乎完全相反。深度學習非常重讀IO導向,數(shù)據(jù)在設計和訓練模型時被重復使用。即使在模型被訓練之后,仍然需要用新數(shù)據(jù)來增加現(xiàn)有的訓練數(shù)據(jù)集,特別是模型輸出中的誤差。這是為了隨著時間的推移對模型進行的改進。

-

IO

+關注

關注

0文章

490瀏覽量

40363 -

數(shù)據(jù)存儲

+關注

關注

5文章

997瀏覽量

51677 -

深度學習

+關注

關注

73文章

5557瀏覽量

122658

原文標題:數(shù)據(jù)存儲、人工智能和IO模式

文章出處:【微信號:D1Net08,微信公眾號:AI人工智能D1net】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

淺談示波器的存儲深度

數(shù)據(jù)存儲與文件IO后續(xù)資源包 Datalogging_FileIO

LabVIEW讀取示波器數(shù)據(jù)的存儲深度問題

淺談示波器的存儲深度

深度學習與數(shù)據(jù)挖掘的關系

IO擴展模式IO模式

示波器的變長存儲深度和分段存儲

什么是深度學習?使用FPGA進行深度學習的好處?

PLASTER:一個與深度學習性能有關的框架

為什么人工智能和深度學習的存儲很重要

什么是深度學習(Deep Learning)?深度學習的工作原理詳解

讀懂深度學習,走進“深度學習+”階段

有關IO模式的問題,數(shù)據(jù)存儲與深度學習

有關IO模式的問題,數(shù)據(jù)存儲與深度學習

評論