最近一期的計算機頂級期刊ACM Computing Surveys (CSUR)出版,包含了來自意大利比薩大學的研究人員發布的一篇構建機器學習可解釋性綜述論文《A Survey of Methods for Explaining Black Box Models》,詳細闡述了解釋黑盒機器學習模型的術語概念以及相關方法,是構建可解釋模型的重要指南。

近年來,許多準確的決策支持系統被構建為黑盒子,即向用戶隱藏其內部邏輯的系統。缺乏解釋性既是實際問題,也是道德問題。這篇綜述文獻報道了許多旨在克服這一至關重要弱點的方法,有時以犧牲準確性為代價來提升可解釋性。可以使用黑盒決策系統的應用是多種多樣的,并且每種方法通常被開發以提供針對特定問題的解決方案,并且因此,其明確地或隱含地描繪其自身對可解釋性的定義。

本文的目的是提供調研文獻中關于解釋概念和黑匣子系統類型的主要問題的分類。給定問題定義,黑匣子類型和所需解釋,此綜述應該有助于研究人員找到對他自己工作更有用的建議。所提出的黑匣子模型分類方法也應該有助于對許多研究開放性問題。

文章導讀

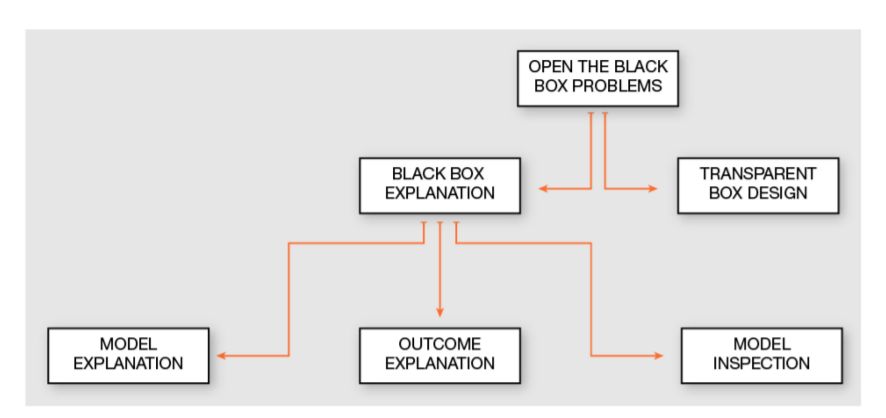

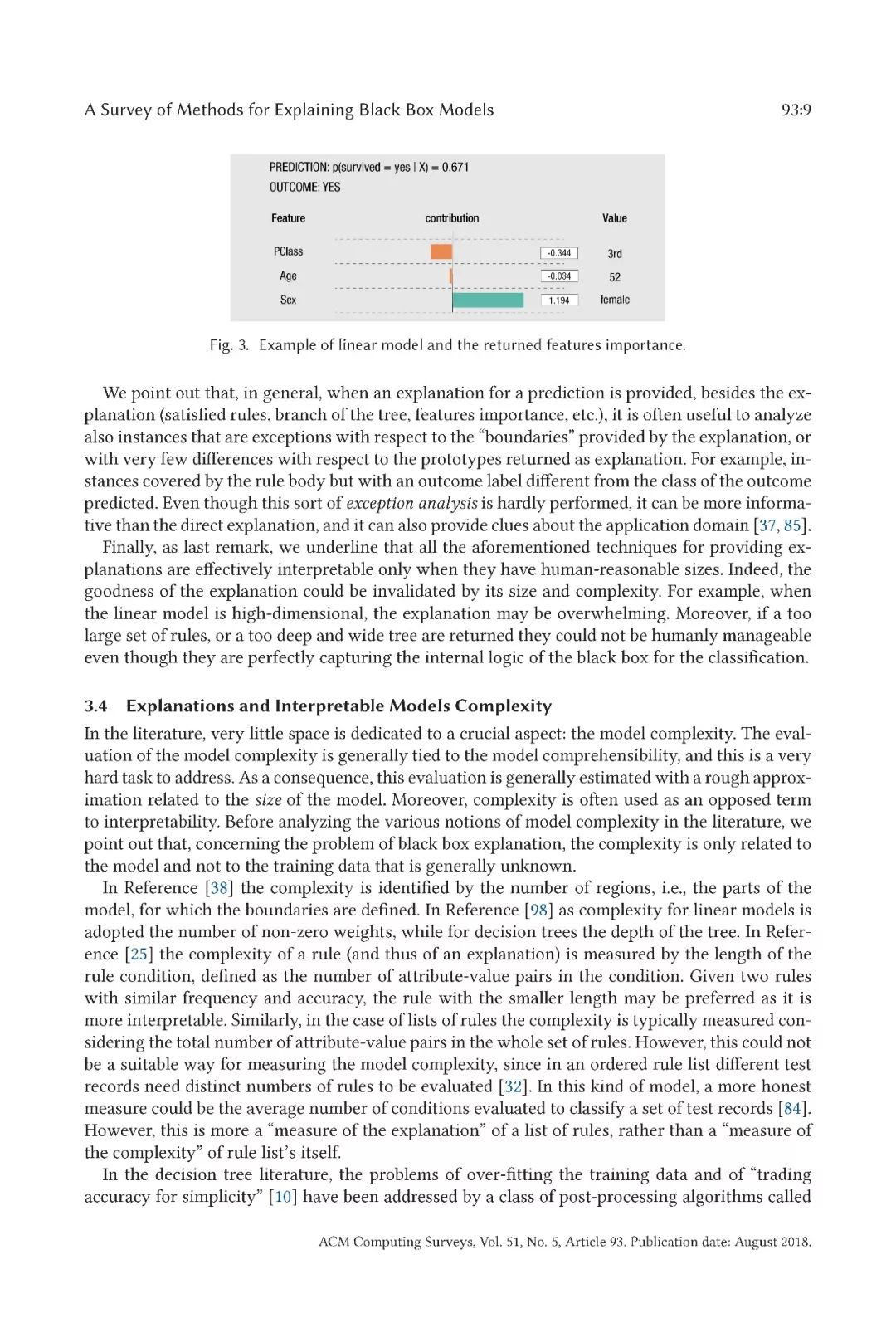

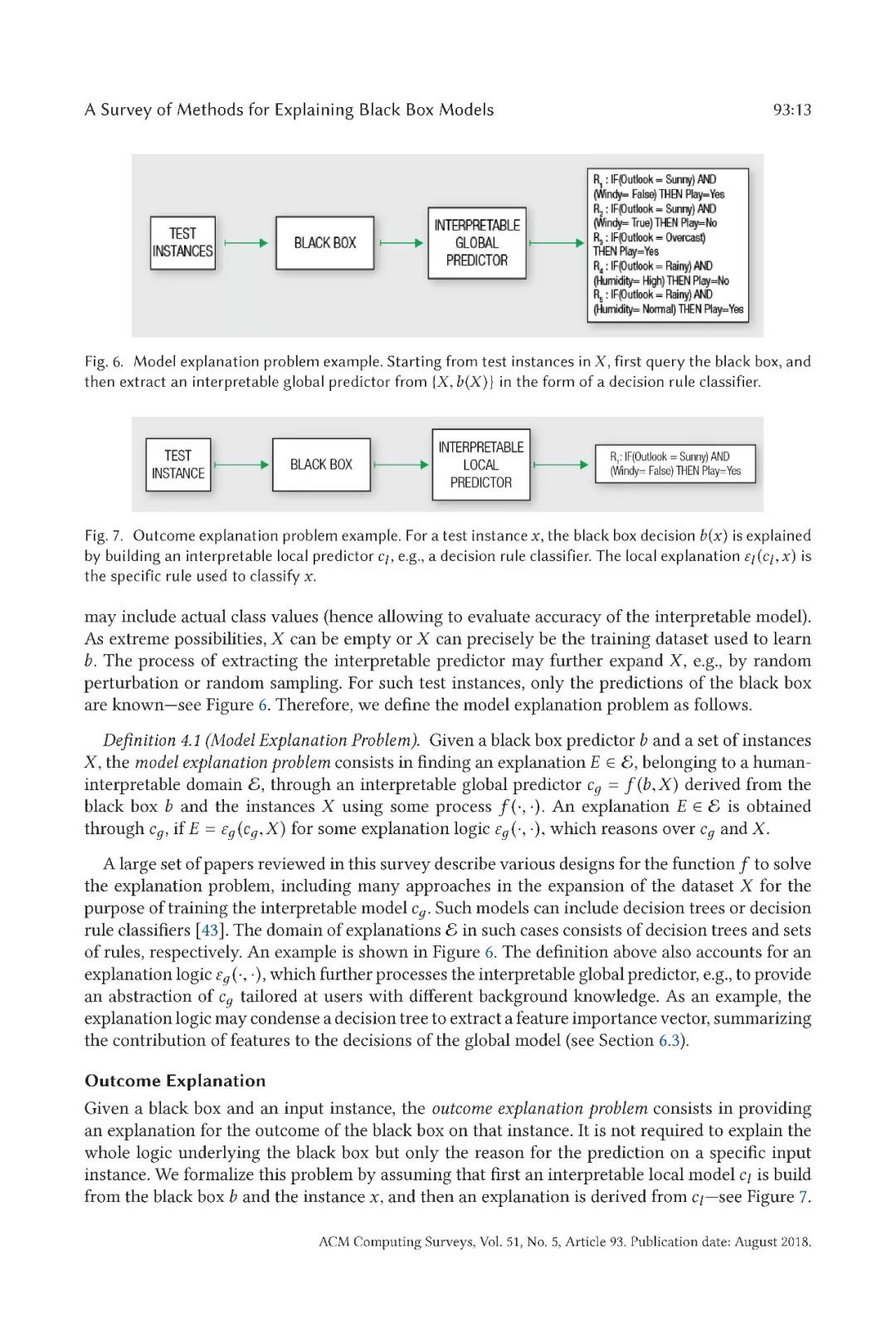

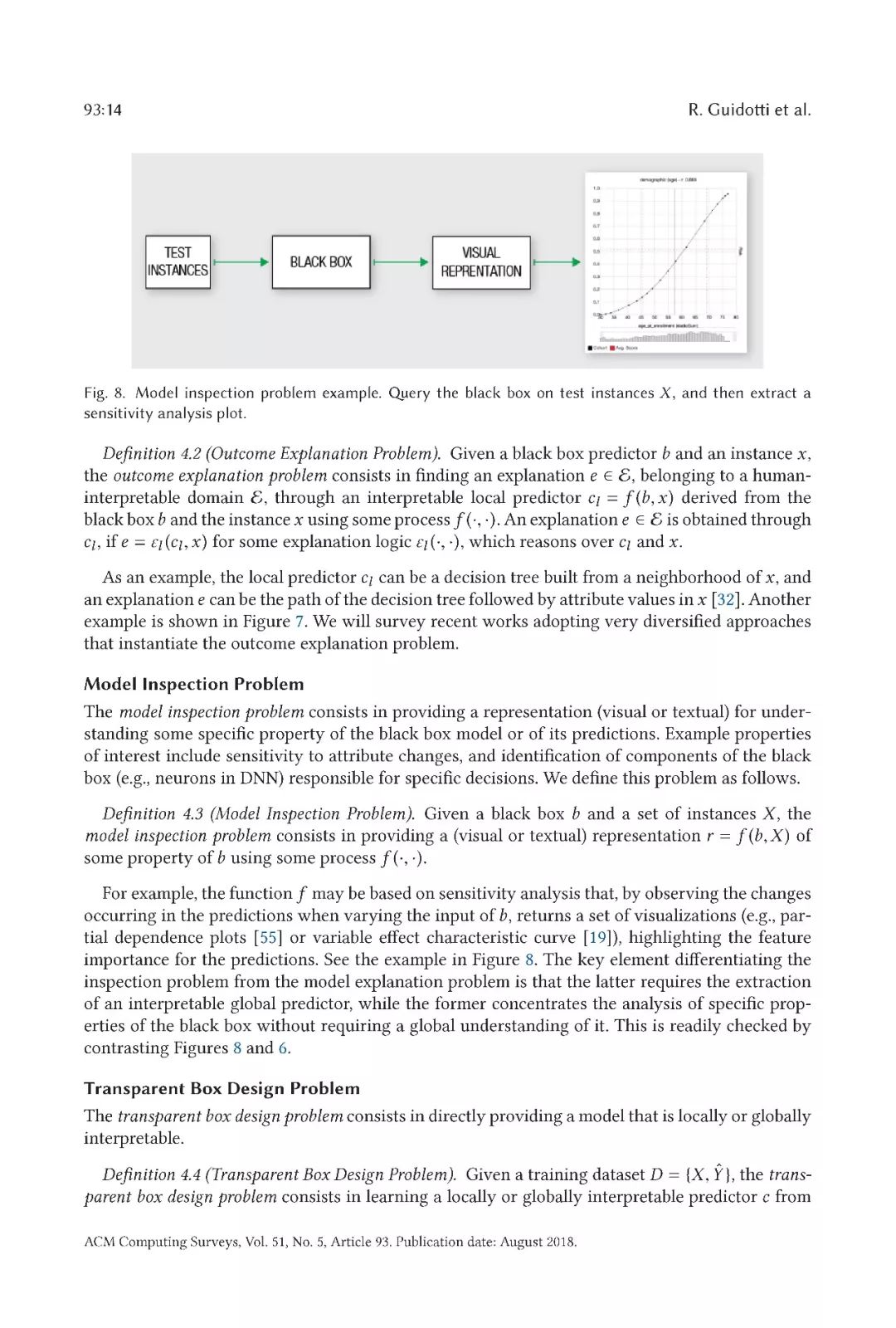

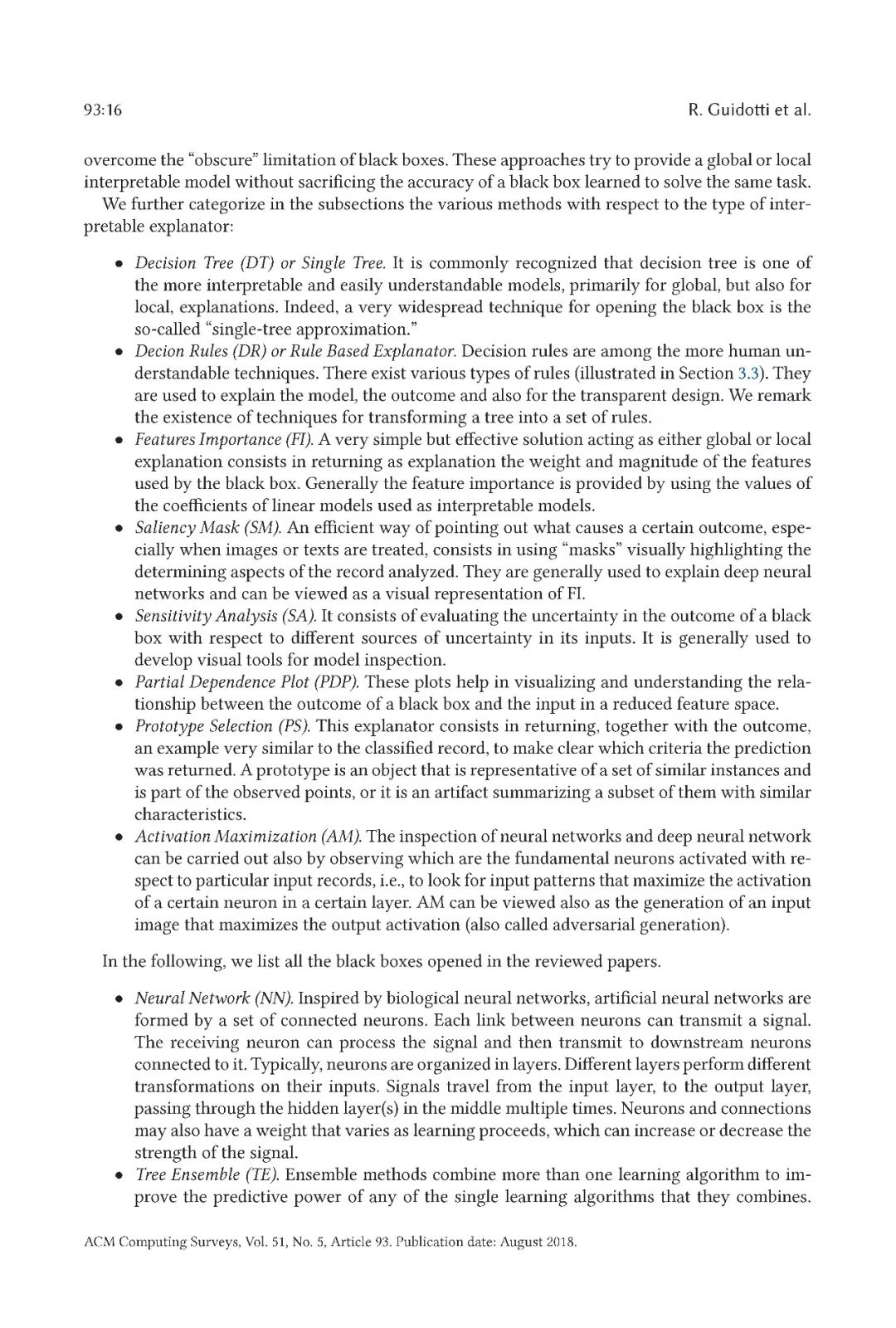

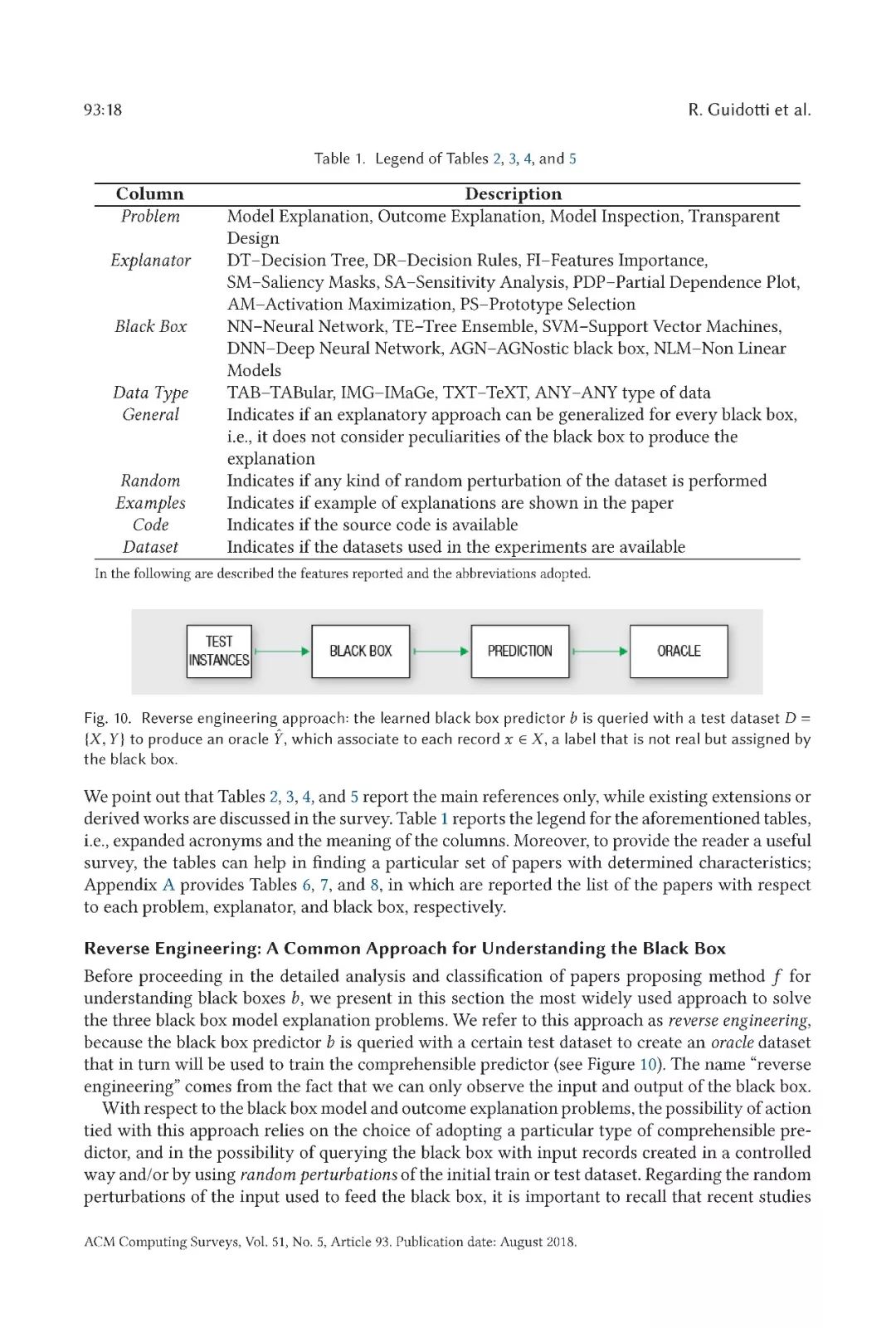

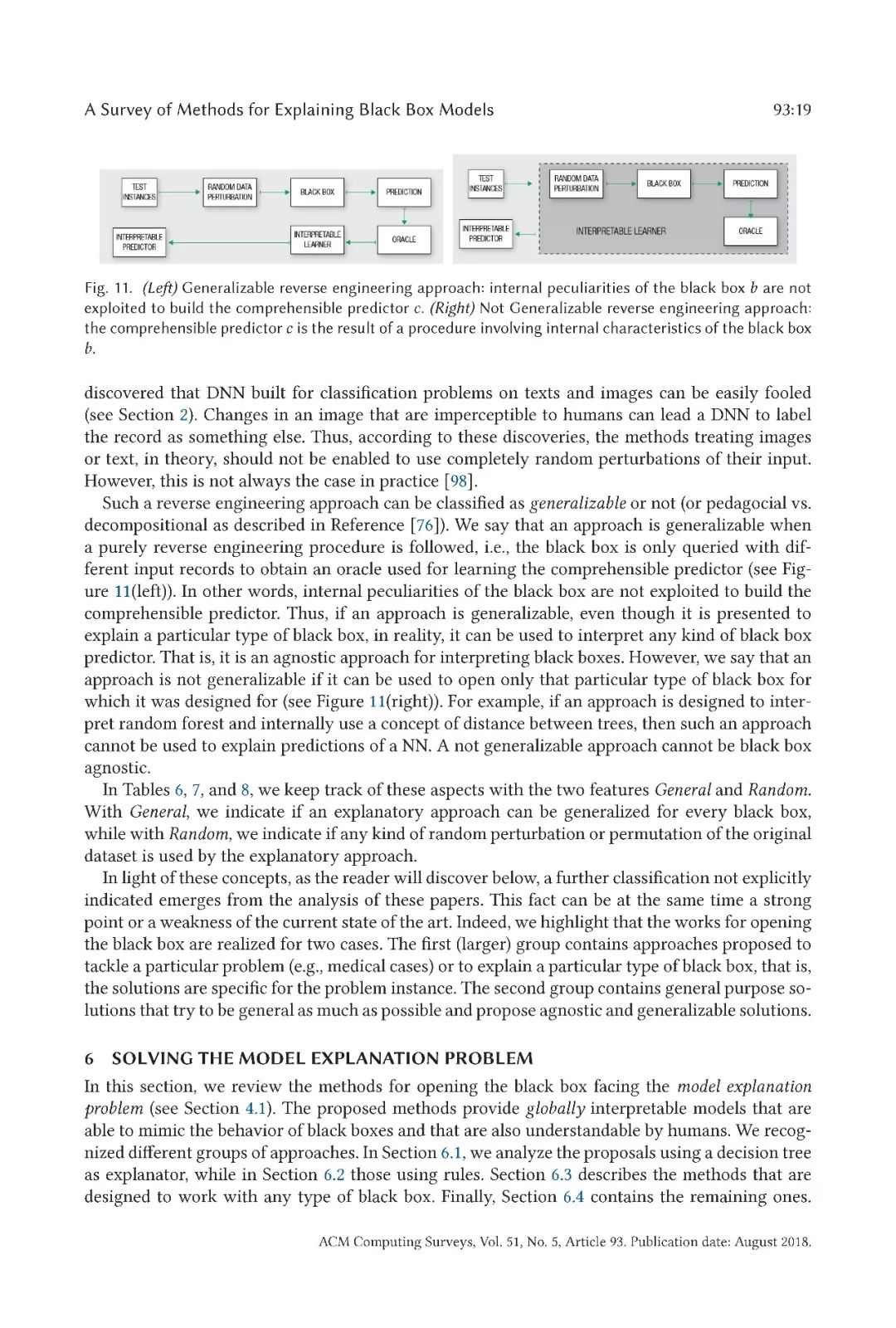

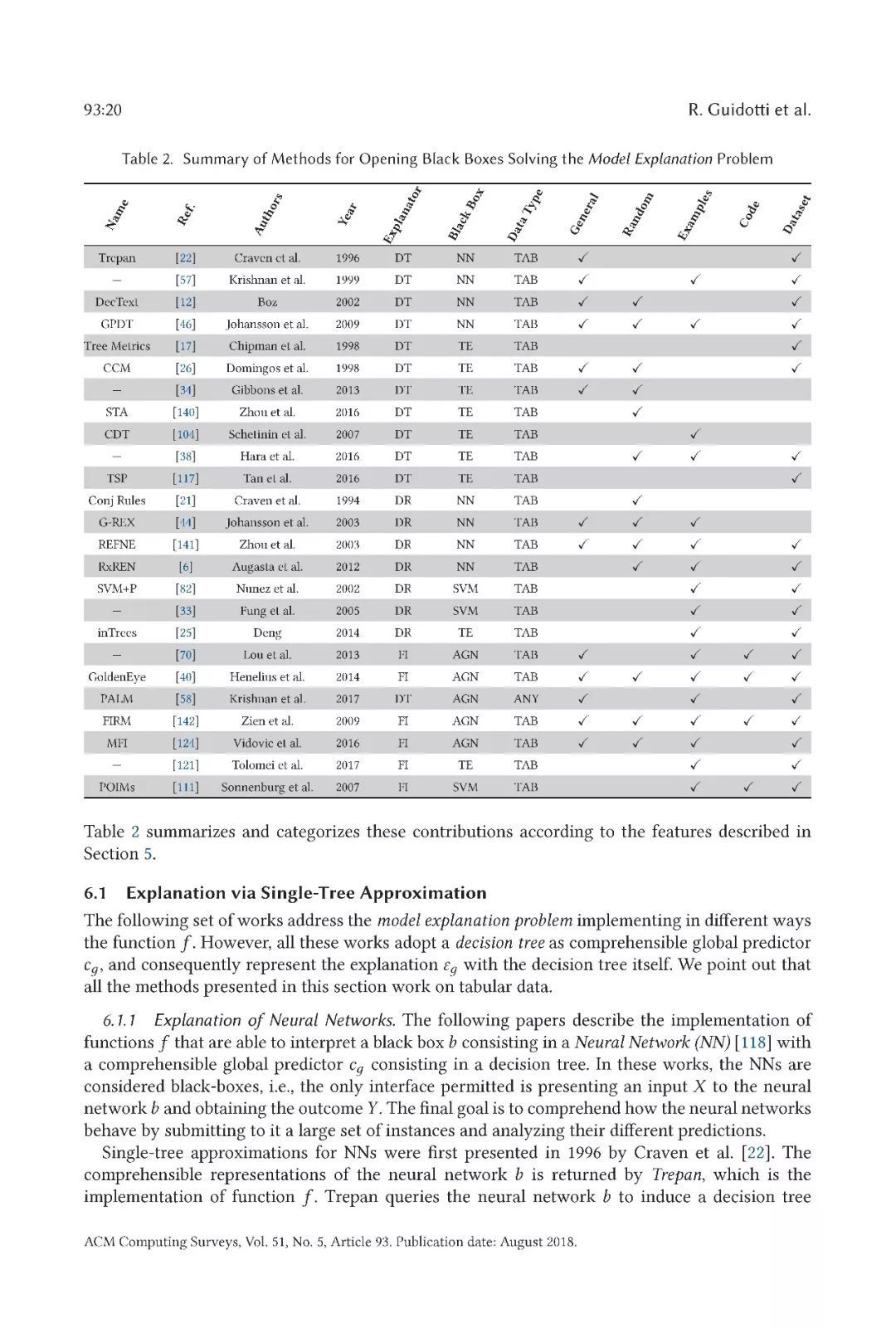

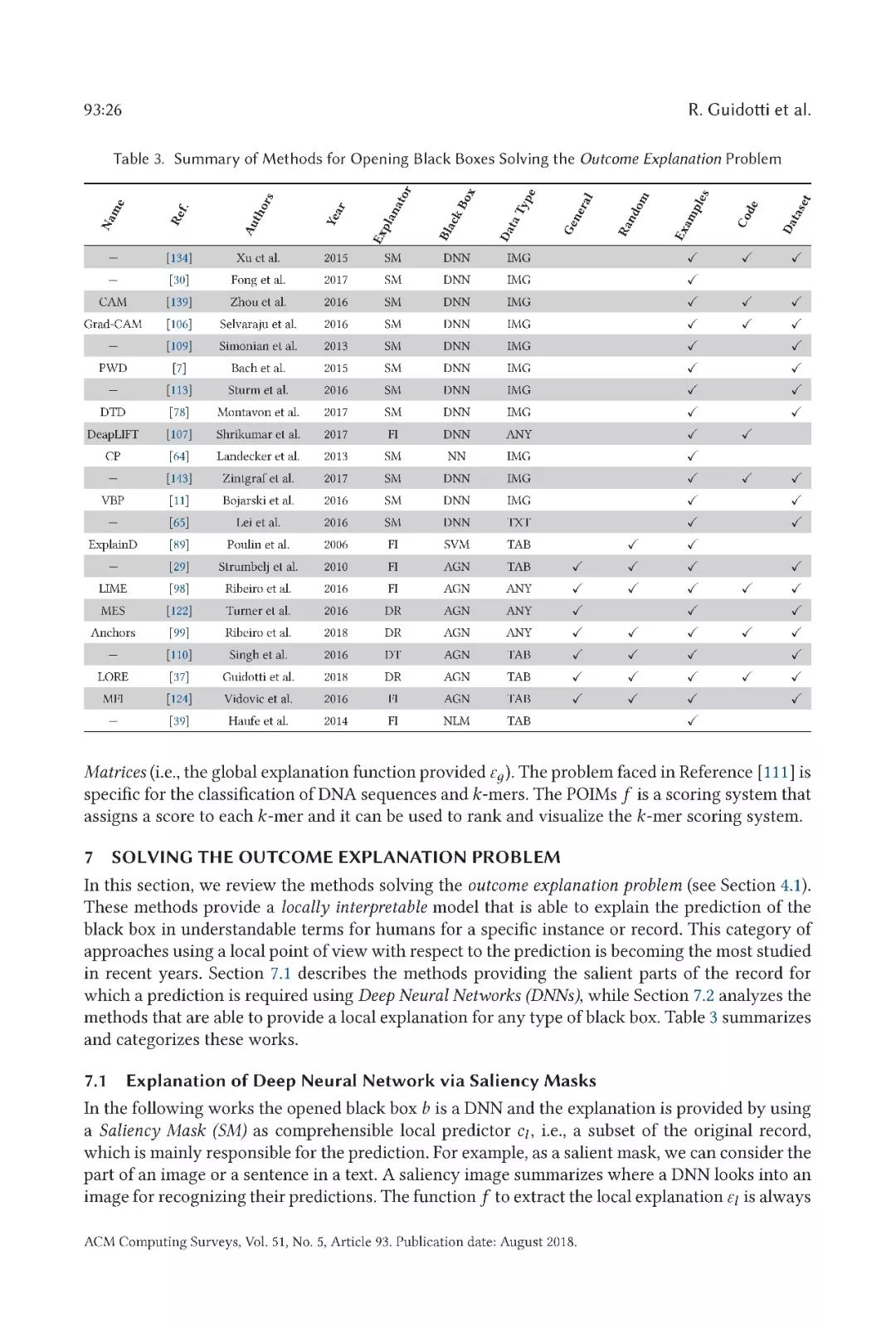

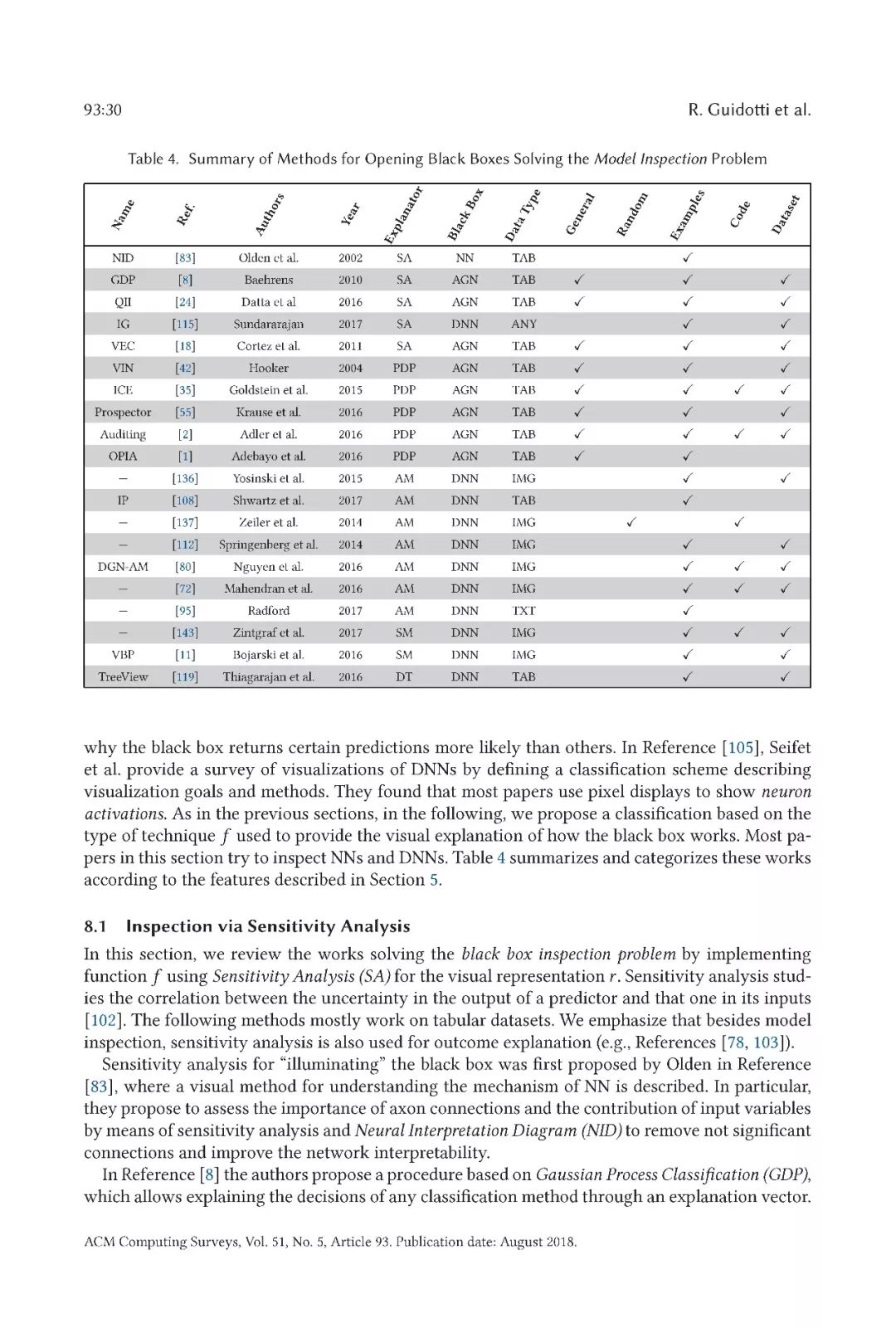

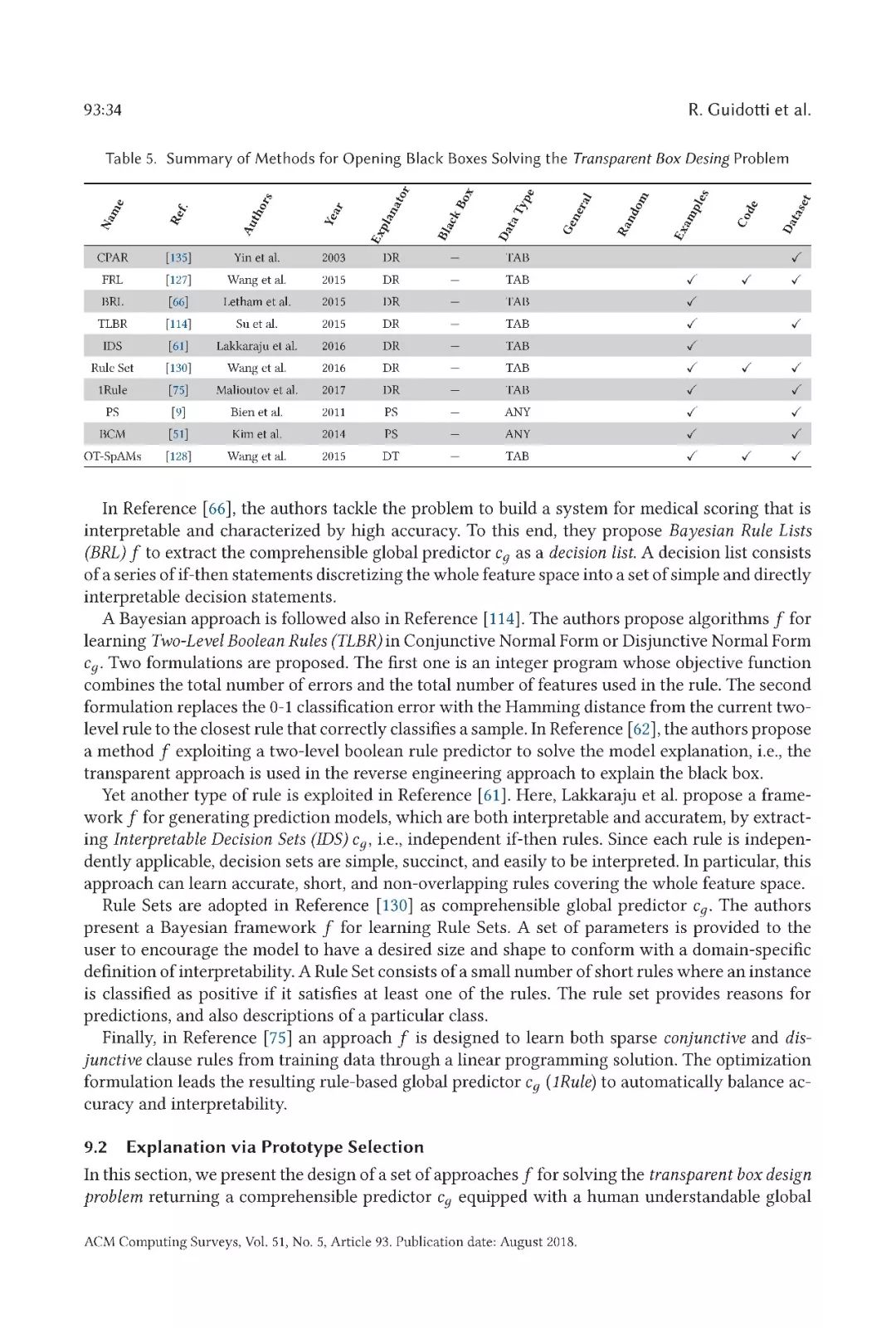

在本文中,我們對文獻中提出的用于解釋基于不透明和模糊機器學習模型的決策系統的方法進行了全面的概述。首先,我們確定了解釋問題的不同組成部分。特別是,我們提供了屬于該范疇的每個問題的正式定義,為每個問題捕獲了適當的特性。我們將這些黑箱問題命名為:模型解釋問題、結果解釋問題、模型檢查問題、透明箱設計問題。然后,我們提出了文獻中研究的方法的分類,這些方法考慮了以下幾個方面:解決的具體解釋問題,采用的解釋器的類型,打開的黑箱模型,以及黑箱模型輸入的數據的類型。

文章內容

-

黑匣子

+關注

關注

0文章

31瀏覽量

11397 -

機器學習

+關注

關注

66文章

8499瀏覽量

134329

原文標題:【干貨】爆款最新機器學習論文,揭秘黑盒子模型

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

機器學習模型可解釋性的結果分析

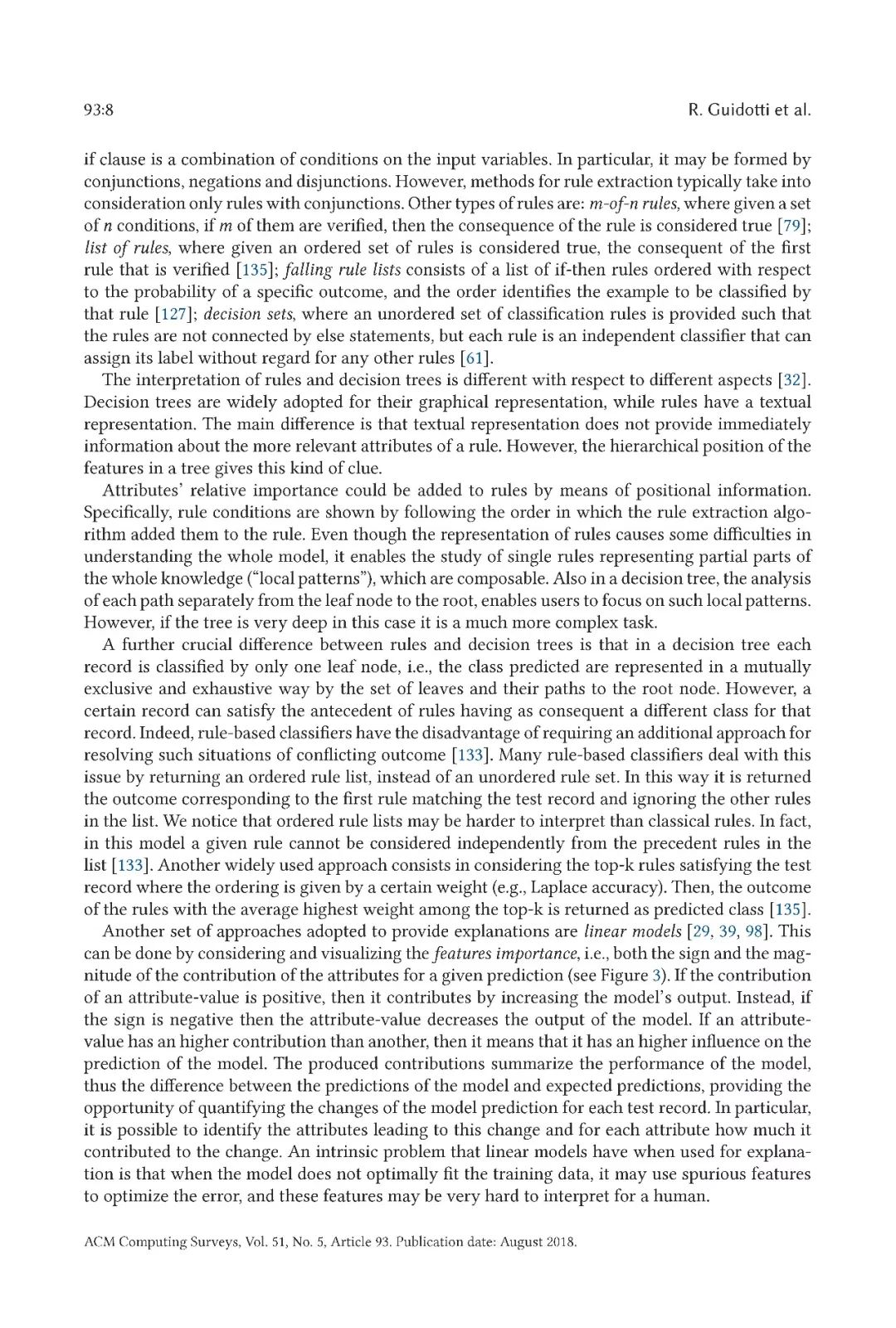

詳細闡述黑盒機器學習模型的術語概念以及相關方法

詳細闡述黑盒機器學習模型的術語概念以及相關方法

評論